Nginx

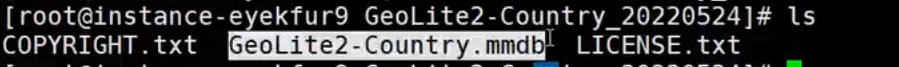

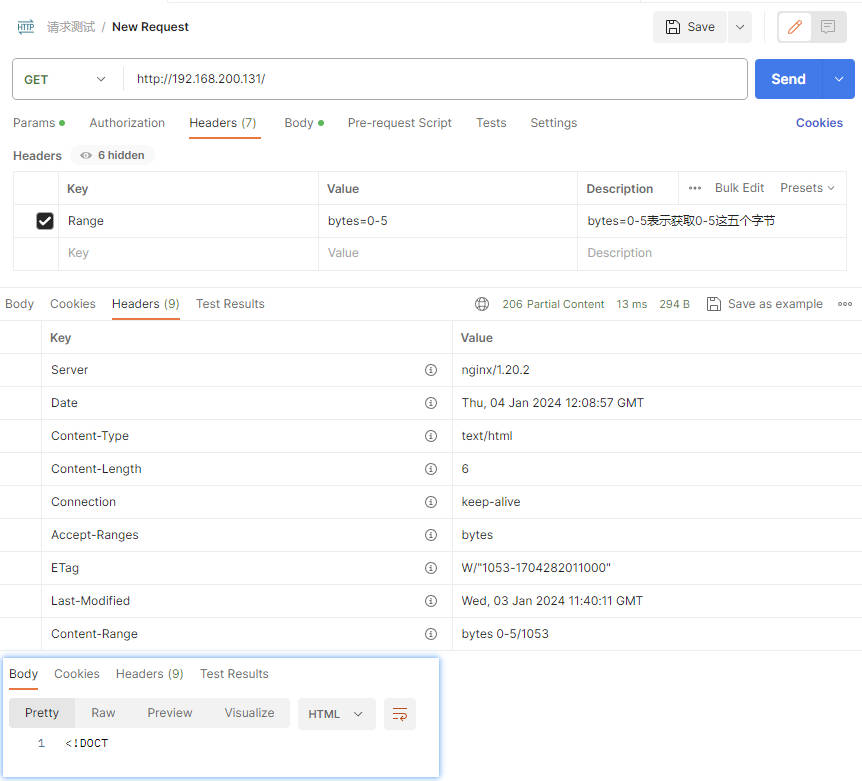

Nginx简介

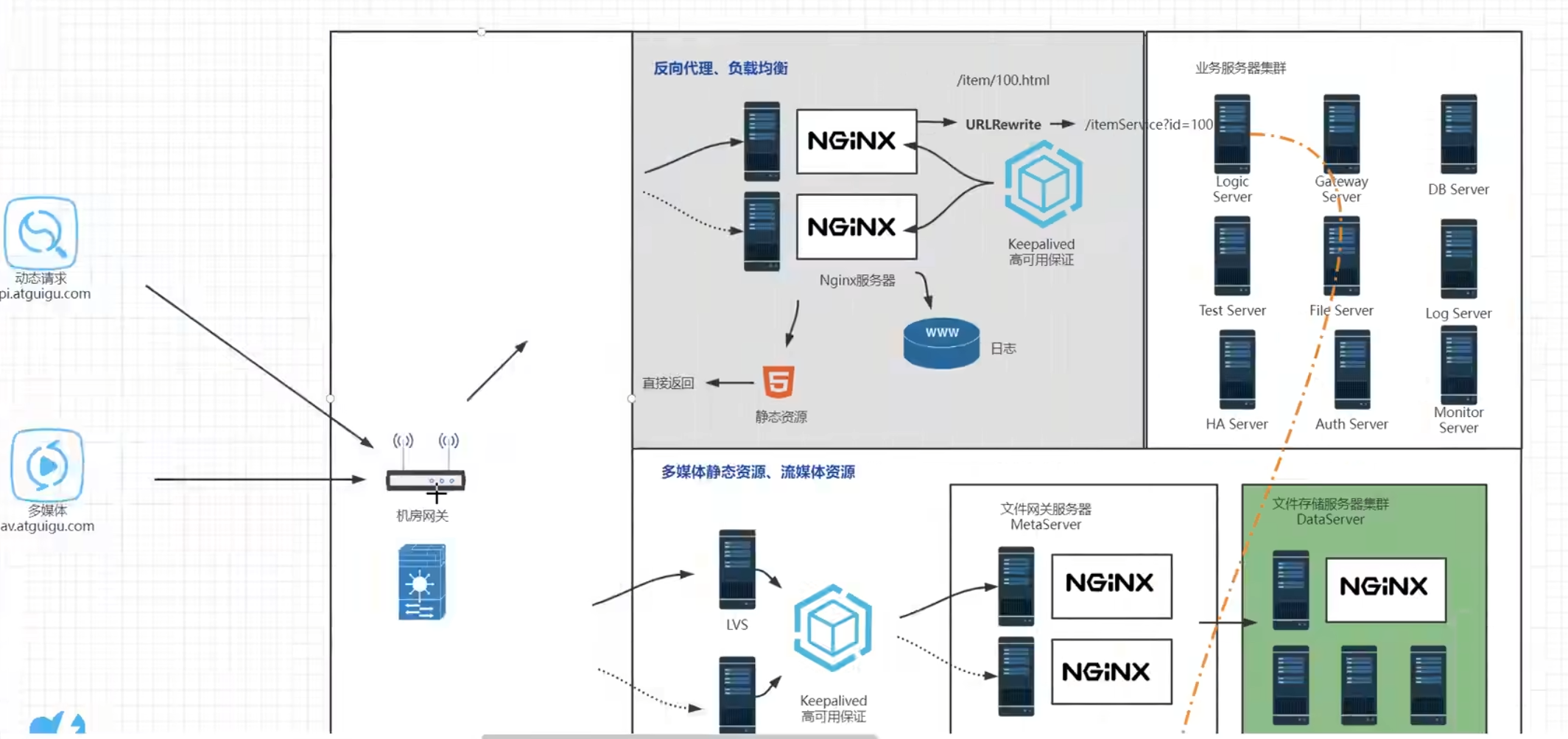

应用场景:在互联网项目中担任高性能服务器、负载均衡器,在大型系统架构担任高性能流量网关、应用网关、日志服务器、文件存储服务器等,支持模块化扩展和复杂功能的二次开发,通过简单调优就能高效提升系统性能

nginx是普通程序员进阶高程和架构师的捷径,nginx本身调优没啥用处,需要配合操作系统联动调优

nginx的官方文档:https://nginx.org/en/docs/,文档分为非常多的模块,官网中的很多配置,网上的文章都没有涉及,官方文档的解释有时候很模糊,很多时候表达都很模糊并且没有配备实际的场景

nginx官方中文文档:HttpGzip模块 | Nginx 中文官方文档 (gitbooks.io)

CentOS是linux发型版本中比较流行的版本,使用的redhat的linux内核,迷你版的linux系统非常干净,连网卡都没法用

使用命令

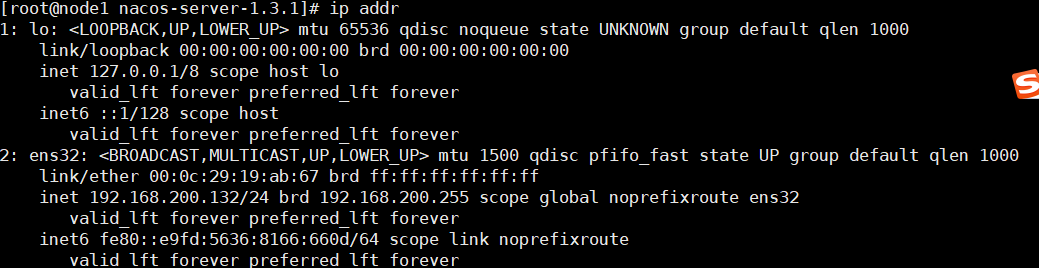

ip addr能够查看当前系统的ip环境,lo

Linux系统的Lo接口

在LINUX系统中,除了网络接口eth0,还可以有别的接口,比如lo(本地环路接口)。环回地址lo是主机用于向自身发送通信的一个特殊地址(也就是一个特殊的目的地址)。

本地回环地址指的是以127开头的地址(127.0.0.1 – 127.255.255.254),通常用127.0.0.1来表示。127.0.0.1,通常被称为本地回环地址(Loop back address),不属于任何一个有类别地址类。它代表设备的本地虚拟接口,所以默认被看作是永远不会宕掉的接口。

Lo接口的作用

通常在不安装网卡前就可以ping通这个本地回环地址。

一般都会用来检查本地网络协议、基本数据接口等是否正常的。测试本机的网络配置,能PING通127.0.0.1说明本机的网卡和IP协议安装都没有问题。

提供一个回环接口,很多需要网络的程序(比如mpd,xmms2),需要这个接口来通信。

Nginx的版本

Nginx常用的有四个发行版本,

Nginx开源版:http://nginx.org

最原始的版本,什么额外的功能都没有,主要功能就是成为网站服务器、代理服务器和负载均衡器,做二次开发难度大,需要集成很多的第三方组件,所以有很多公司对nginx在该版本的基础上做了加强

Nginx plus商业版:https://www.nginx.com

F5官方出品【F5是硬件厂商,专门做负载均衡器】,该版本对微服务和云原生的整合,对k8s的整合非常的好,但是收费

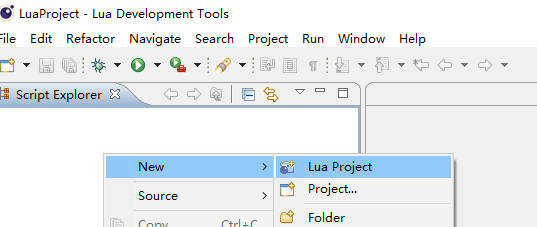

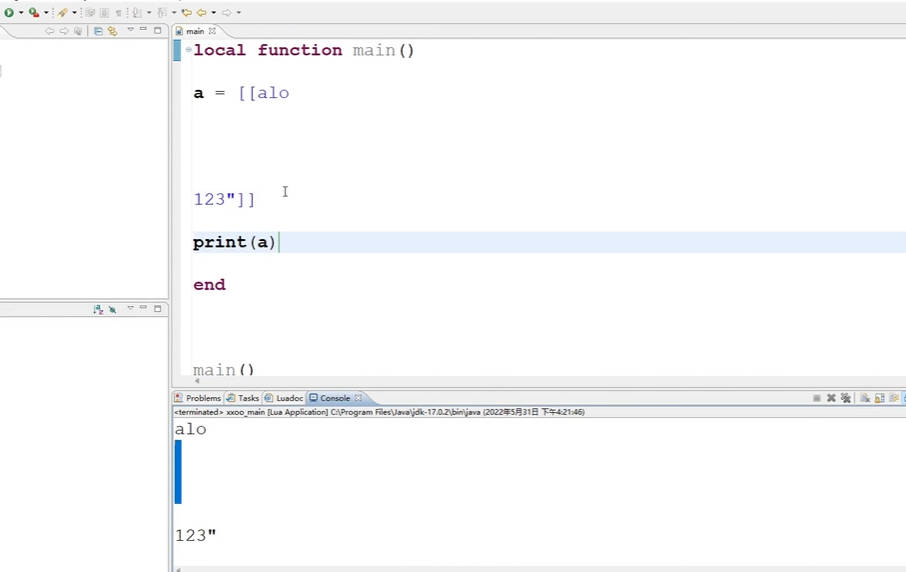

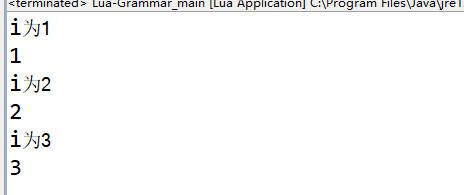

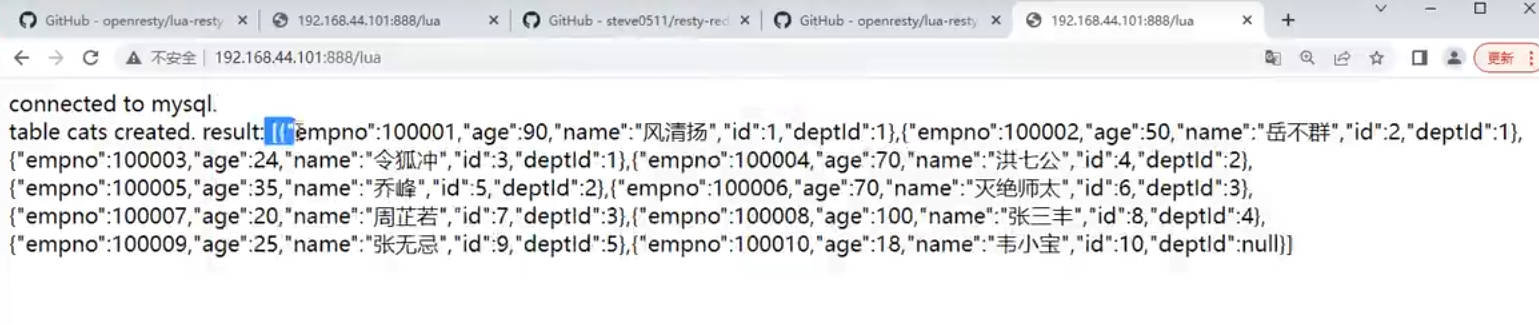

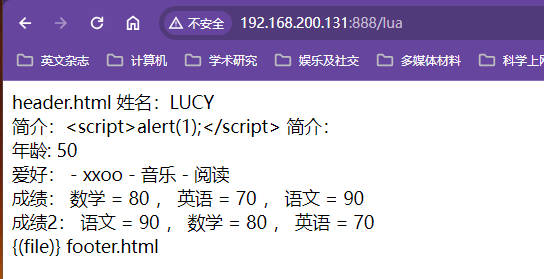

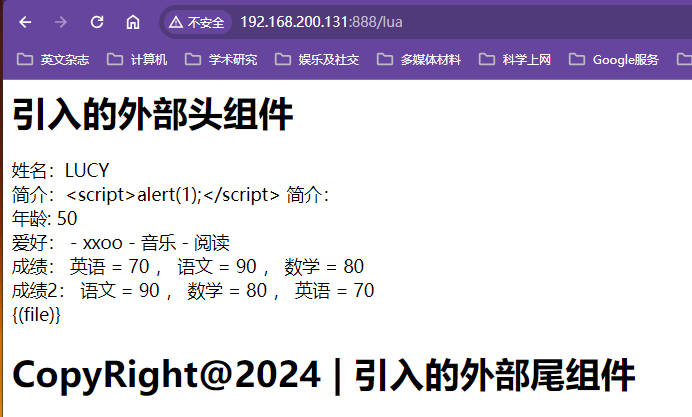

Openresty:http://openresty.org

免费开源,主要讲nginx和lua脚本进行了完美整合,Nginx Plus中的功能基本用户自己也可以进行开发,用lua脚本开发优雅高性能,代码难度小,也支持个性化定制,还有中文官网

Tengine:http://tengine.taobao.org

免费开源,没有二次开发的需求,只要求性能稳定,集群负载均衡、反向代理在原版基础上更安全、更稳定、性能更高可以使用tengine,这是淘宝开发出来的【相当于原版的增强】,以C语言的形式,模块化开发扩展原始nginx的功能

Nginx的安装

使用nginx1.20.2,安装包下载:http://nginx.org/en/download.html

安装步骤

基础部分学习使用最原始版本

将nginx的安装包

nginx-1.20.2.tar.gz上传到linux的/opt/nginx目录下使用命令

mkdir /usr/local/nginx创建/usr/local/nginx目录使用命令

tar -zxvf nginx-1.20.2.tar.gz解压文件到/opt/nginx目录进入解压目录,进入nginx解压文件,使用命令

./configure [--prefix=/usr/local/nginx]【--prefix是可选项,指定安装目录】尝试检查是否满足安装条件,期间会提示缺少的依赖,以下是需要依赖的安装成功安装的标志是没有报错

使用命令

yum install -y gcc安装c语言编译器gcc【-y是使用默认安装,不提示信息】使用命令

yum install -y pcre pcre-devel安装perl库【pcre是perl的库】使用命令

yum install -y zlib zlib-devel安装zlib库检查没有问题后执行命令

make进行编译执行

make install安装nginx

安装成功测试

使用命令

cd /usr/local/nginx进入nginx安装目录,查看是否有相应文件进入sbin目录,使用命令

./nginx启动nginx服务启动时会启动多个线程

使用命令

systemctl stop firewalld.service关闭防火墙服务虚拟机是内网上的机器,外网接不进来,关闭防火墙不一定意味着不安全,当然放行端口80更完美;学习过程不需要开启,生产的时候多数时候也不需要开启,除非机器有外网直接接入,或者公司比较大,要防外边和公司里的程序员,可能开启内部的监控和日志记录,一般中小型公司是不会开内网的防火墙的,因为有硬件防火墙或者云的安全组策略

使用请求地址

http://129.168.200.132:80访问nginxnginx的默认端口就是80端口,一定要关梯子进行访问,靠北

使用命令

./nginx -s stop快速停止nginx使用命令

./nginx -s quit在退出前完成已经接受的链接请求如用户下载文件,等用户下载完成后再停机,此时不会再接收任何新请求

使用命令

./nginx -s reload重新加载nginx配置可以让nginx更新配置立即生效而不需要重启整个nginx服务器,机制是执行过程中优雅停止nginx,保持链接,reload过程开启新的线程读取配置文件,原有线程处理完任务后就会被杀掉,加载完最新配置的线程继续杀掉线程的工作

此时启动nginx比较麻烦,需要使用nginx的可执行文件,意外重启的时候很麻烦,需要登录到控制台手动启动,将nginx安装成系统服务脚本启动就会非常简单

使用命令

vim /usr/lib/systemd/system/nginx.service创建服务脚本粘贴文本普通模式粘贴可能丢字符,插入状态粘贴就不会丢字符 WantedBy=multi-user.target 属于[install],shell脚本不能有注释,否则无法设置开机自启动

x[Unit]Description=nginx - web serverAfter=network.target remote-fs.target nss-lookup.target[Service]Type=forkingPIDFile=/usr/local/nginx/logs/nginx.pidExecStartPre=/usr/local/nginx/sbin/nginx -t -c /usr/local/nginx/conf/nginx.confExecStart=/usr/local/nginx/sbin/nginx -c /usr/local/nginx/conf/nginx.confExecReload=/usr/local/nginx/sbin/nginx -s reloadExecStop=/usr/local/nginx/sbin/nginx -s stopExecQuit=/usr/local/nginx/sbin/nginx -s quitPrivateTmp=true[Install]WantedBy=multi-user.target使用命令

systemctl daemon-reload重新加载系统服务并关闭nginx服务使用命令

systemctl start nginx.service用脚本启动nginx【启动前注意关闭nginx,避免发生冲突】使用命令

systemctl status nginx查看服务运行状态使用命令

systemctl enable nginx.service设置nginx开机启动nginx.service中的[Install]部分中的WantedBy=multi-user.target不能有注释,不能拼写错误,否则无法设置开机自启动

Nginx的基础用法

Nginx的目录结构

/usr/local/目录相当于windows的programfile目录,主要是为了方便管理

nginx的主要目录

其中以temp结尾的目录都是运行过程生成的临时文件

conf是核心配置文件的存放目录,里面放着nginx的主配置文件nginx.conf,该文件里面会引用其他的配置文件,

nginx中的一切几乎都可以配置,比如日志文件放在哪儿,日志记录的格式,日志文件的大小,包括pid以及存放位置都可以进行配置

html目录中放一些网页和静态资源,其中的index.html就是nginx正常启动访问80端口的欢迎页,这个目录在使用的过程中都会进行更改

logs目录用来记录日志,

acess.log是用户访问的日志【记录用户访问的时间、请求的文件、访问是否有附加的参数】,每个人的每次访问都会记录在其中,不能在让这个文件无限扩增,在配置文件中可以对文件大小和记录位置进行配置,不配置当记录到达磁盘大小时可能因为用户访问日志无法记录而出现各种莫名其妙的问题【磁盘满了内部无法记录日志而无限的报错】,此时配置可以限制日志文件大小并转移记录到其他文件当系统出现错误的时候会将用户访问错误信息和状态码记录到

error.log文件中niginx.pid是用于记录nginx运行的主进程id号,第二个数字1090就是nginx的主进程nginx: master的pid,这个进程号也可以配置

sbin目录只有nginx一个文件,作为nginx的主程序,用来启动nginx,也是nginx的主进程文件

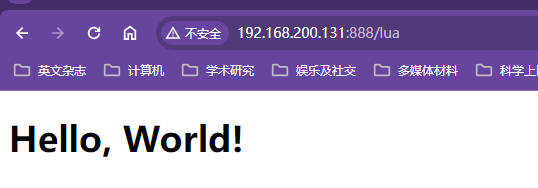

编辑nginx欢迎页

使用xftp可以在线以记事本的形式编辑文本文件

将index.html编写成"hello world"

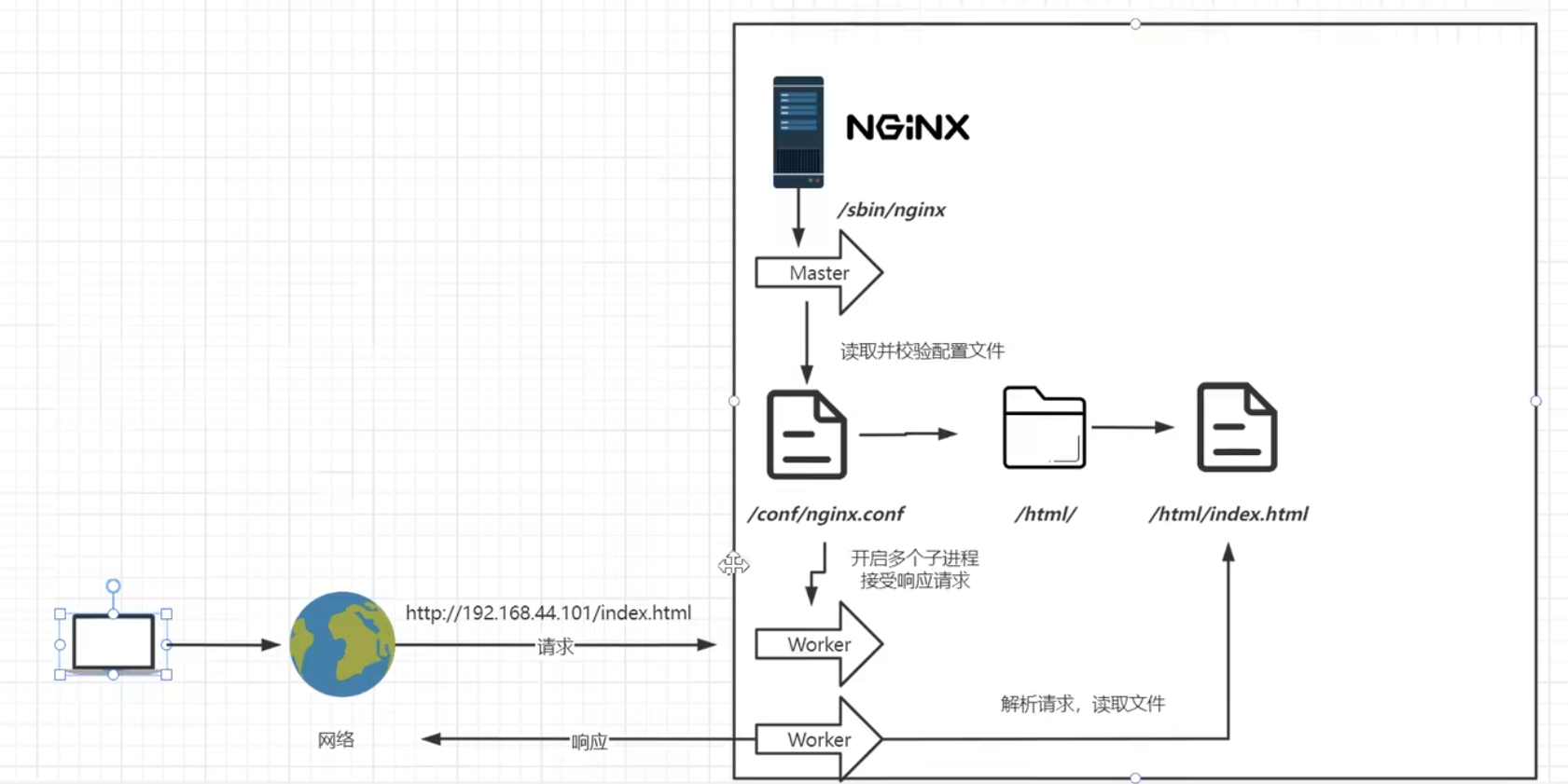

Nginx的运行原理

nginx的原理架构图

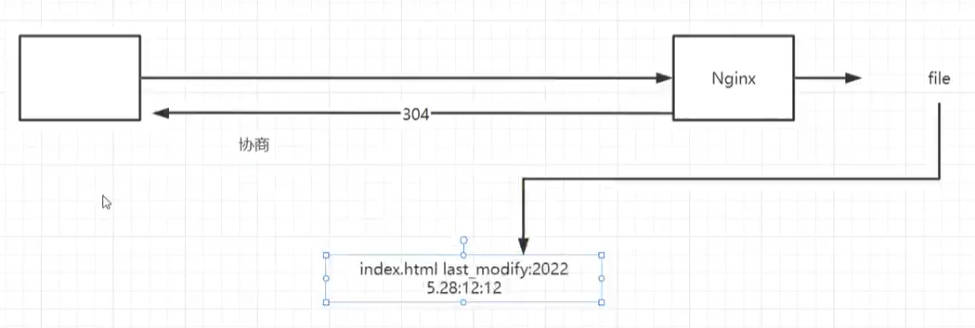

访问虚拟机也是通过网络请求由请求地址访问到的nginx

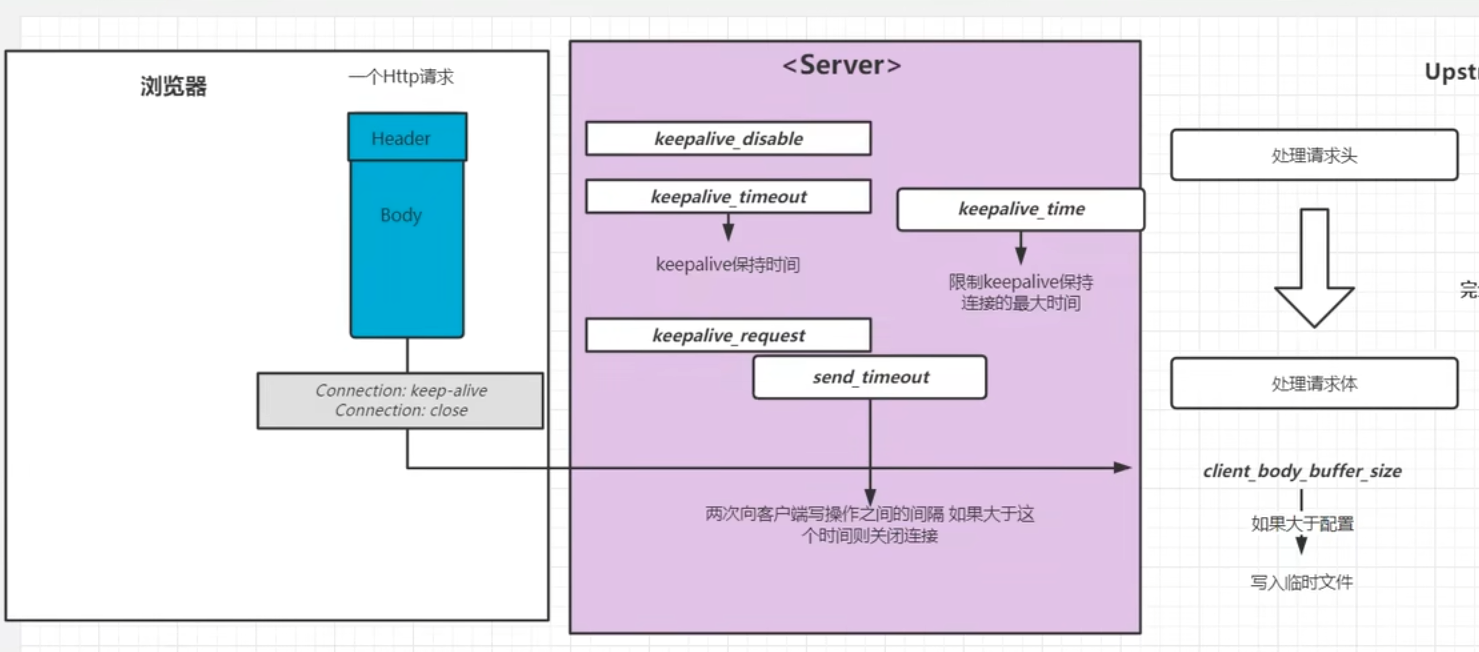

nginx的可执行文件运行后后开启一个master主进程,主进程会读取主配置文件,对配置文件做一次校验检查配置文件是否存在错误,没有错误会开启子进程worker;主进程不会处理业务,负责协调worker进程执行业务;【如配置文件更改后重新加载,会优雅的杀掉当前的worker进程,生产新的worker进程去读取新的配置文件接替旧的子进程的工作】

worker进程启动后会等待用户请求,worker通过解析配置文件判断用户请求是否能够处理,worker目录会去配置文件中查找当前存在哪些站点,并根据用户请求去获取对应的资源【即通过配置文件去html目录找到index.html这个资源】,并将资源响应给用户

Nginx的基础配置

核心配置文件

nginx.conf最小配置

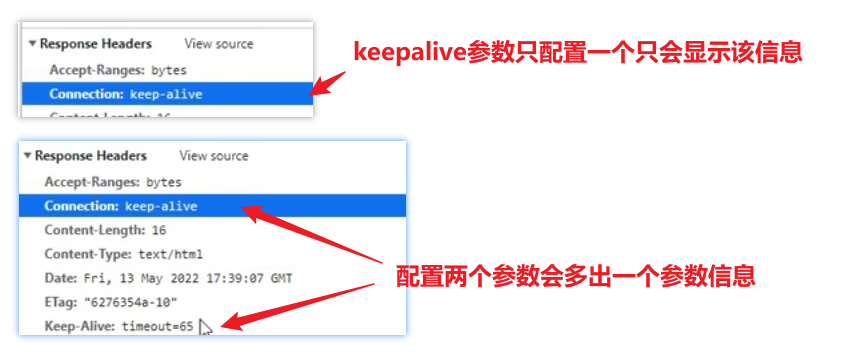

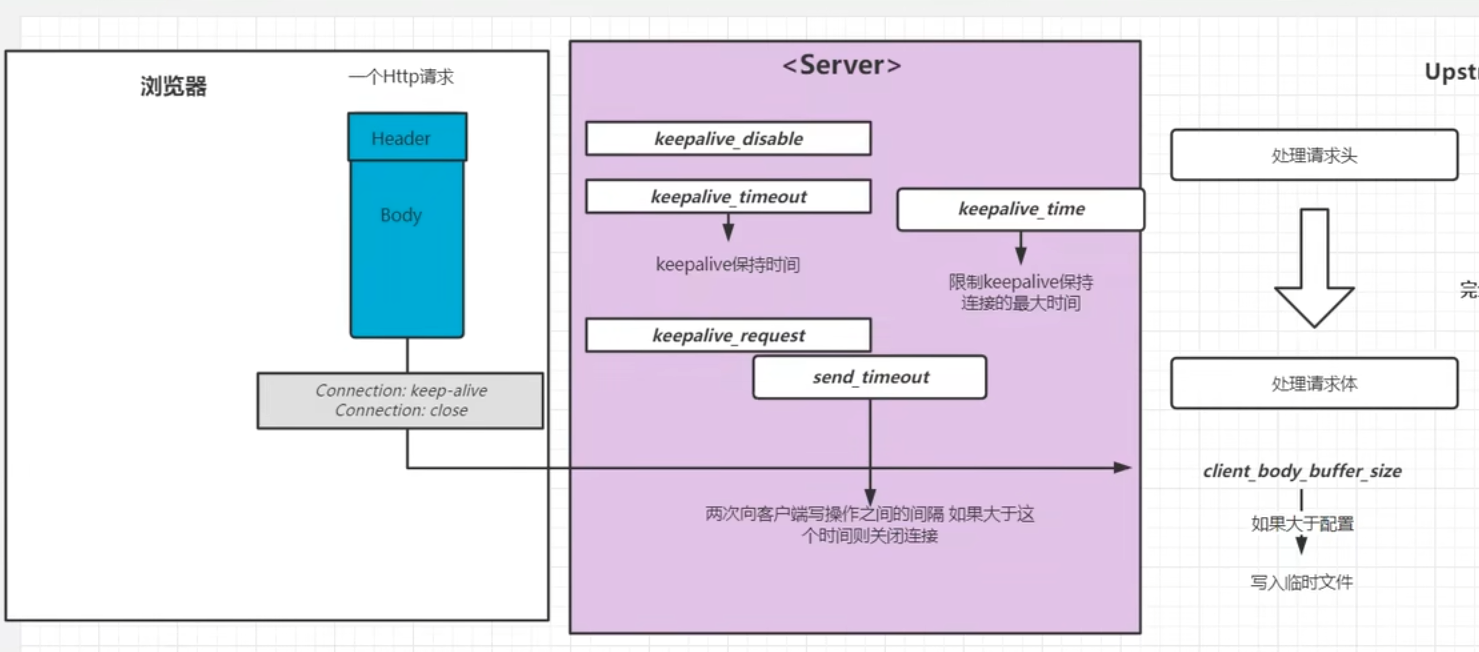

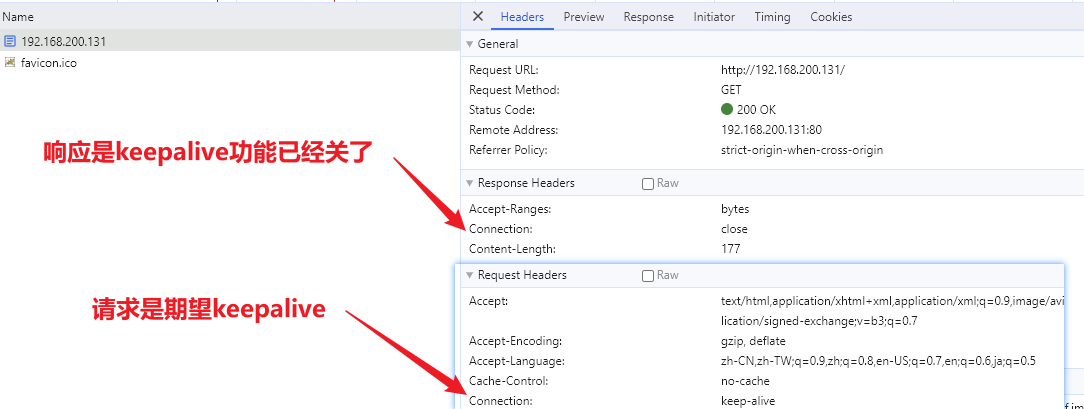

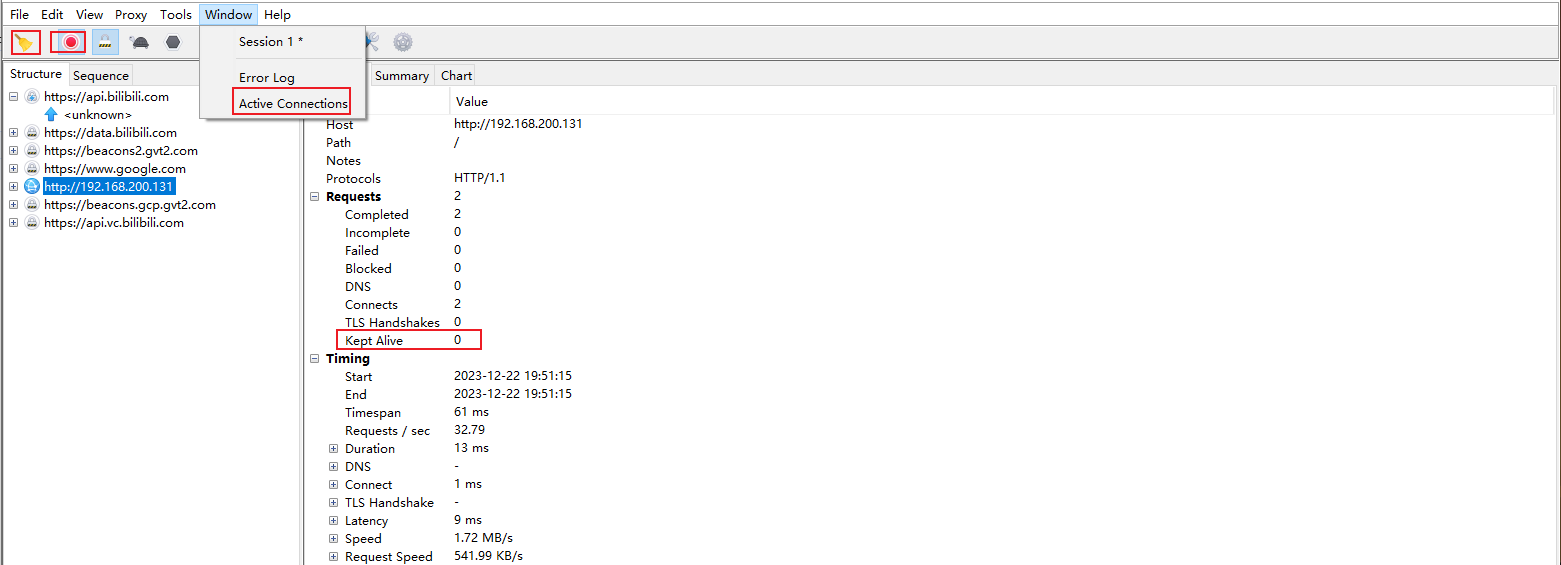

#是注释,nginx.confg中不带#的部分,也是能满足nginx正常运行的最小化配置文件版本xxxxxxxxxx#配置nginx在启动的时候需要启动多少个worker子进程,这个参数基本会设成对应当前服务器对应的CPU内核数,如果虚拟机只有一个内核,此时分配10个子进程,没有意义,因为一个内核分成10个时间段去处理十个进程效率反而会变低;基本的配置逻辑就是一个Cpu内核对应一个子进程worker_processes 1;#events是事件驱动模块,worker_connections指的是每个worker进程最多可以创建多少个连接,默认就是1024,一般不需要动events {worker_connections 1024;}#http模块,http {#include命令可以将后面的配置文件引入到当前的配置文件中,后续会使用include引入其他配置文件,一个配置文件写的内容过多不便于后续配置的管理,且多个对象对同一个配置文件进行更改需要竞争锁,但是多个配置文件可以各自改各自的,这样设计效率更高;mime.types是所有http协议的头标注的文件类型,这个头中会包含服务器返回给客户端的文件类型,如文本文档、html文档,可执行程序或flash文件,这个头的信息有服务器发送给浏览器告诉浏览器这是一个什么文件,由服务器定义;服务器传递给浏览器的文件是0101类型的字节码,浏览器只看文件后缀是看不懂具体是什么文件,必须通过服务器在协议头中加上当前传输文件的文件类型、如图片就加img、jpg到协议头中;不同的类型效果也会不同,图片的.png会直接在浏览器展示出来,不会直接下载;如果是.exe会弹出下载框对文件进行下载;但实际展示还是下载的行为不是由后缀决定的,是由协议头中的mime.types决定的,该类型可以对应到文件的后缀名include mime.types;#mime.types不可能包含所有的类型,如果实在没有匹配的类型,就使用默认的类型以application/octet-stream;以数据流的方式传递给浏览器default_type application/octet-stream;#开启sendfile功能,数据直接读取到网络接口,不走nginx内存sendfile on;#不做详细介绍,理解成保持链接超时的时间,将反向代理再细讲这个问题keepalive_timeout 65;#http模块下的server模块,一个server表示一个主机,一个nginx可以同时运行多个主机,这种开启多个主机的方式称为虚拟主机,虚拟主机又称为VHost,server {#nginx当前服务器监听的端口号,可以通过端口号来区分不同的主机,比如可以设置下一个主机在8080端口运行,主机的端口号不能重复,nginx服务就启动不起来listen 80;#server_name指的是当前主机的主机名,可以写域名或者主机名。必须要能解析,localhost能解析是因为计算机的Hosts文件中定义了localhost的映射是127.0.0.1#server_name是指检测到别人访问到某个域名如blog.concurrecy.cn就会跳转到对应的server下server_name localhost;#location表示一个主机有一个独立的站点,相互之间互不干扰,暂时理解为域名后的根路径或者整体看做uri【专业就叫uri,就是请求路径端口号之后的部分】,location是用来完整或者模糊匹配uri的,一个主机下可以配置很多个location,可以配置到不同目录下相互之间还不影响location / {#root是配置用户请求进来之后从哪个目录下去找相应的网页,初始设置的就是html目录,即欢迎页所在目录,这个路径是一个相对路径,html是相对于nginx的主目录`/usr/local/nginx`目录下的html目录root html;#该index只对当前location生效,对应html目录下的index.html页面index index.html index.htm;}#error_page是发生服务端错误的时候,50x错误码,对于列举的500 502 503 504四个错误码会转向到当前站点的/50x.html地址,这个地址相当于替代整个uri部分,相当于跳转http://192.168.200.132:80/50x.htmlerror_page 500 502 503 504 /50x.html;#一旦用户请求的uri为/50x.html就会去以html为根目录去找html中的50x.htmllocation = /50x.html {root html;}}}mime.types

前一个是协议头中的mime.type类型,后一个是文件后缀名

可以设置自定义文件后缀指定现有mime.type实现浏览器以视频的方式直接播放自定义后缀mp5的文件的能力

xxxxxxxxxxtypes {#返回文件的后缀名为html,就在返回的HTTP头中加入该文件类型是text/html,告诉浏览器用text/html的方式来解析当前响应的文件text/html html htm shtml;text/css css;text/xml xml;image/gif gif;image/jpeg jpeg jpg;application/javascript js;application/atom+xml atom;application/rss+xml rss;text/mathml mml;text/plain txt;text/vnd.sun.j2me.app-descriptor jad;text/vnd.wap.wml wml;text/x-component htc;image/png png;image/svg+xml svg svgz;image/tiff tif tiff;image/vnd.wap.wbmp wbmp;image/webp webp;image/x-icon ico;image/x-jng jng;image/x-ms-bmp bmp;font/woff woff;font/woff2 woff2;application/java-archive jar war ear;application/json json;application/mac-binhex40 hqx;application/msword doc;application/pdf pdf;application/postscript ps eps ai;application/rtf rtf;application/vnd.apple.mpegurl m3u8;application/vnd.google-earth.kml+xml kml;application/vnd.google-earth.kmz kmz;application/vnd.ms-excel xls;application/vnd.ms-fontobject eot;application/vnd.ms-powerpoint ppt;application/vnd.oasis.opendocument.graphics odg;application/vnd.oasis.opendocument.presentation odp;application/vnd.oasis.opendocument.spreadsheet ods;application/vnd.oasis.opendocument.text odt;application/vnd.openxmlformats-officedocument.presentationml.presentationpptx;application/vnd.openxmlformats-officedocument.spreadsheetml.sheetxlsx;application/vnd.openxmlformats-officedocument.wordprocessingml.documentdocx;application/vnd.wap.wmlc wmlc;application/x-7z-compressed 7z;application/x-cocoa cco;application/x-java-archive-diff jardiff;application/x-java-jnlp-file jnlp;application/x-makeself run;application/x-perl pl pm;application/x-pilot prc pdb;application/x-rar-compressed rar;application/x-redhat-package-manager rpm;application/x-sea sea;application/x-shockwave-flash swf;application/x-stuffit sit;application/x-tcl tcl tk;application/x-x509-ca-cert der pem crt;application/x-xpinstall xpi;application/xhtml+xml xhtml;application/xspf+xml xspf;application/zip zip;#octet-stream以数据流的方式去加载并提示用户是否需要下载下来application/octet-stream bin exe dll;application/octet-stream deb;application/octet-stream dmg;application/octet-stream iso img;application/octet-stream msi msp msm;audio/midi mid midi kar;audio/mpeg mp3;audio/ogg ogg;audio/x-m4a m4a;audio/x-realaudio ra;video/3gpp 3gpp 3gp;video/mp2t ts;video/mp4 mp4;video/mpeg mpeg mpg;video/quicktime mov;video/webm webm;video/x-flv flv;video/x-m4v m4v;video/x-mng mng;video/x-ms-asf asx asf;video/x-ms-wmv wmv;video/x-msvideo avi;}数据传输过程

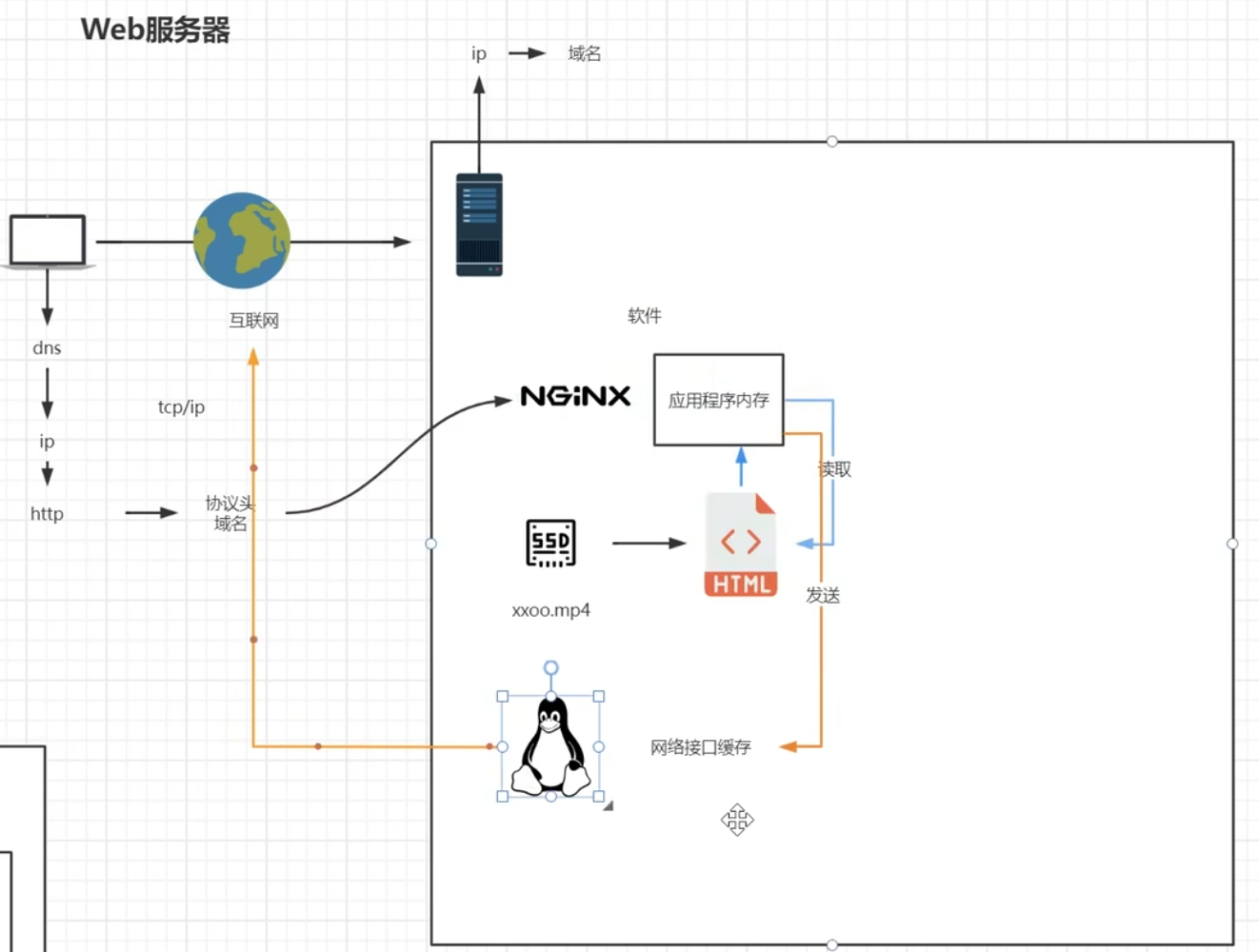

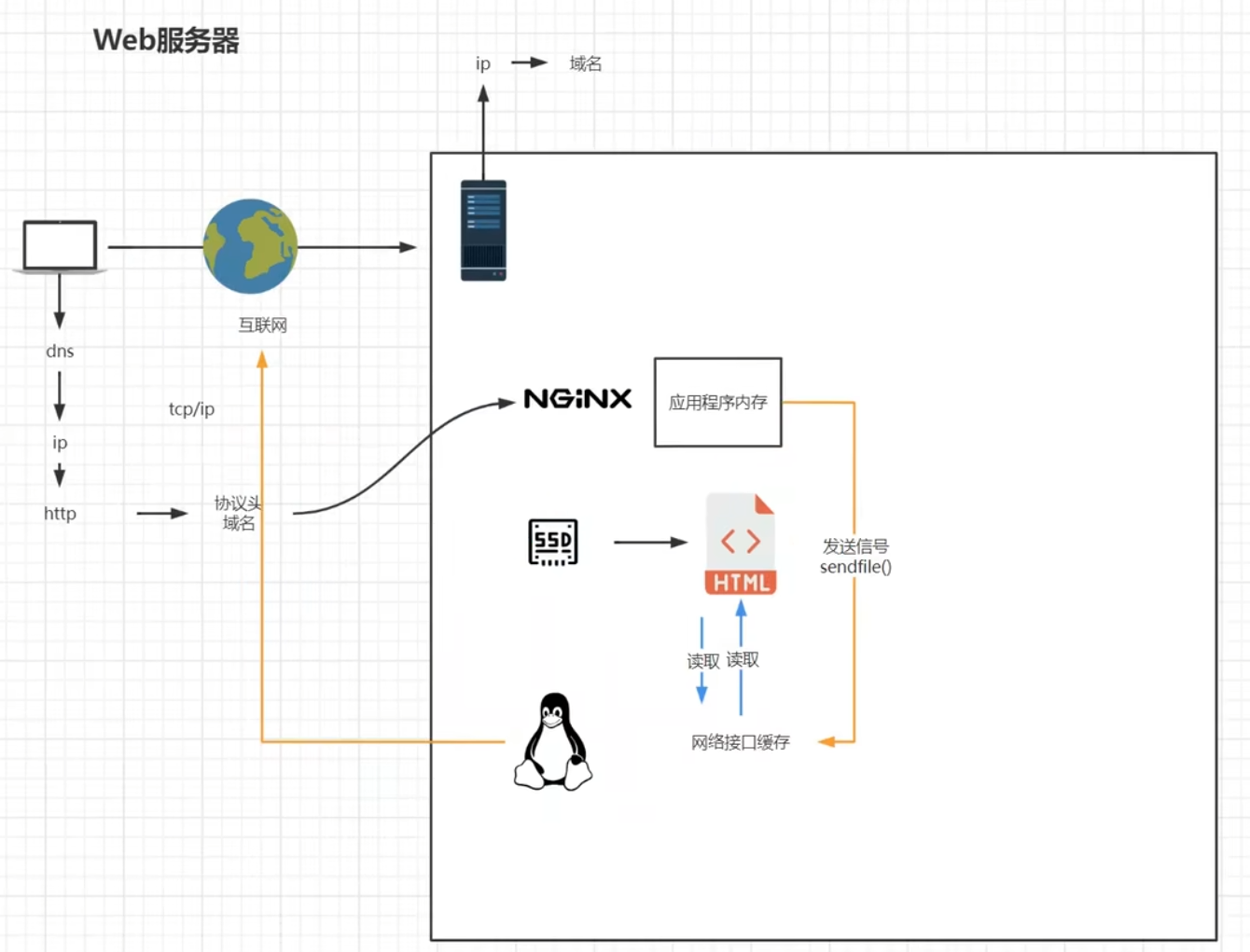

Nginx作为一款软件跑在linux系统上,请求从客户端通过ip找到linux服务器,由操作系统的网络接口将请求转发到nginx,在启动java网络程序的过程中会向操作系统注册一个端口,相当于告诉操作系统,有请求过来要通过请求对应端口转发给该程序

nginx拿到请求解析后通过配置文件找资源的目录,想要将该资源文件响应给用户,从找到该文件开始就开始决定是否开启sendfile的过程,sendfile开启和不开启的流程是不同的

不开启sendfile的情况下,分为read和write两个过程,read是nginx去读对应的文件,将完整文件加载到nginx应用程序的内存中,读完之后将当前的文件发送给计算机操作系统的网络接口【即网卡的驱动程序】,期间还会经历DMA的调度和网卡驱动程序以及内核缓存的一个过程,存在文件内容的二次复制,读取到nginx内存一次,复制给网络接口缓存一次【不同进程间如果不使用共享内存,内存不能相互访问,所以这里是必定多了一次拷贝的。】

【不开启sendfile下的流程】

【开启sendfile下的流程】

开启sendfile的过程是不需要nginx复制到自身内存再复制给网络接口缓存的过程,nginx不去读取相应文件,而是通过nginx向操作系统内核发送一个信号【执行sendfile方法向网络接口传递socket和文件位置】,由网络接口来读取对应的文件直接将文件发送给客户端

先将数据写入到内核态的缓存中,然后直接写入到socket缓存,socket缓存再发送到网卡,网卡再执行转发,就是在内核状态,将数据直接读取给网卡,而不是用户态->内核态->数据->内核态->用户态->内核态->网卡;少了一次读到应用内存的次数,减少了应用内存的消耗【来自弹幕组合分析,再深入了解一下零拷贝的概念,操作系统和计算机原理的知识】

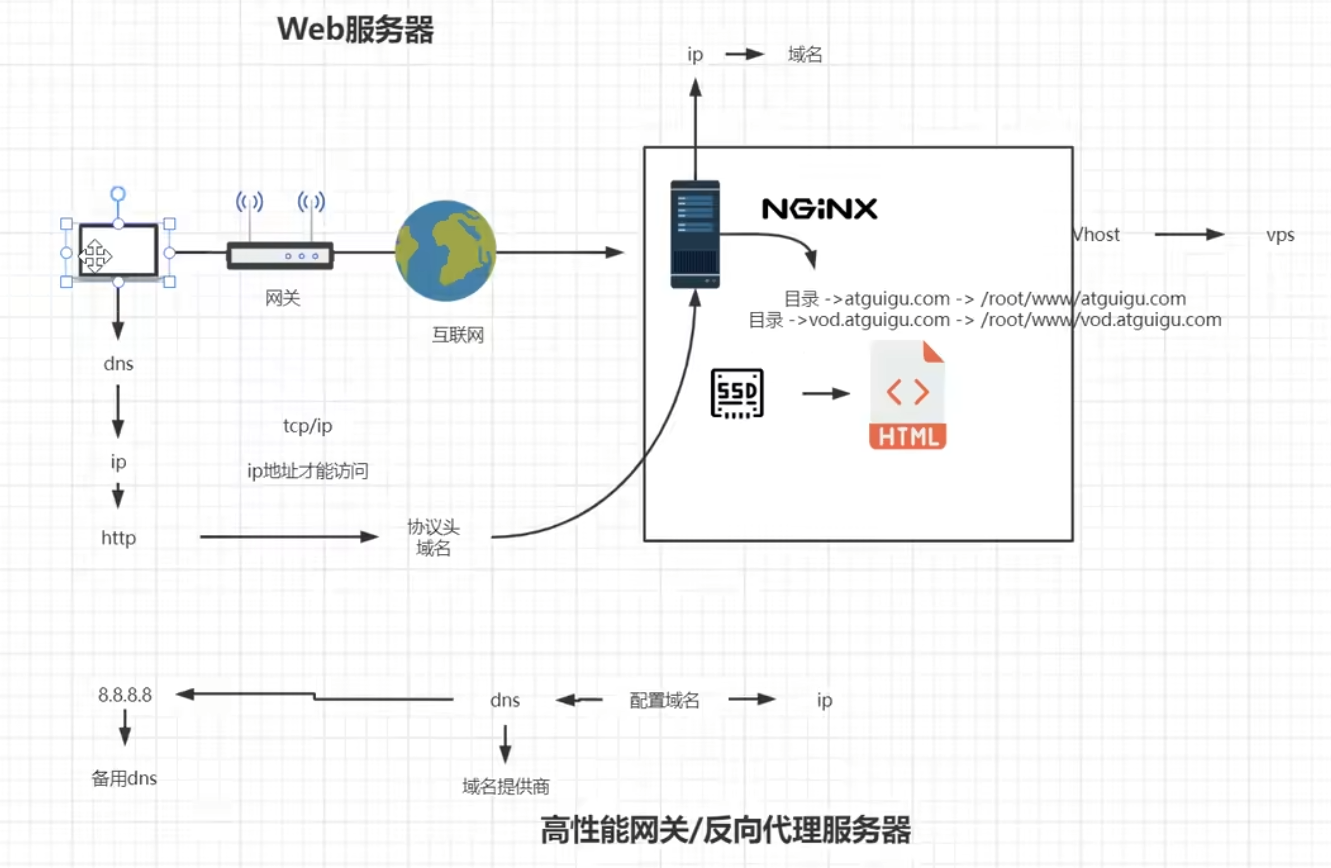

虚拟主机与域名解析

本地域名配置解析

这个比较假,只能内网用,公网是无法访问的

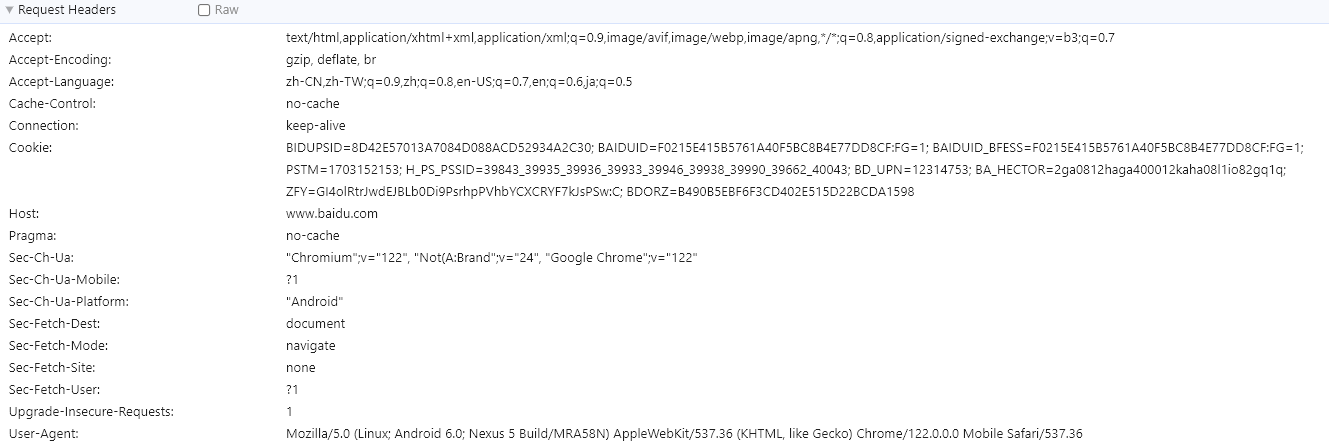

浏览器请求过程

电脑从DNS服务器拿到ip地址,会发起tcp/ip请求,

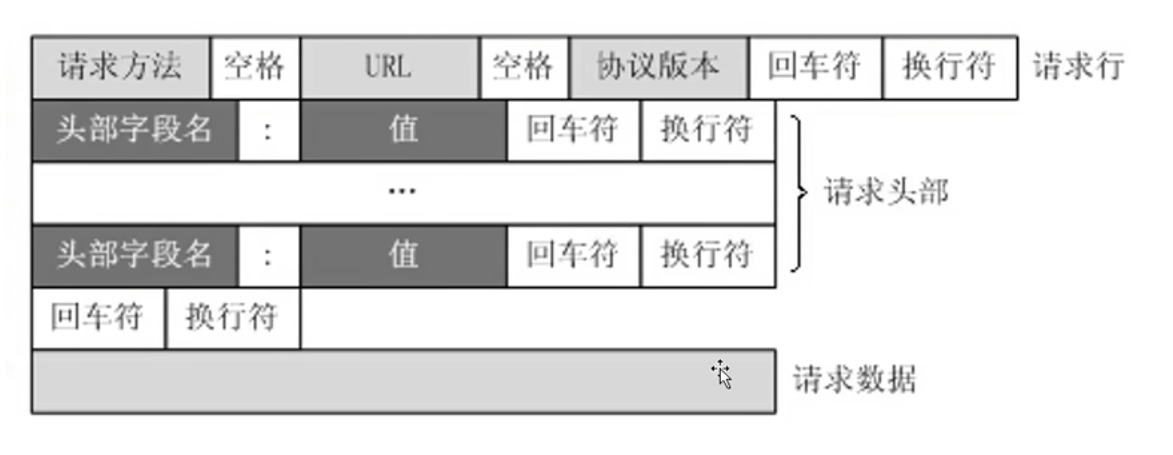

HTTP协议在tcp/ip协议之上,HTTP协议是高级的网络协议,tcp/ip协议叫做基础的网络协议,不能叫低级,基础的含义是能兼容一切上层的协议,HTTP的应用广泛,几乎所有上网的设备都支持HTTP协议,nginx和浏览器都实现了HTTP协议,

tcp/ip协议规定了网络只能传递二进制的数据,数据以数据流的形式发送给目标服务器,流的含义就像一段水流一样,tcp/ip协议中并没有对数据传递结束的约束和限制

HTTP协议中最重要的规定是通信双方数据传递结束的标准,类似与说一段话,话怎么开始,怎么结束,需要用协议规范;HTTP协议中请求数据的数据报文究竟有多长会直接写在HTTP协议中,HTTP协议是上层的高级应用协议,其中包含的约束比较多,约束了通信双方都要按照一定规则传递数据,

HTTPS协议在HTTP协议的基础上额外增加了一层数据安全的保障,路由器就是一层网关,需要通过路由器接入互联网,路由器也不是直接接入主干网,在接入主干网之前还要接入小区的网关,服务供应商的网关,区一级的网关,市一级的网关,再到全国的总的网关入口,才能接入到主干网,网关传递数据非常多,用HTTP协议能被网关劫持解析数据看见个人隐私数据,又比如转账消息,因此在原有HTTP协议的基础上考虑到安全又弄出了Https协议【后续详细讲】

虚拟主机

一台主机上开一个站点,可能压根就没多少人访问,对资源是极大的浪费,

虚拟主机是将一台真实主机虚拟出来多台主机,一台虚拟主机对应一个域名【ip】,外部请求访问虚拟主机时让多个域名对应同一个真实的主机ip,由主机上的nginx来根据请求域名进行判断请求究竟要访问那个虚拟主机,nginx将请求对应指向不同站点的目录响应对应的资源即可

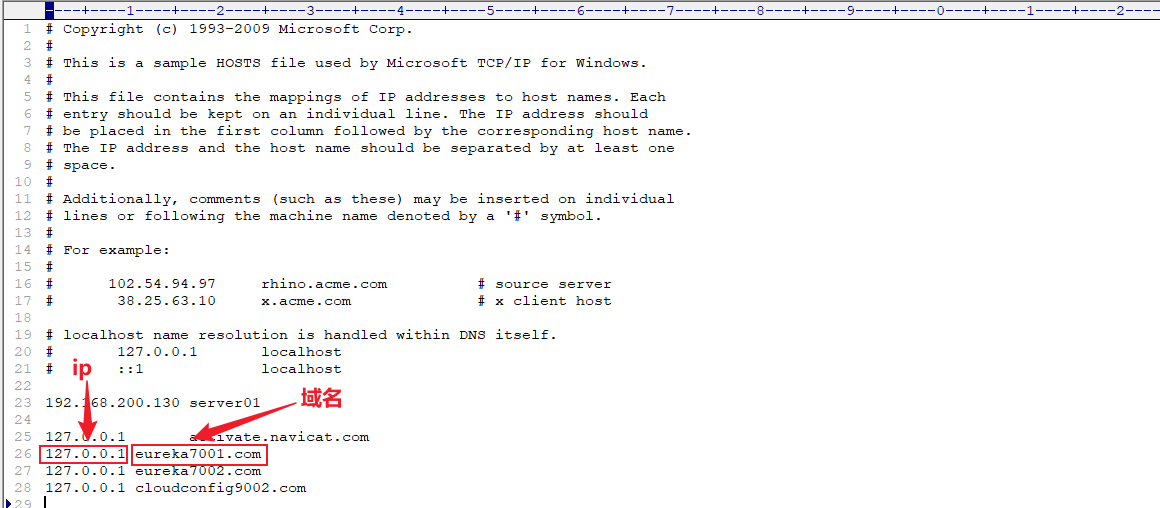

配置域名解析

因为买不到域名,相当于在自己的系统里玩,外网访问不到

域名解析配置在windows的hosts文件中

因为在hosts中已经配置了域名对应的ip,以后本机访问

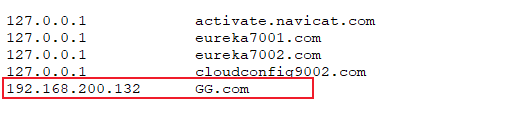

eureka7001.com就不会再去DNS服务器中进行查找,而直接从hosts文件中拿,这个就叫本地域名解析在hosts文件中设置虚拟机的ip:

192.168.200.132对应的域名为GG.com,在浏览器访问http://GG.com/就能直接访问虚拟机上启动的nginx

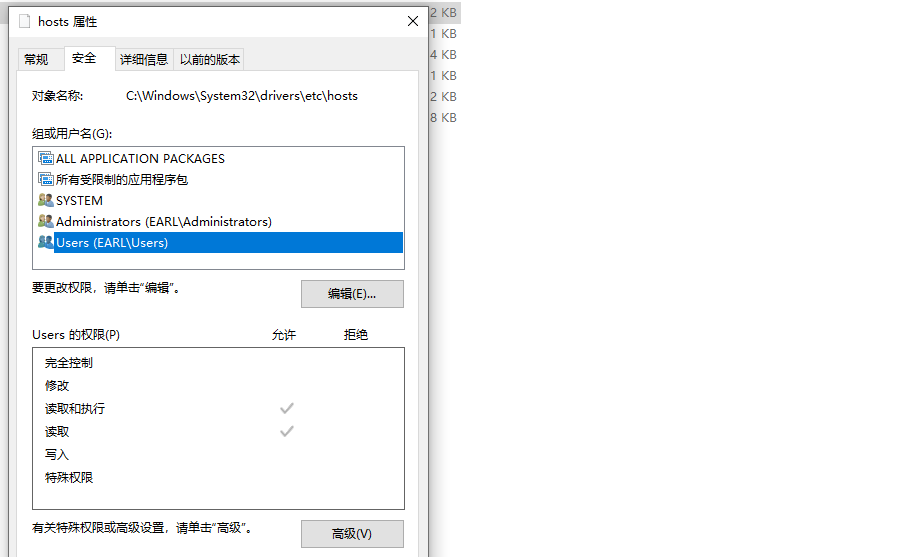

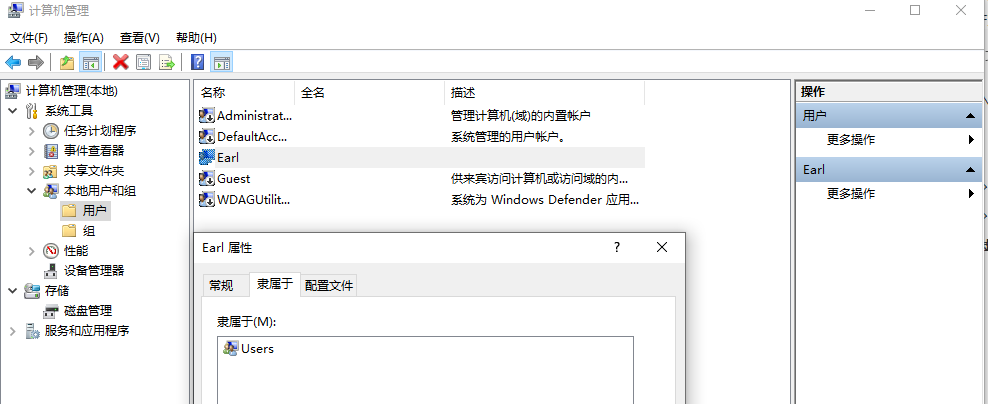

修改hosts域名解析

系统目录下文件更改需要的权限比较高,可以更改该文件的编辑权限,点击hosts,右键属性,在安全选项卡下,SYSTEM和Administrators都有修改的权限,但是users没有修改权限,只要添加用户组的修改权限用户就能更改该文件,选中users点击编辑勾选完全控制即可使用户获得系统文件的全部权限,改完系统文件最好再还原回来【只勾选读取以及读取和执行两个权限,这里实现不了,因为只有超级管理员才有更改权限的权限】,避免一些程序更改系统配置,比如正常的站点访问会自动被劫持到错误的ip上

还有个办法将host文件从系统文件夹中复制到有权限的文件夹,修改配置后粘贴替换原系统文件夹下的hosts文件

可以以管理员的身份启动editPlus,就能修改该文件

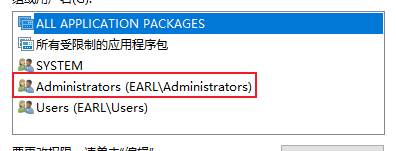

还可以将当前用户Earl添加到超级管理员组,这样当前用户就能获取超级管理员权限,但是这样不安全,除非把超级管理员的完全权限也禁用掉【以上办法都需要当前用户有超级管理员权限,如果把当前用户从超级管理员组中剔除,那么当前用户连更改权限都做不到,甚至想让超级管理员账户启用都做不到,此时只能

shift+重启,重启过程中一直按住shift进入高级选项,在高级选项中选择启动设置并以安全模式启动有点难找,但是确实找得到,选择超级管理员账户进入,将此前用户添加到超级管理员的分组中,让Earl用户拥有超级管理员权限】,现在的办法是给Earl超级管理员分组,取消超级管理员的写入功能,其他不要动,需要的时候再打开,避免出现超级管理员权限也丢失的情况而且注意hosts文件的编码格式必须为ANSI,不能为UTF-8,否则即使写对了也识别不了

【域名映射】

【还原用户权限】

【修改用户组】

【修改用户组效果】

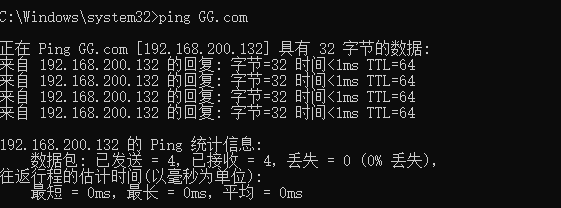

测试域名解析生效

开启对应虚拟机,使用命令

ping GG.com观察是否ping通经过测试,域名不区分大小写

【浏览器使用域名访问虚拟机】

公网域名配置解析

域名的售卖商很多,最大的是万网,万网被阿里云收购了,小型域名商存在跑路的风险,我买的是腾讯云,用腾讯云做演示

域名记录类型

除了列举的其他都不太常用,最常用的就是列举的几个记录,A是最最最普遍的

A是域名匹配一个独立的ip地址,直接将该域名转向到ip地址上,记录到服务器上,常用的就是A记录

CNAME是将该域名转向到另外一个已经解析好的域名上,有可能不知道域名的ip地址或者域名对应的ip地址会变,不需要管ip就能直接访问

AAAA是IPV6的地址,目前IPV6还没有普遍起来

NS是做DNS服务器的

MX是做邮件服务器的【申请企业邮局,会要求将SMPT、Pub3这种域名解析到相应的ip地址上】

填写说明

主机记录是域名的前缀

www如www.concurrency.cn,即二级域名,三级域名二级域名都可以如法添加,www前缀在浏览器不填前缀默认就是www,解析线路可以根据访问用户的通信运营商将用户对域名的访问指向到对应运营商如联通或电信访问速度较快的ip上,在DNS服务器上就能完成根据用户通讯运营商分配到访问速度较快的相应运营商ip上,还可以根据教育地址和搜索引擎分配不同的IP,把不同来源的流量分隔开,这就是智能的DNS服务器了;传统的DNS服务器只是k-v键值对的方式根据域名匹配ip地址,

记录值就是IP地址,就是虚拟机的那个地址

192.168.200.132TTL(Time to live),是指各地 DNS 服务器缓存解析记录的时长。

假设 TTL 设定为10分钟,当各地的 DNS 服务器接收到域名的解析请求时,会向权威服务器发出请求获取到解析记录,并在本地服务器保存10分钟,在10分钟内,解析请求将从本地缓存中读取,缓存失效后才会重新获取记录值。建议正常情况下设定10分钟即可,使用不同套餐版本的解析能设定的 TTL 最低值不同。

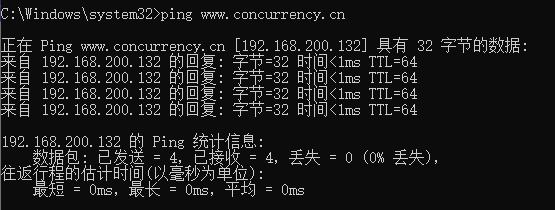

测试域名解析是否成功

cmd窗口ping www.concurrency.cn是否能ping通

浏览器访问 www.concurrency.cn能否访问到虚拟机的nginx欢迎页

此时也只能内网访问,公网无法访问

泛解析

对主机记录使用通配符

*,二级域名不论是什么都会解析到设置的ip地址上想要做二级域名系统,即多用户的域名系统【多个请求打到同一个ip真实主机,nginx再根据请求分配对应的站点】

Nginx虚拟主机配置

虚拟机中配置多个站点,端口号和主机名的并集不能完全相同,启动的时候会报错,不同虚拟主机的主机名和端口号其中一个可以不同或者都不同

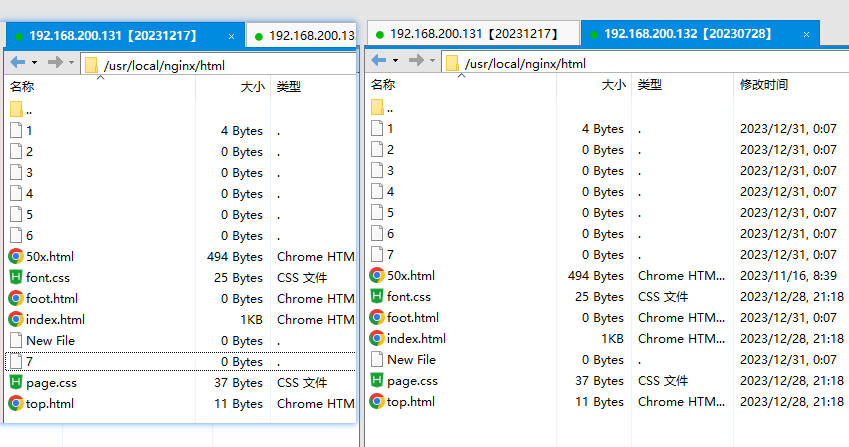

配置虚拟主机站点目录

在linux系统下的根目录下创建www目录

在www目录下创建www目录作为主站点,创建video站点作为视频站点

在video目录下创建一个欢迎页index.html,编写文字

this is vod web site在www目录下创建一个欢迎页index.html,编写文字

this is www web site

更改nginx配置文件

nginx.confg创建文件用shell比较方便,编辑文件用xftp比较方便;不要怕改错了,

nginx.confg.default是该文件的一个默认备份xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;#虚拟主机vhostserver {listen 80;#域名、主机名server_name localhost;location / {#设置该虚拟主机的主站点,绝对路径root /www/www;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}#虚拟主机vhostserver {listen 88;#域名、主机名server_name localhost;location / {#设置该虚拟主机的主站点,绝对路径root /www/video;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}改完以后使用命令

systemctl reload nginx重新加载nginx,使用命令systemctl status nginx查看nginx运行状态浏览器访问效果

实现了不需要区分域名只需要区分端口号就可以访问多个站点

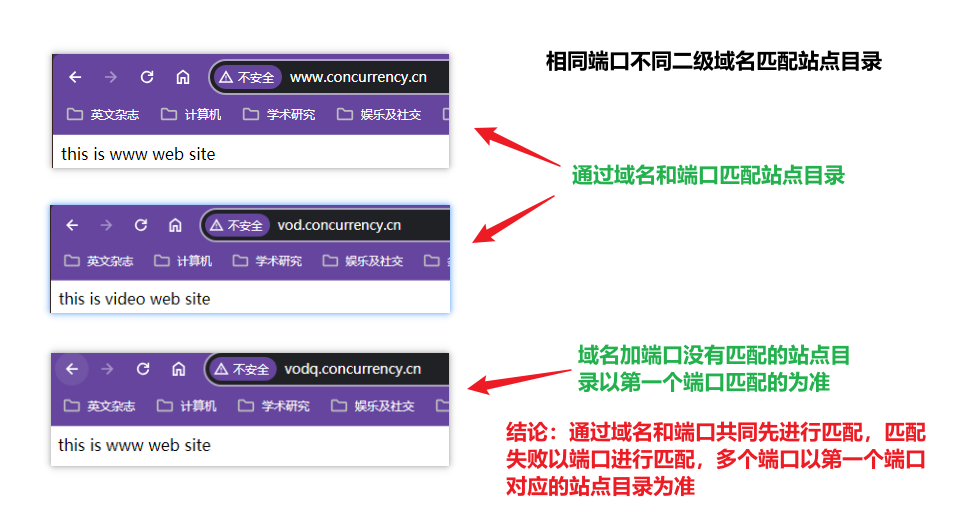

配置域名

配置相同端口不同二级域名,此时根据域名和端口的并集进行匹配

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;#虚拟主机vhostserver {listen 80;#域名、主机名,让这个域名www.concurrency.cn进入到www这个站点目录server_name www.concurrency.cn;location / {#设置该虚拟主机的主站点,绝对路径root /www/www;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}#虚拟主机vhostserver {#同一个端口号下可以通过域名访问不同的站点目录,这种演示需要将端口改成相同的,否则会优先走端口listen 80;#域名、主机名,让域名vod.concurrency.cn进入到vedio这个站点目录server_name vod.concurrency.cn;location / {#设置该虚拟主机的主站点,绝对路径root /www/video;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}使用命令

systemctl reload nginx使配置生效,在浏览器输入不同的二级域名测试访问效果实现不区分端口只区分域名就能实现不同站点目录的访问

没有域名加端口的匹配站点目录的情况下默认访问第一个匹配端口的站点目录

证明:将vod站点配置在www前面,再次访问域名和ip没有匹配的请求地址

vodq.concurrency.cn,访问的站点目录就变成video目录了

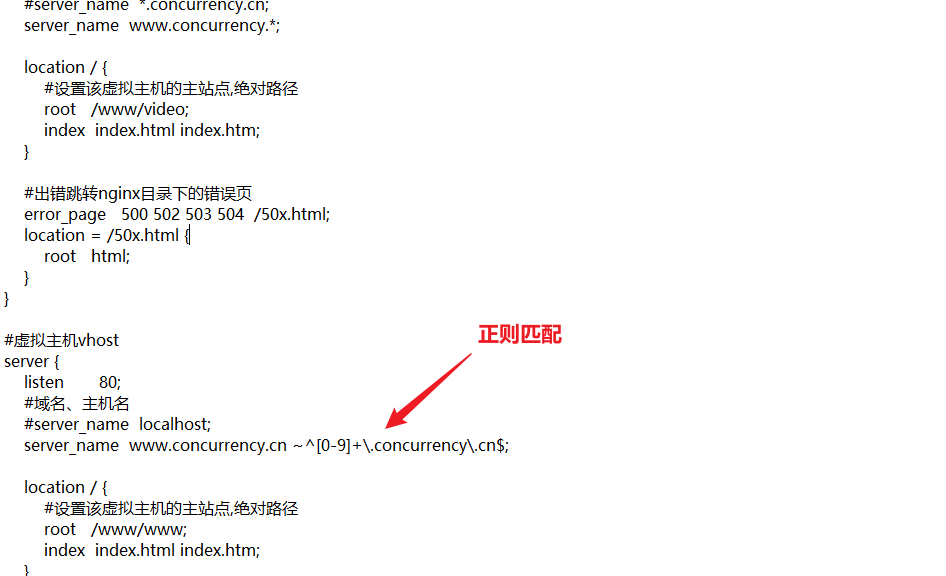

ServerName匹配规则

如果两个域名

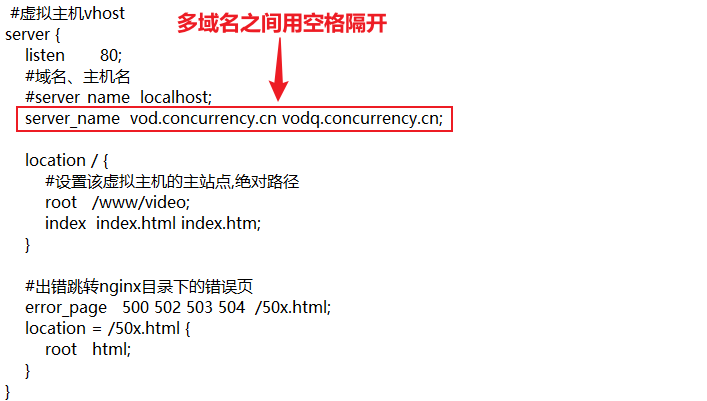

vod.concurrency.cn和vodq.concurrency.cn都想解析到video目录下【不考虑将video站点目录作为首个80端口站点目录,用不能匹配的方式强制让vodq.concurrency.cn对应到video目录的情况下】,此时如果给两个域名都指定不同的虚拟主机server且都匹配到相同的站点目录,就显得很不优雅笨重server_name匹配是非常有用的技术,尤其是配置虚拟主机的时候,把所有的请求都接入到一个server中,server通过反向代理的方式把请求转到后端业务逻辑处理的服务器上,再根据用户请求做不同的处理响应不同的结果

可以在一个server的server_name中配置多个域名

第一个80端口站点目录是www,如果

vodq.concurrency.cn没有匹配上会优先跳转www目录

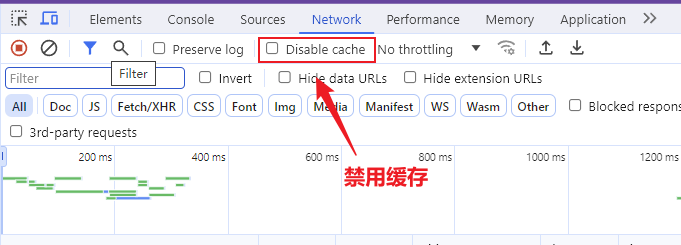

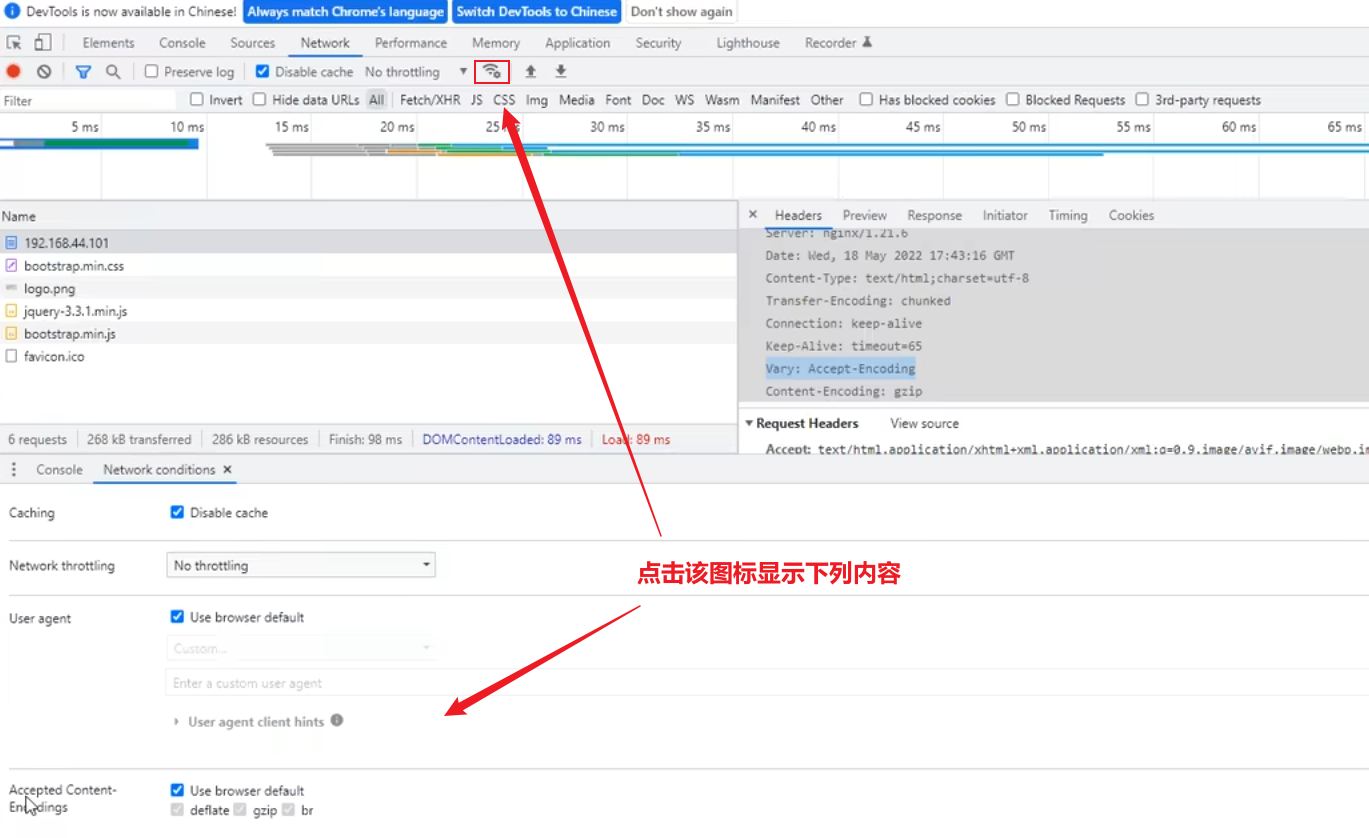

【浏览器禁用缓存设置】

即使点了也不一定好使,

也可以使用

ctrl+F5强制刷新缓存,也可以在请求链接后面加

vodq.concurrency.cn?xxx进行访问,浏览器缓存找不到对应请求路径,就会直接去请求服务器

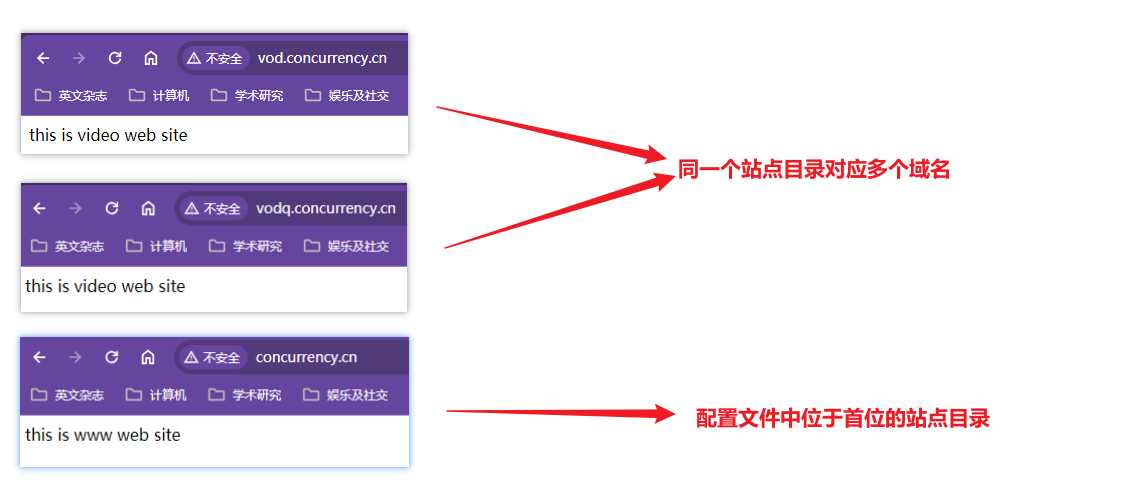

【测试效果】

通配符匹配二级域名前缀

注意通配符匹配二级域名前缀

*.concurrency.cn不能识别一级域名concurrency.cn,直接通过concurrency.cn是访问不到虚拟主机的用

*匹配二级域名到video站点目录,将www站点目录放在通配符的后面,观察www.concurrency.com是否仍然访问www目录经过测试,域名匹配总是先走精确匹配,匹配不到再走通配符匹配

【测试效果】

通配符匹配域名后缀

用

*作为域名结束匹配可以匹配以不同字符.com或.cn结尾的域名到同一个站点,由于只购买了域名concurrency.cn,所以需要在hosts文件中添加www.concurrency.org和www.concurrency.net本地域名解析

测试效果

只要能被本地解析或者远程解析出主机ip的域名即使无法精确匹配,只要存在对应端口的站点目录,就会自动匹配到对应端口的第一个站点目录,hosts中配置的默认是以www作为二级域名,像vod.concurrency.org这种既无法被本地解析又无法被远程解析出主机IP的就会直接报错;如果找到主机IP,但是nginx配置文件中没有找到对应的端口,也会报错

同样的,优先进行精确匹配,再进行通配符匹配或者直接用端口进行匹配

正则匹配

配置

正则匹配前缀是纯数字的,即

concurrency.cn和纯数字.concurrency.cn跳转www站点目录,非纯数字.concurrency.cn、concurrency.net和concurrency.org匹配video站点目录

测试效果

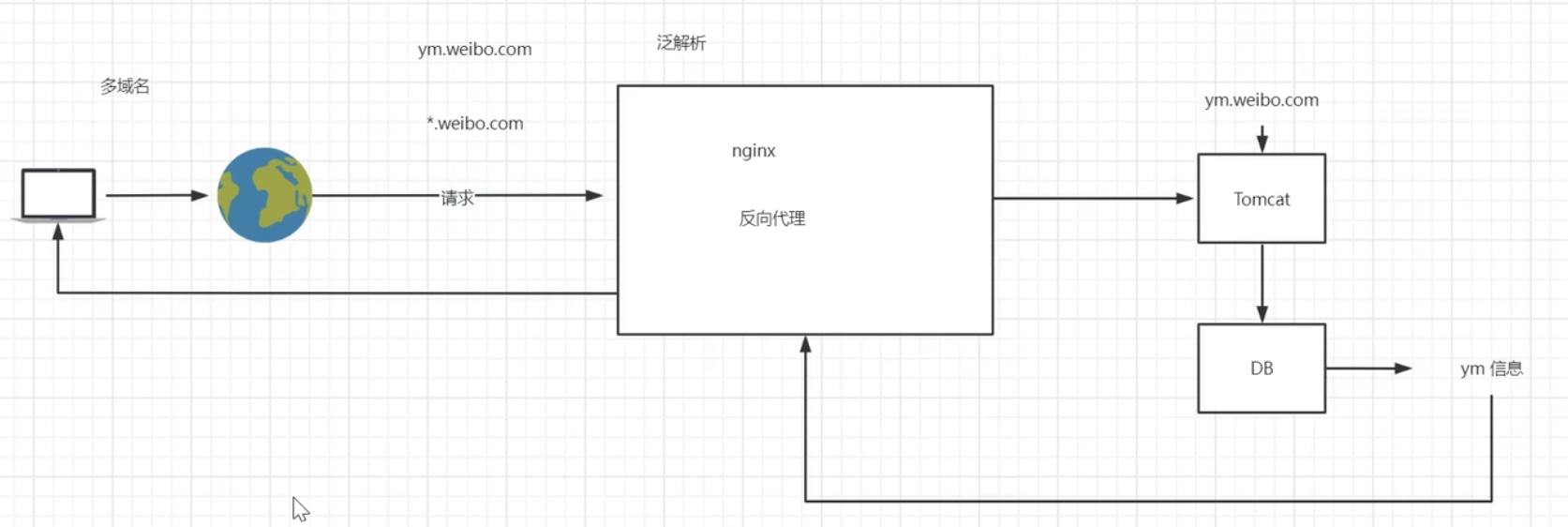

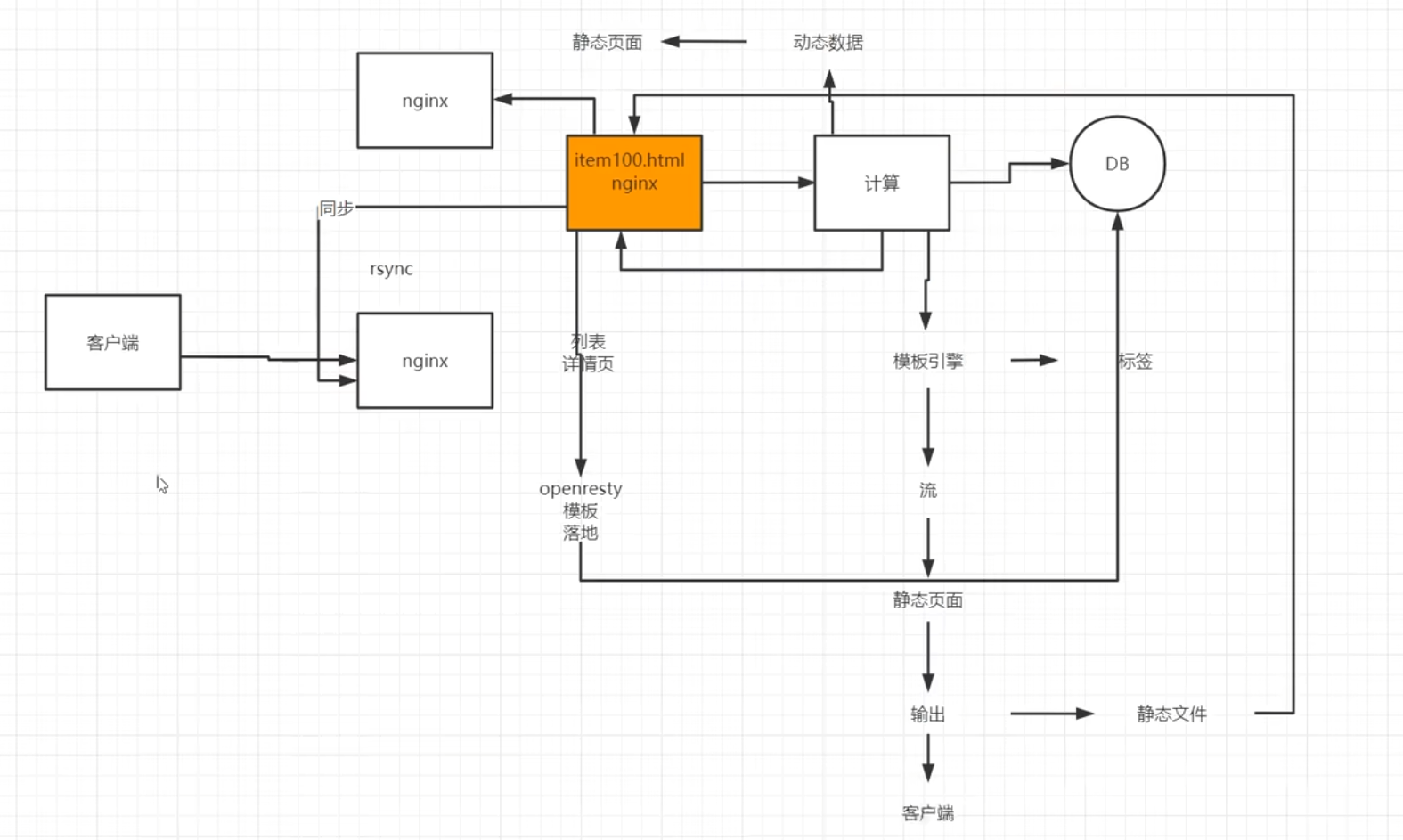

域名解析技术架构

多用户二级域名

二级域名系统就是指有很多的二级域名来访问该系统

原理

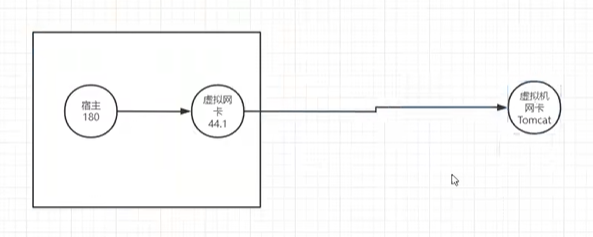

所有的二级域名通过泛解析全部接入同一台服务器中,nginx通过反向代理将所有的请求转发到另一台业务服务器上【不是虚拟主机】,比如Tomcat和java实现的服务器,Tomcat能够获取到访问请求访问的二级域名,业务服务器处理完请求将结果返回给反向代理,反向代理将数据传递给nginx,nginx把数据响应给用户

感觉课上讲的像反向代理将请求转发给业务服务器,业务服务器解析二级域名前缀,拿着前缀去数据库获取该二级域名前缀的信息并传递给反向代理再传递给nginx,最后响应给客户端

短网址

原理

短网址就是用户发送一个请求如

dwz.cn/aidfjoasidfj21739给nginx服务器,nginx服务器将请求转发到短网址运维系统,该系统在数据库存储了短网址的uri部分即aidfjoasidfj21739和真实地址的对应关系【uri常用UUID保证唯一性,怎么处理真实地址获取到UUID的没有说】,用户使用短网址被打到对应的短网址运维系统,系统根据uri从数据库查询到真实地址,使用重定向将请求转发到真实的请求地址上

Httpdns

DNS服务器走的UDP协议【去全网广播,就是在腾讯云上配置的域名解析】,HttpDNS走的Http协议

具体原理还是要看计算机网络和操作系统,图也只是讲了个大概,这些只是nginx域名解析的应用场景,了解个大概

走HTTP协议需要有HTTPDNS服务器的IP地址,用HttpDNS就是想获取相应目标域名的IP地址,一般HTTPDNS服务器地址都存在客户端,HTTPDNS一般不适合网页即浏览器使用,一般是给手机的APP或者基于C/S架构的应用进行使用,【可以在这种软件中预埋几个ip地址,这几个IP地址就是nginx服务器,浏览器记不住这些HTTPDNS服务器的IP地址】,系统启动后,会向预埋的几个IP发起请求,请求传参某个域名获取其当前真实的ip地址,HTTPDNS将真实的IP地址返回

直接理解成发送请求前先使用预埋IP请求HTTPDNS服务器获取目标域名的IP,再次使用真实的IP发起用户的请求;浏览器无法实现因为浏览器无法持久化HTTPDNS服务器的IP,无法向HTTPDNS服务器自动发起请求,所以只适用于C/S架构的应用,HTTPDNS服务器就是

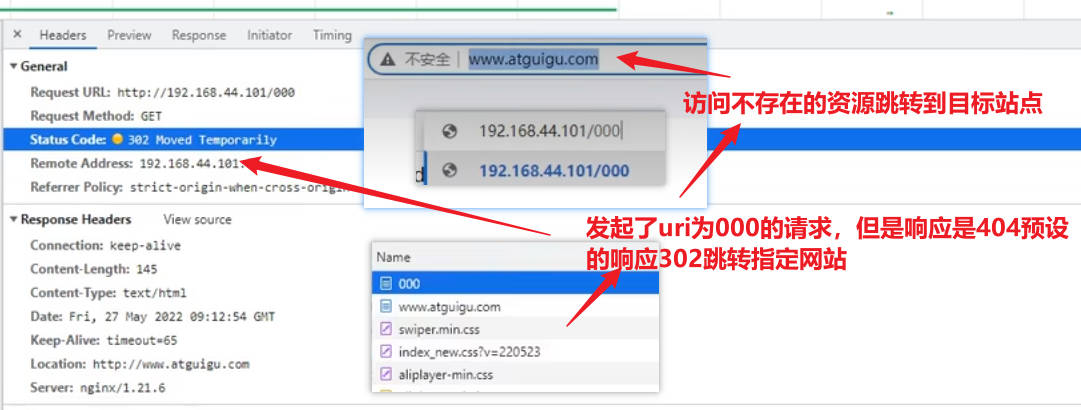

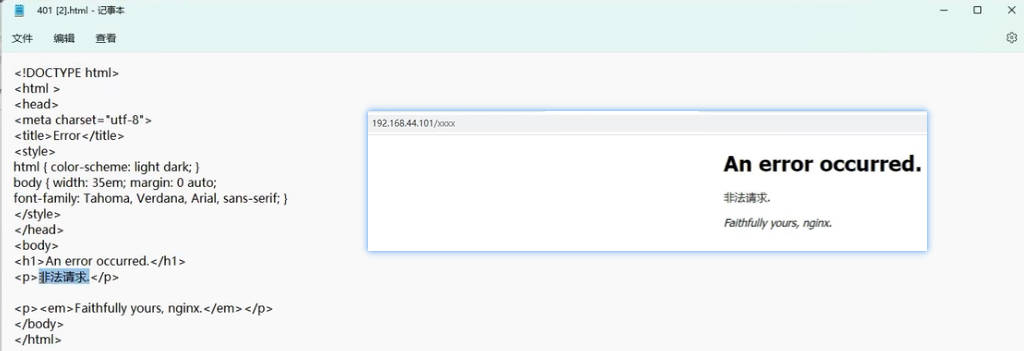

Nginx的错误页配置

错误页配置详解

错误页配置的目的是为了处理请求过程中发生了错误通过对错误进行捕获,用补偿的信息替代掉错误信息返回给客户

可以自定义发生错误时修改响应的状态码并且配置对应展示的资源或者跳转的网站,让浏览器认为没有报错,正常响应了资源或者友好提示,可以通过选项返回首页

以下展示了发生错误根据错误码展示对应的站点目录资源;

发生错误将响应错误码替换成302跳转到指定网站;

发生错误将响应错误码替换成200并响应指定站点目录资源

xxxxxxxxxx...http {...server {listen 80;server_name vod.concurrency.cn;location / {root /www/video;index index.html index.htm;}#发生404错误,发生错误就跳转到对应的网站上去,等号和302之间不能有空格,有空格会启动报错,跳转地址和分号间也不能有空格;HTTP状态码错误是可以处理的,系统级别的错误是用户是处理不了的,配置响应码302需要给重定向的地址给浏览器#error_page 404=302 http://www.atguigu.com;#发生404错误响应200状态码,响应/401.html站点资源;此外错误页还可以设置响应图片或者其他东西,但是一般都是使用网页给用户响应error_page 404=200 /401.html;#error_page的相关设置,如果是500系列错误就会跳转到location站点/50x.html下,/50x.html是一个location,不是一个地址;如果是APP或者前后端分离的项目也可以返回一个友好提示的json数据error_page 500 502 503 504 /50x.html;#location的根目录是html目录,没有指定uri对应的资源名就会去访问uri对应的同名资源location = /50x.html {root html;}error_page 401 /401.html;location=/401.html{root html;}}}【404错误的响应效果】

【响应站点目录资源的效果】

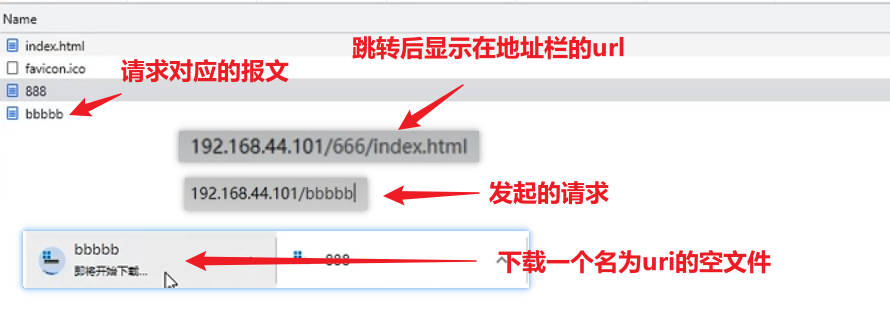

匿名location

匿名站点目录的匿名针对的是客户端,客户端访问该站点是访问不到的,主要用于希望location只在内网中被使用的情况,在内网调用的情况下就可以把匿名站点的内容展示给用户

匿名location的配置

此前配置的站点目录用户通过对应的uri都是可以访问到的,包括错误页配置

匿名location的写法是location后面不使用等号使用@符号

xxxxxxxxxxlocation @666 {root html;}【访问匿名站点目录的效果】

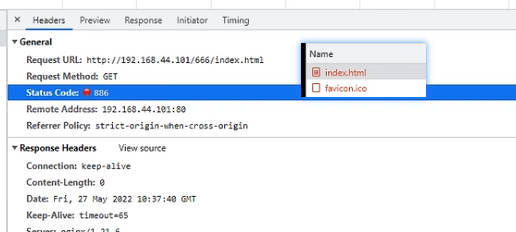

html站点目录下有index.html资源,但是匿名站点目录无法访问,返回错误码404,404此前设置错误页响应200并响应资源401.html

希望用户无法访问但是内部可以跳转的匿名站点目录

这种配置下找不到资源会报错404,但是会被跳转到配置的@666站点目录下并响应return中响应的内容,如果只有200状态码,没有指定响应的资源,会响应一个请求uri作为文件名的空文件

如果状态码不是200比如886,浏览器只会在响应头中看到状态码886,不会再显示下载文件;因为状态码200告诉浏览器要读取响应内容,对200状态码下载的行为是浏览器做出的判断,在响应头中没有Content-Type类型,不知道如何展示响应内容,就只能选择以文件下载的方式处理响应内容

xxxxxxxxxx#发生404错误跳转@666匿名站点,这个等号和@666之间有空格也能成功启动nginxerror_page 404= @666;#@666是站点的名字,html是站点目录;return命令可以直接返回后面跟的资源,无需进行资源和uri的匹配;只有状态码200会开始下载一个空文件location @666 {return 200;#return 886;}【上述找不到资源404错误跳转匿名站点@666并响应站点目录return后面的资源内容】

名字经过确认就是对应uri,且大小为0K

【状态码886的响应效果】

只有return不设置响应内容类型Content-Type,响应头中就没有Content-Type参数,浏览器不知道如何去展示响应数据

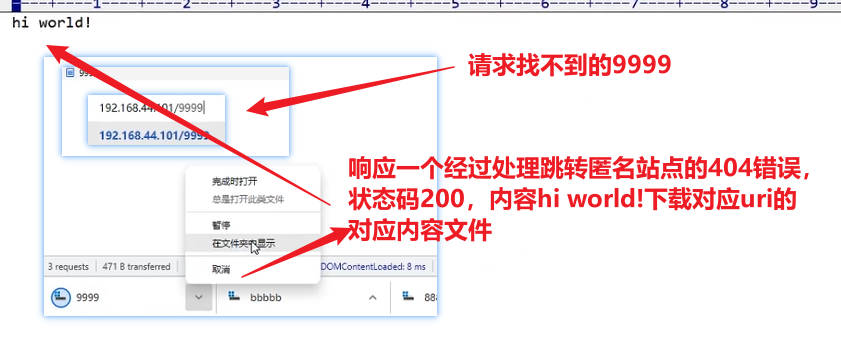

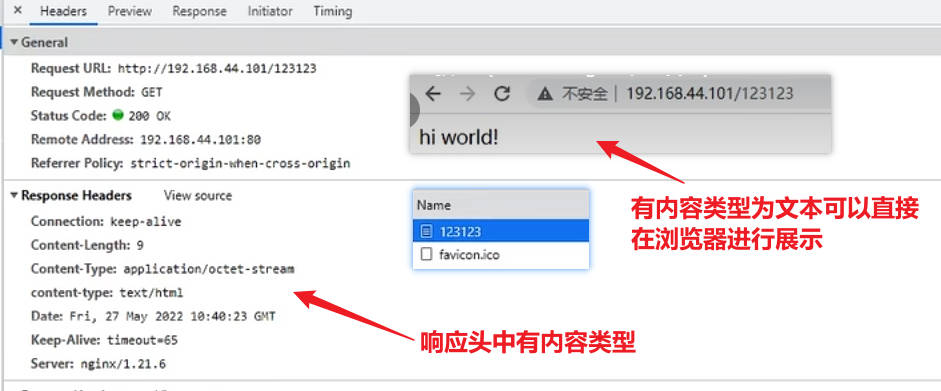

location中return响应状态码和文件内容

【匿名站点响应200状态码并添加资源】

xxxxxxxxxx#发生404错误跳转@666匿名站点,这个等号和@666之间有空格也能成功启动nginxerror_page 404= @666;#@666是站点的名字,html是站点目录;return命令可以直接返回后面跟的资源,无需进行资源和uri的匹配;只有状态码200会开始下载一个空文件location @666 {return 200 "hi world!";}【响应效果】

在使用return的同时添加Content-Type参数

设置成响应类型为文本类型,浏览器就能对响应内容进行展示

xxxxxxxxxxerror_page 404= @666;location @666 {#向响应头信息中添加头信息content-typeadd_header content-type "text/html";return 200 "hi world!";}【响应效果】

反向代理

反向代理是nginx应用中极为重要的功能,也是系统架构选用nginx使用的主要功能,基于反向代理可以衍生出非常多的应用场景和需求的解决方案

网关、代理和反向代理

反向代理

用户访问系统通过互联网将请求打到机房的网关上,网关会把所有的请求都打到nginx服务器上,nginx作为反向代理服务器时会将所有的请求全部转发到后端的应用服务器,这些应用服务器可以是java和tomcat做的项目集群,tomcat是不会被用户直接访问到的,应用服务器响应之后再将结果响应给nginx,在nginx和应用服务器之间形成内网,就是nginx在中间做了中间商,这种系统结构就是反向代理,相当于nginx代表用户去访问应用服务器,发现访问成功,数据也都拿回来了

机房内的网关和应用服务器也不互通,网关想要直接连接应用服务器连不上

正向代理

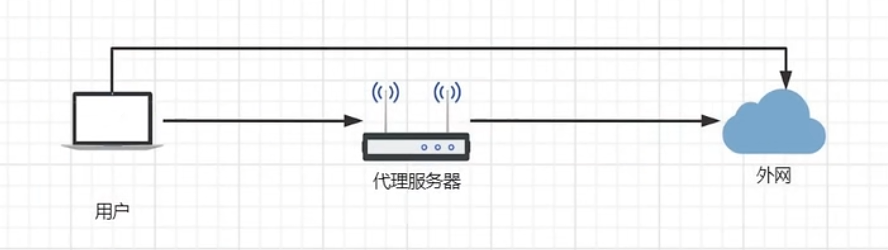

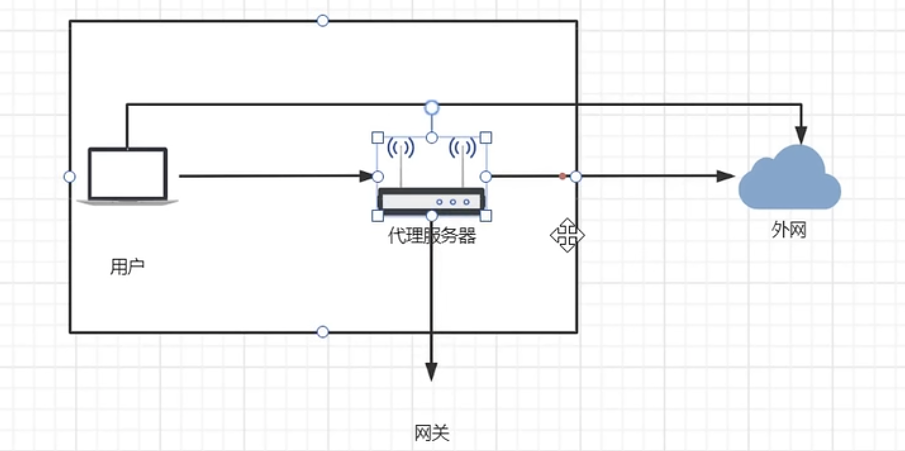

正向代理系统结构

比如用户无法直接连通外网,此时需要一个代理服务器,用户能够连接代理服务器,代理服务器能够连接外网,用户就能通过代理服务器连接到外网【有点像vpn】

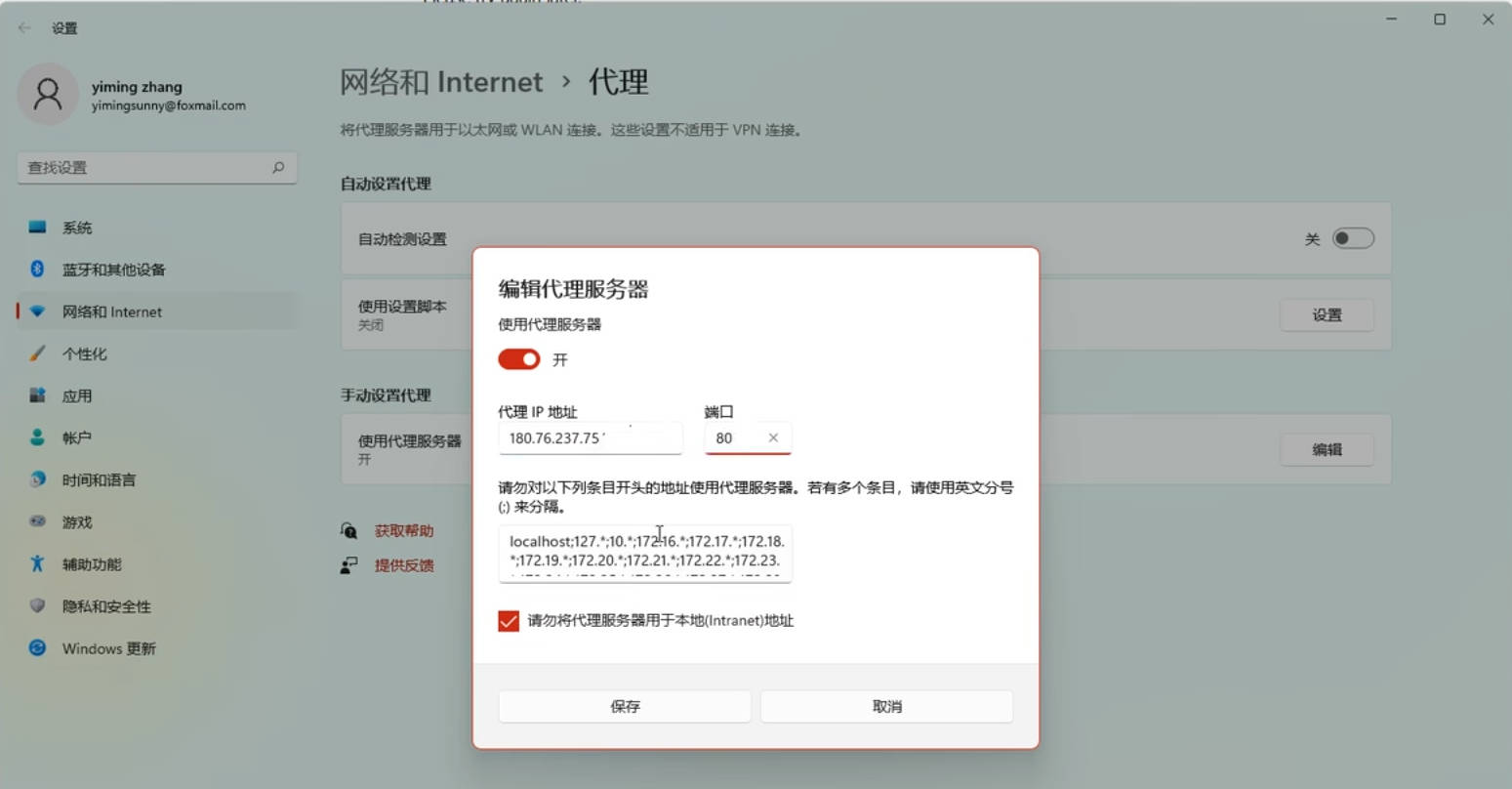

正向代理和反向代理的区别就是正向代理是用户主动配置代理服务器【用户和代理服务器是一家子】,需要这个代理服务器去访问某些网络;反向代理是nginx代理服务器与用户想要访问的网络是一家子【即该代理服务器不是用户主动配置的】,用户甚至机房网关都不能直接访问应用服务器,由服务提供商提供给用户一个访问入口来对访问不到的应用服务器进行访问;实际上两种代理服务器都起到一样的作用,即在用户和网络资源之间起到中继和网络传递的作用,本质上都是用户--代理服务器--网络资源的结构,就看代理服务器是谁提供的

网关

手机连上家里的路由器,把所有的数据都发送给路由器,由路由器转发给下一跳的路由中继或网关服务,一跳接一跳地跳到目标服务器的位置,目标服务器收到请求处理后再一跳一跳的返回回来;家里的路由器其实就是网关,网关其实就是一种代理服务器,在正向代理结构中的爱丽服务器就是网关,网关就是访问网络的入口,就像学校的大门,需要从大门进出学校

网关的特点:在用户和目标服务器之间中转所有的数据,这种特点注定如果网关的带宽不足【比如路由器的带宽只有10M,但是下载的东西是100M,意为着最大地下载速度只有10M,千兆网络如果路由器的下载速度只有10M,下载速度也会卡在10M,请求越多越卡,多个请求访问外网会竞争路由器的带宽资源,越竞争路由器的分配效率越低,认为带来很多额外的操作,避免这种情况只能提升代理服务器即网关的带宽】,在反向代理结构中,nginx服务器的网络带宽就是整个应用集群的带宽,nginx服务器的带宽只有10M,后续网络即使千兆,数据传输速度也只有10M;这种特点决定了在较高品IO操作的情况下nginx做反向代理服务器就不合适了,这种数据一进一出必须走一个nginx代理服务器的模型称为

隧道式代理模型,这种模型有天然的网关性能瓶颈;有其他办法可以避免这种隧道式代理模型带来的网关性能瓶颈,即用户请求打到nginx反向代理服务器,nginx将请求转发到应用服务器,应用服务器直接将数据返回给用户,而不是将数据返回给网关由网关将数据返回给用户【只有请求进应用服务器走代理服务器,响应数据的时候不再走代理服务器】,这样的模型叫DR模型,是LVS提供的一种功能,LVS是一种性能比nginx还要高的负载均衡器,但是功能比nginx简单的多,LVS是专业的负载均衡器,在反向代理的时候既可以做隧道式反向代理,也可以做DR模型的反向代理【请求进入系统通过代理服务器,响应返回的时候不过代理服务器】,DR模型的应用举例:必须想获取应用服务器一个500MB大小的文件,可能发送的是一个get请求,get请求只有1KB大小,1KB的请求消耗的网络带宽不大,此时返回数据500MB数据如果走nginx,在高并发情况下nginx的网络就首先扛不住了,此时由Tomcat把数据包直接传递给用户【也不是直接传递,而是先将数据包传递到机房的网关上,即使用DR模型需要应用服务器能和机房网关通讯,此时应用服务器也是接入外网的,应用服务器此时不处于纯粹的内网环境,但是这种情况一般应用服务器被设置成只能向外网传数据,不能接收任何请求】就会极大地减小nginx的压力,DR模型是靠虚拟伪装IP完成的,逻辑在LVS中会详细讲解

Lvs是一款很简单的软件,直接内嵌在linux内核中,甚至不需要额外装软件就可以直接使用LVS,

反向代理的应用场景

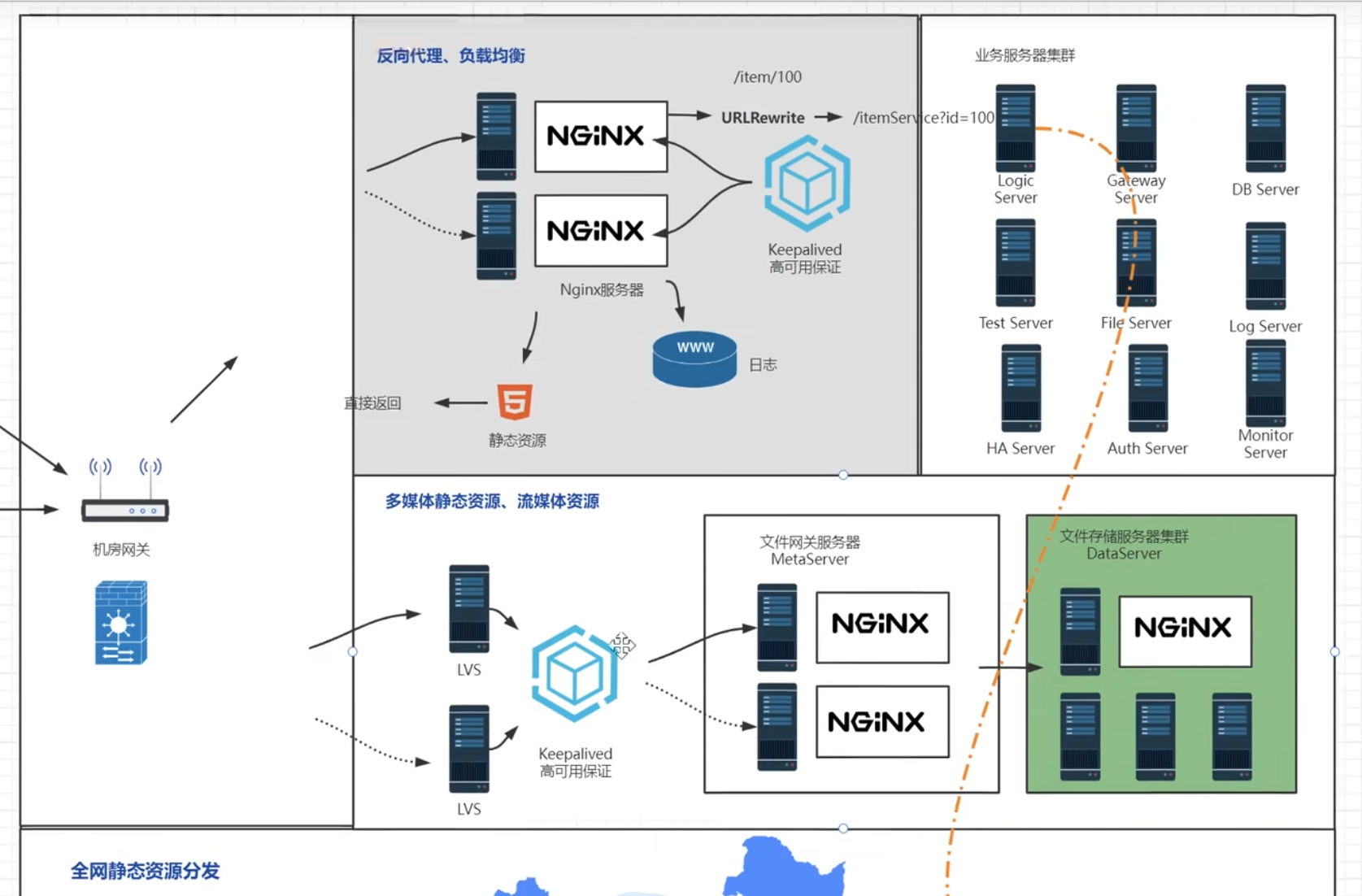

超大型的互联网项目还是传统公司里面的ERP、CRM、CMS、OA这种项目基本上都有nginx的反向代理,主要还是性能高,成本低,体验好

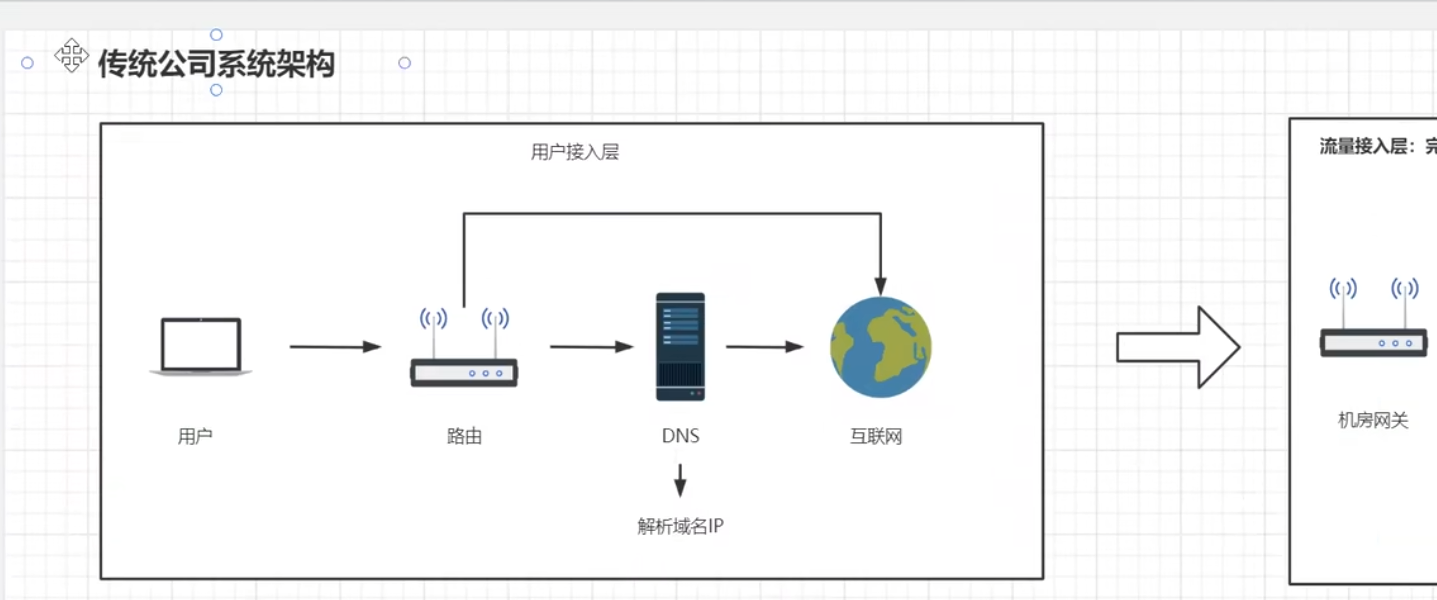

传统公司系统架构

最简单的应用架构,这种架构适用于传统小型项目,像一些提供给内网用户使用的系统并发量不大直接用nginx代理请求即可

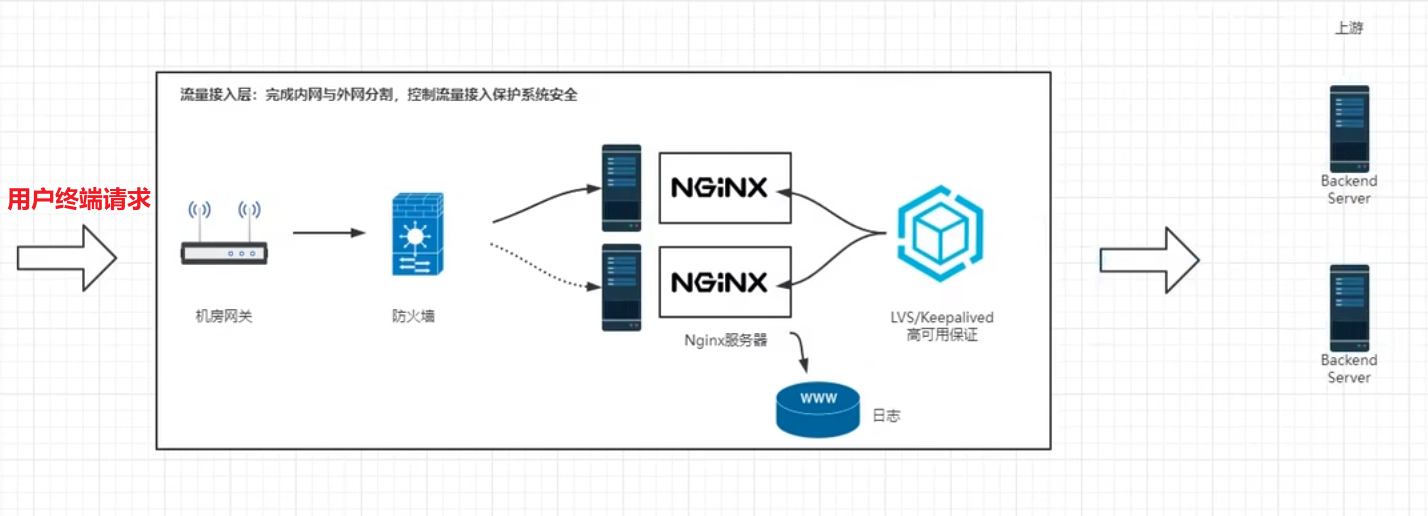

用户接入层

用户请求经过网关,经过域名解析,通过互联网访问到公司系统的流量接入层

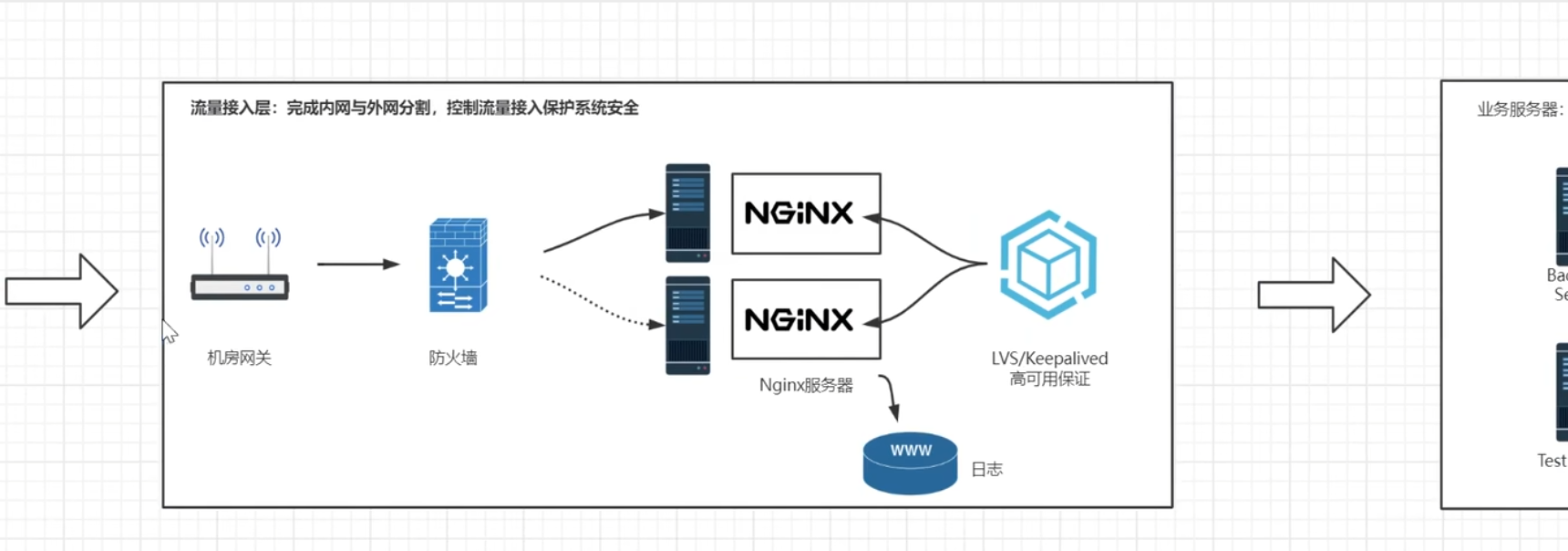

机房网关加代理服务器

用户请求打到机房网关,机房网关中转请求并通过防火墙,转发带nginx反向代理服务器,反向代理服务器将用户请求转发到对应的业务服务器

业务服务器

举例:英语培训在线教育APP,以nginx代理后边的三台tomcat,系统性能非常好,3台tomcat服务器能抗住300的并发量,并发量就是QPS,QPS300对传统的互联网项目来说已经非常可以了,这个产品的价值也已经非常可观,不是同时在线人数,是每秒钟有300的点击量,实际上大部分时间都是浏览,所以点击量是低于在线人数的

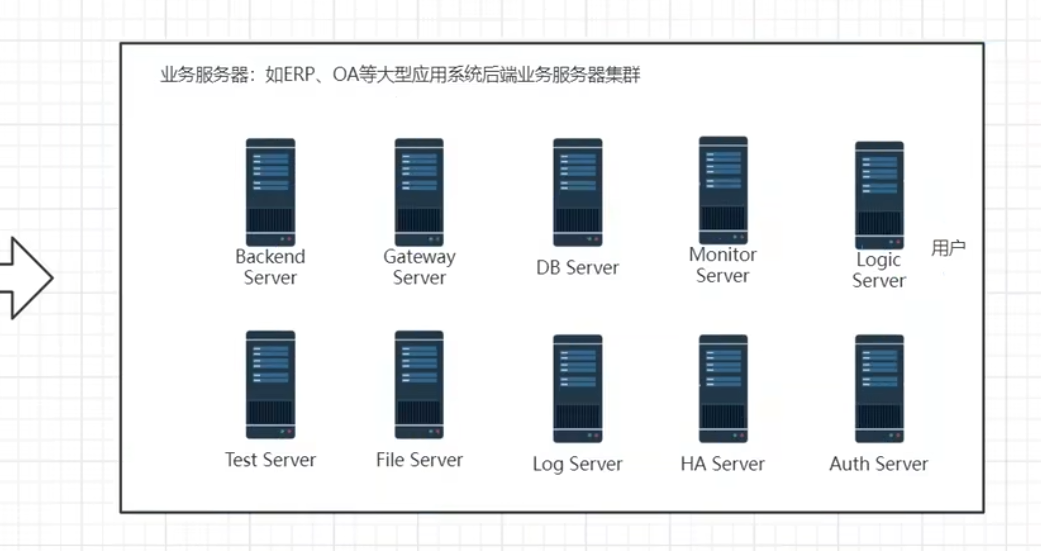

backend Server是后端服务器,GATEWAY是后端的网关路由服务器,数据库服务器、测试用的服务器、文件存储服务器、日志服务器,业务逻辑服务器、保证高可用的HA服务器、权限管理的Auth Server服务器

GATEWAY服务器是将所有的业务服务器统一的管理起来,在中间起到查找和一定的鉴权作用,并不是所有的请求都可以直接访问业务服务,而是需要在GATEWAY做一次权限认证

Nginx是服务器级别的网关, 当后端的网关需要做成集群时需要Nginx做负载均衡, 后端的网关是项目级网关

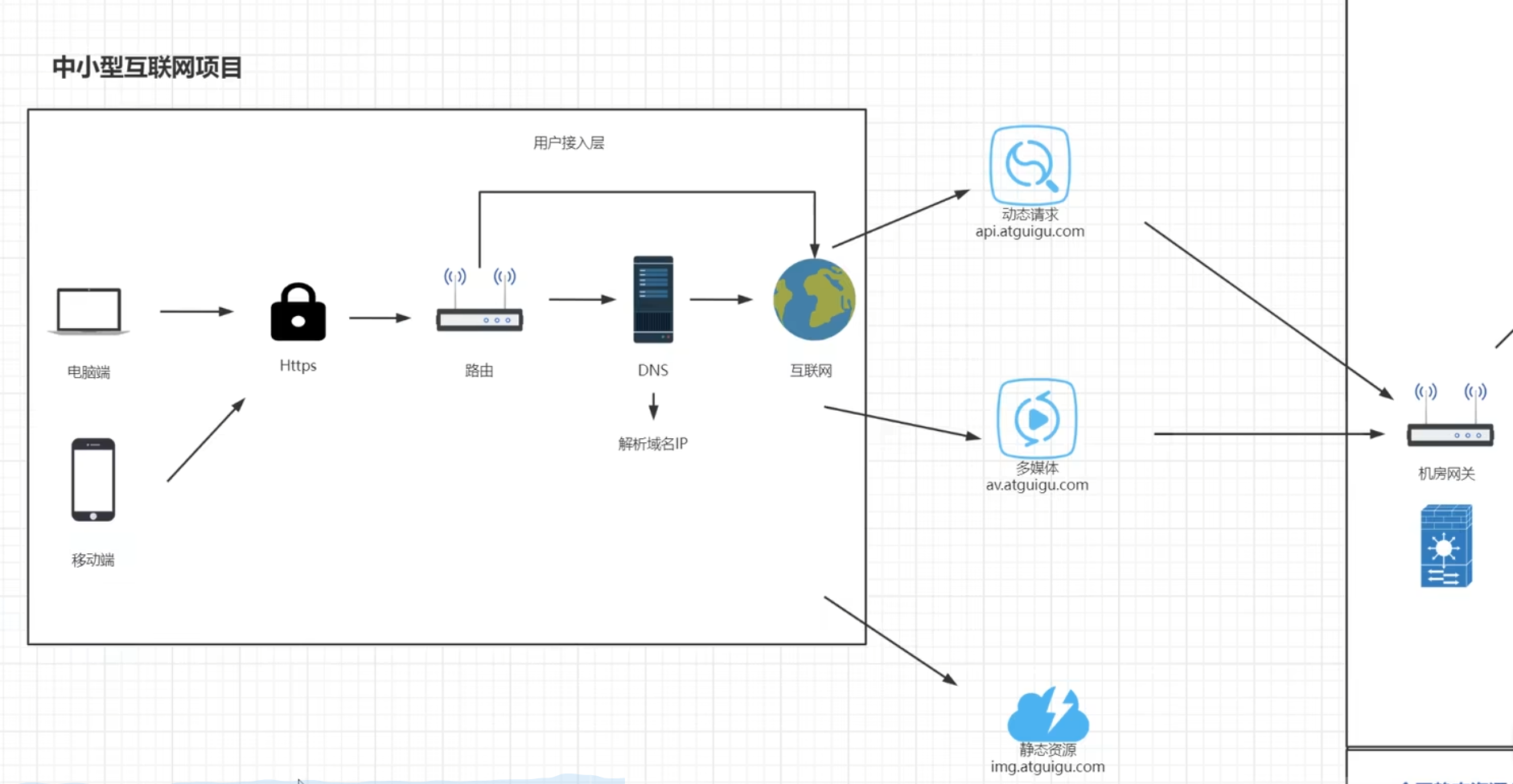

中小型互联网项目

用户接入层

这一块后面再说

系统

nginx作为反向代理服务器需要起到更多的功能,如伪装当前访问资源的真实地址【发送请求的URI为

/item/100,能在nginx中改写成真实访问的URI/itemService?id=100,这样能显得更高级;电商类似京东会将/itemService?id=100这样的访问URI改写成/item/100.html的形式,用户看起来会觉得这是一个独立的页面,实际上数十亿的商品根本不可能存在这么多静态页面,这种方式会让商品在计算网页排名的算法PageRank中占到的权重更高】nginx服务器对业务逻辑的转发,转发的数据包一般就是json数据,可能就几KB大小【比如修改密码】,这种情况下nginx很能抗,一台nginx服务器就能代理后边的数十台业务逻辑服务器

对于多媒体静态资源,流媒体资源的服务器,nginx代理服务器因为带宽就会成为瓶颈,文件存储服务器存储的都是文件且数据比较大,电影、软件等;如果此时用nginx做反向代理就需要多配置一些nginx代理服务器,分成好几组去代理后边的文件服务器

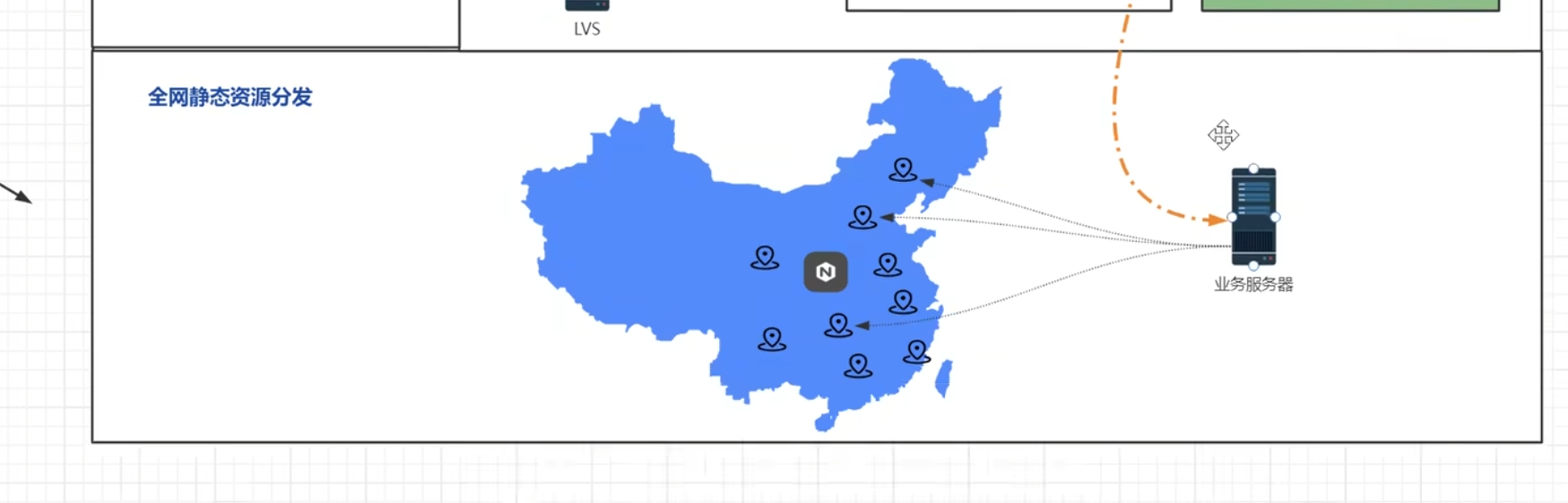

全网静态资源分发

不清楚这个是干什么的,没讲,先mark

Nginx反向代理配置

Nginx代理一个网址

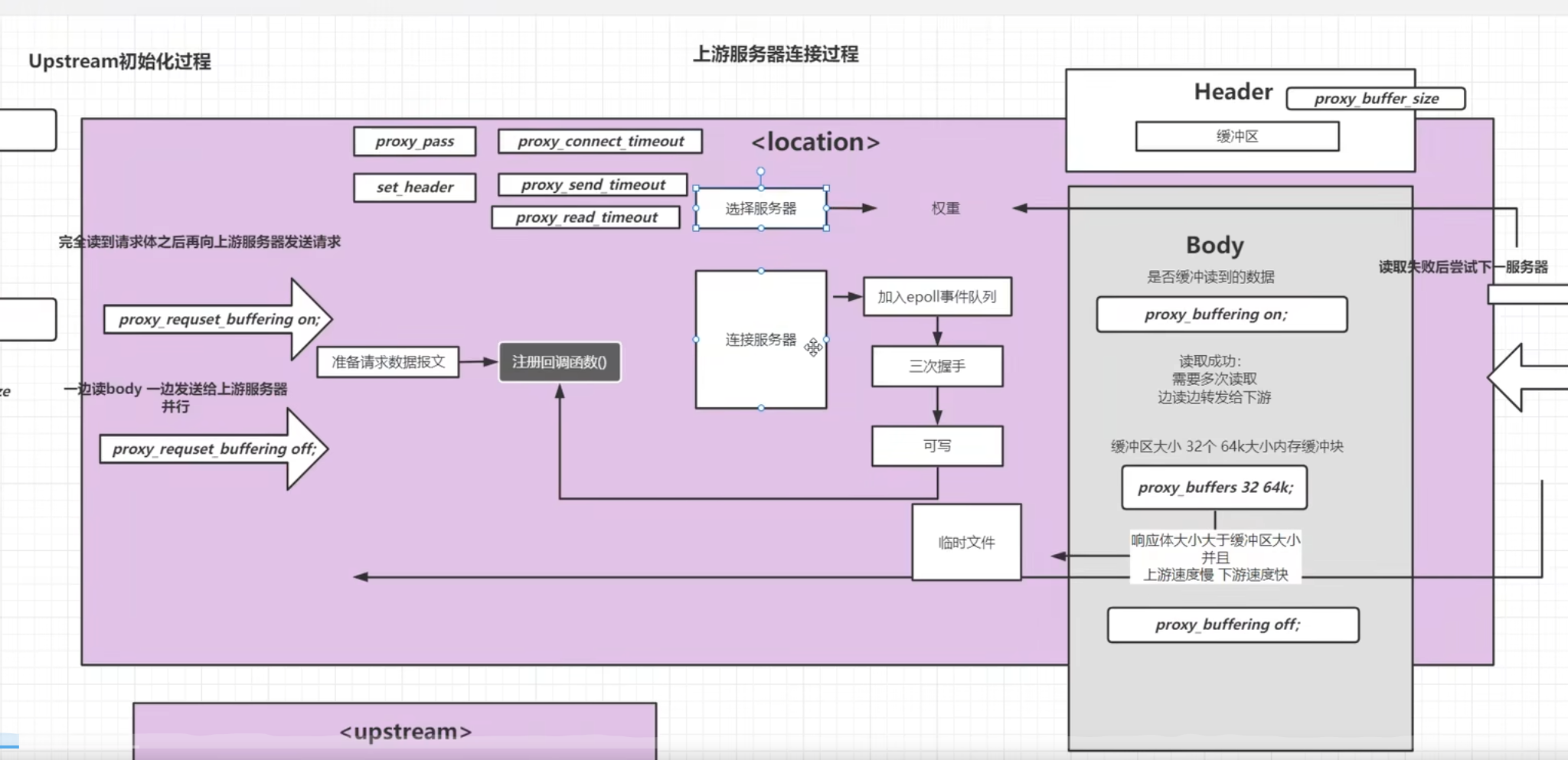

proxy_pass属性

proxy_pass在nginx.conf文件找那个的server.location中配置,在其他位置配置启动会报错,proxy_pass属性和root属性是二选一的关系,proxy_pass一旦配置,root属性【配置寻找静态文件的目录】就不能使用了,包括

静态资源目录和对应的路径静态资源映射。proxy_pass的属性值有两种,一种是要让nginx代理的地址,可以是一台具体的主机,也可以是一个网址;另一种是配置一组服务器代理一个网址时的nginx配置文件配置

能实现访问当前站点的根目录能跳转到网址https://www.baidu.com/上,但是跳转到百度上可能因为重定向的原因地址栏显示百度的网址了,使用尚硅谷的网址就不会出现这种问题

过程是用户访问nginx代理服务器,代理服务器根据proxy_pass将请求转发过去,拿到数据后返回给nginx,nginx再返回给用户

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;server {listen 80;server_name localhost;location / {#这里使用https协议的目前的nginx配置加载配置文件会报错#与前面类似,访问百度或者京东proxy_pass http://www.atguigu.com;root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}使用命令

systemctl reload nginx将nginx配置文件重新加载使用命令

systemctl daemon-reload用重启nginx服务访问效果

【跳转百度】

【跳转尚硅谷】

完全显示的是nginx代理服务器的ip

【使用自己的域名跳转尚硅谷】

如果proxy_pass的属性值不带www,请求nginx代理服务器会发生重定向

nginx.conf

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;server {listen 80;server_name localhost;location / {proxy_pass http://atguigu.com;root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}代理效果

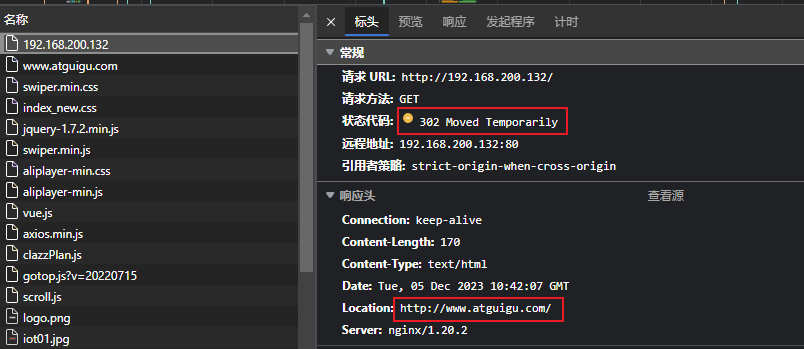

配置文件中的proxy_pass不带www,此时再用nginx地址访问

192.168.200.132地址栏会直接显示尚硅谷的地址

【执行效果】

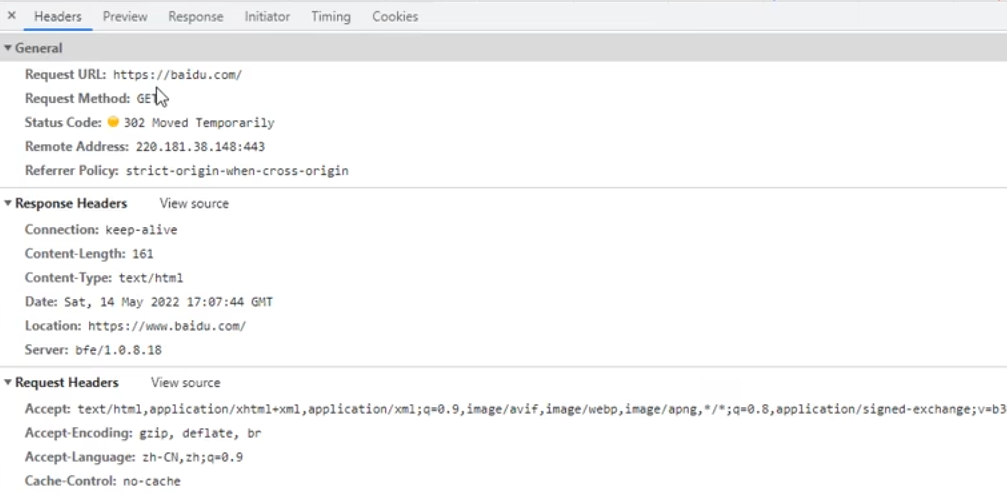

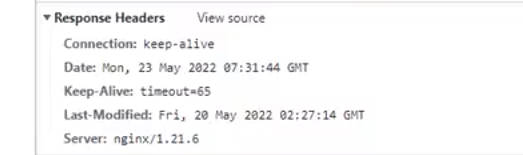

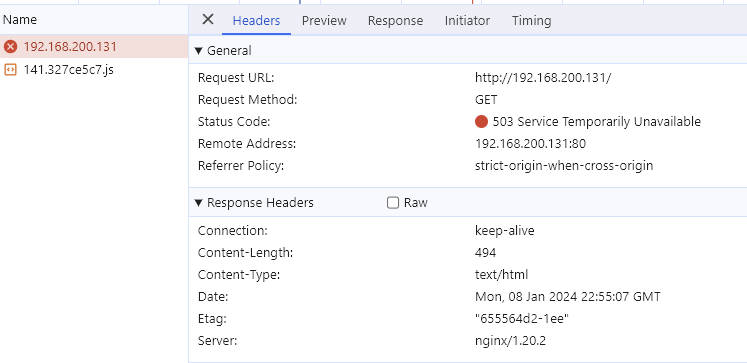

使用IE浏览器才能看见,Chrome是看不到第一个请求的,从信息中能看到nginx服务器的版本是1.20.2,原请求返回状态码302【http协议中的重定向状态码,让浏览器重新加载响应头中的location】,要求重新跳转,响应头中的跳转地址是

http://www.atguigu.com/跳转https协议的时候会发生相同情况,即302状态,location中是https的重定向地址;而且nginx.conf的proxy_pass不支持反向代理https服务器,https服务器需要与域名对应上【后面会讲证书和域名之间的关系】,据说https可以代理,只是https报错是因为没装openssl以及编译时没开启ssl模块

重定向的原因没讲,猜测是服务提供商针对其他域名做了重定向处理

Nginx代理一台主机

nginx代理一台主机

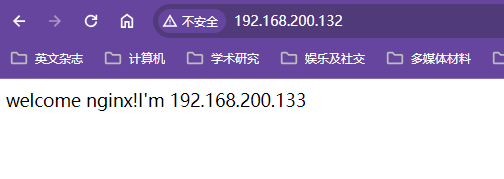

创建第二台虚拟机上

192.168.200.133的nginx,配置文件修改如下nginx.conf

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;server {listen 80;server_name localhost;location / {root html;index index.html index.htm;}error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}第二台nginx服务器访问效果

更改/usr/local/nginx/html目录中欢迎页添加第二台虚拟机的IP信息,用浏览器访问查看效果

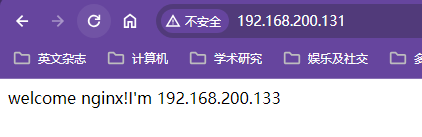

第一台nginx服务器的proxy_pass指向第二台nginx服务器

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;server {listen 80;server_name localhost;location / {proxy_pass http://192.168.200.133;root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}通过第一台nginx代理服务器访问第二台nginx代理服务器效果

这只是一台nginx代理一台服务器,还可以配置nginx代理到多台服务器上

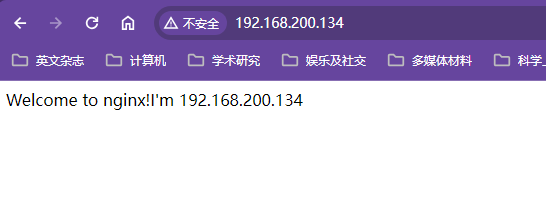

Nginx代理多台服务器

创建第三台nginx虚拟机

nginx服务器访问效果

基于反向代理的负载均衡

一台nginx把请求代理到应用服务器后还会有非常多的服务器集群

负载均衡器

女朋友一个月总有几天不能用,不能用怎么办,找一个备胎,不能用的时候备胎续上,服务不行了就下线

nginx对服务集群做反向代理可以添加负载均衡功能,负载均衡策略(算法)包括轮询、IP哈希、定向流量分发、随机,以满足服务下线维护,短时间故障期间的服务正常提供

存在请求已经发送给服务器,但是才发现服务宕机,此时产生一种retry【重试】机制来解决这个问题,再去找一台正常的机器来处理该请求

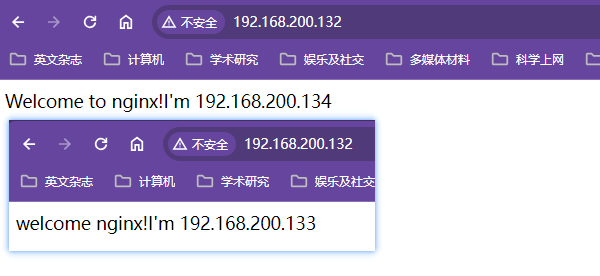

配置负载均衡

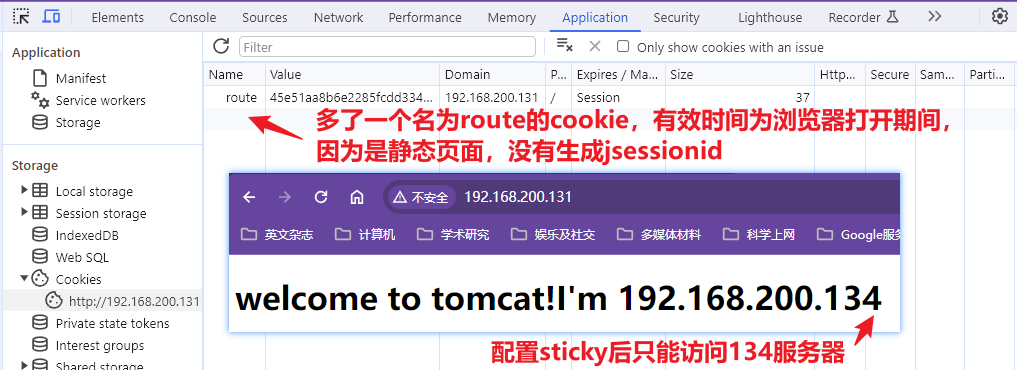

负载均衡的配置需要和proxy_pass配合使用,配置了三台nginx服务器,想要实现在第一台nginx服务器上负载均衡访问第二台和第三台nginx服务器,访问第一台nginx服务器一会儿显示133服务器,一会儿显示144服务器

当反向代理服务器需要代理多台服务器时,需要将proxy_pass属性的属性值弄成

http://自定义名,这个自定义名是随便起的,可以用来代替服务器IP,但是要和upstream 自定义名中添加多台代理机器的IP和端口号【为了统一,将端口号也配置上,80端口不写其实也是可以的,规范一点】,upstream 自定义名和server是同一级的配置,配置详情见nginx.confxxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;upstream proxyServers{server 192.168.200.133:80;server 192.168.200.134:80;}server {listen 80;server_name localhost;location / {proxy_pass http://proxyServers;root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}多台机器负载均衡效果

但是没有讲怎么配置nginx对多台服务器的代理,这里添加了负载均衡,去掉负载均衡就是配置对多台服务器的代理效果

负载均衡策略也是轮询策略,轮询应该是nginx默认的负载均衡策略

Nginx负载均衡策略

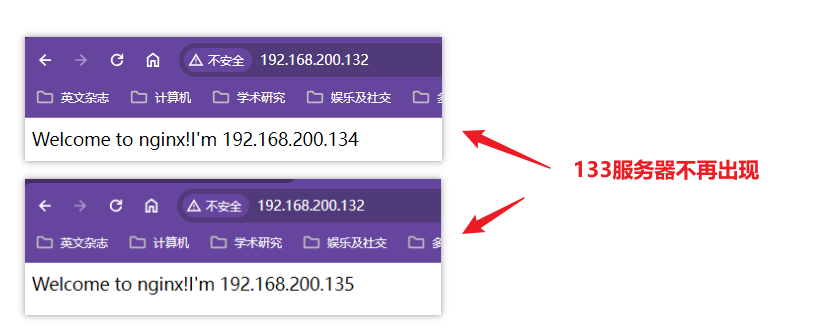

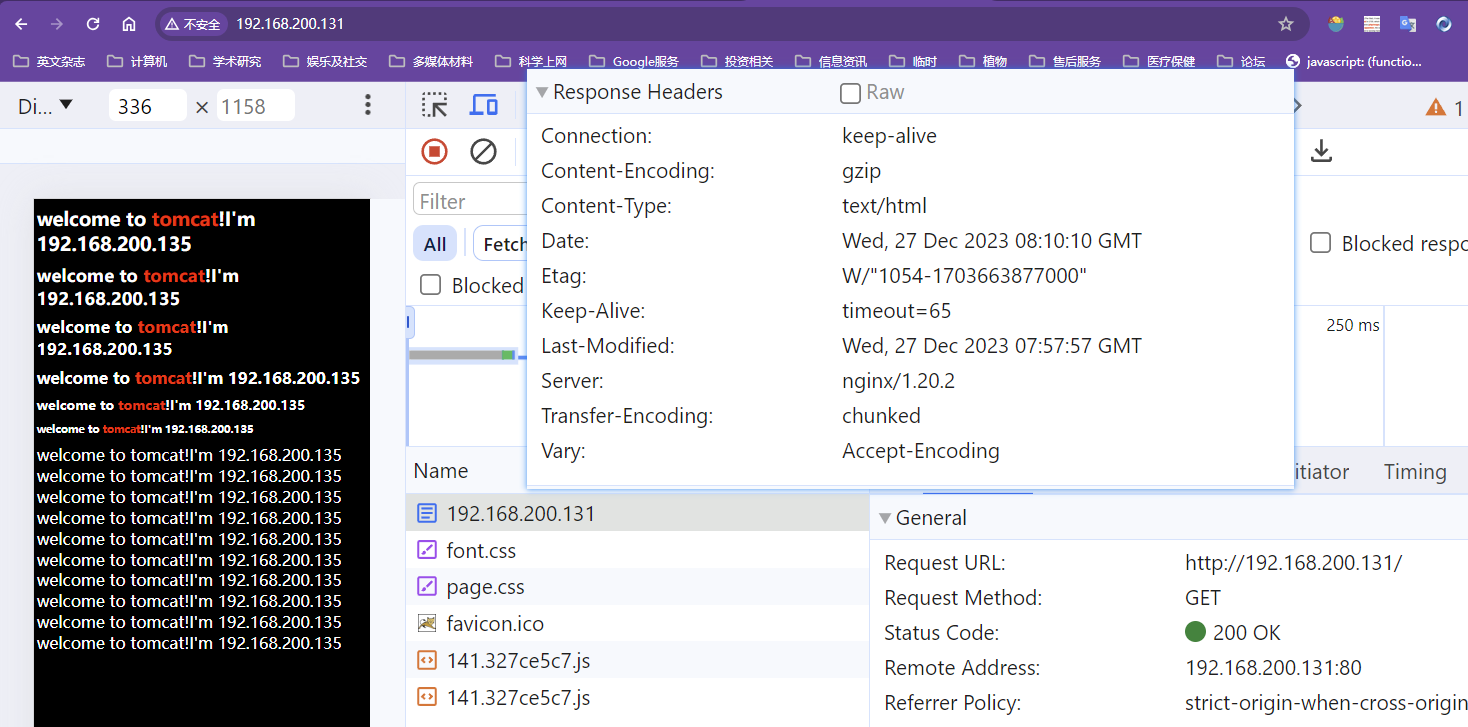

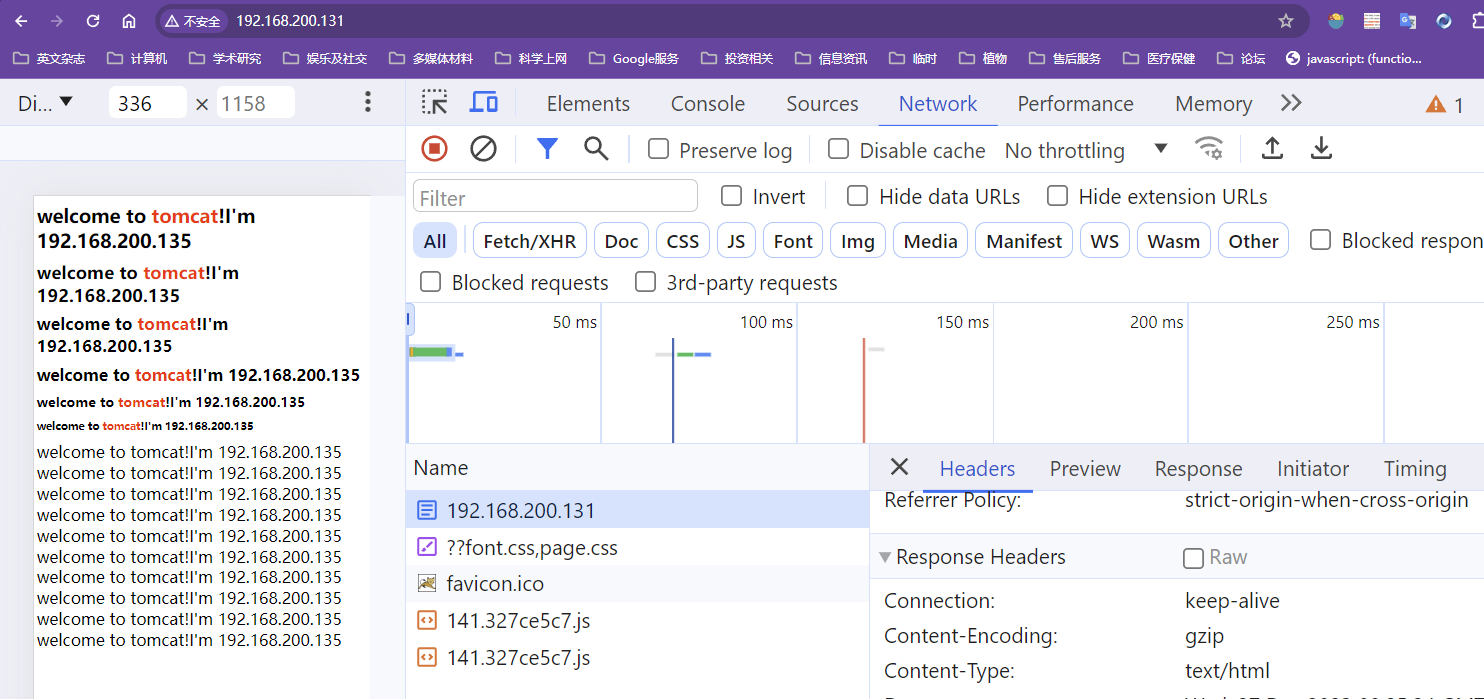

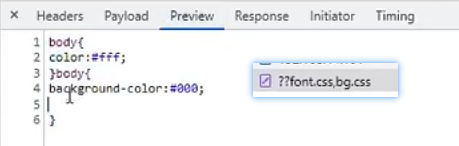

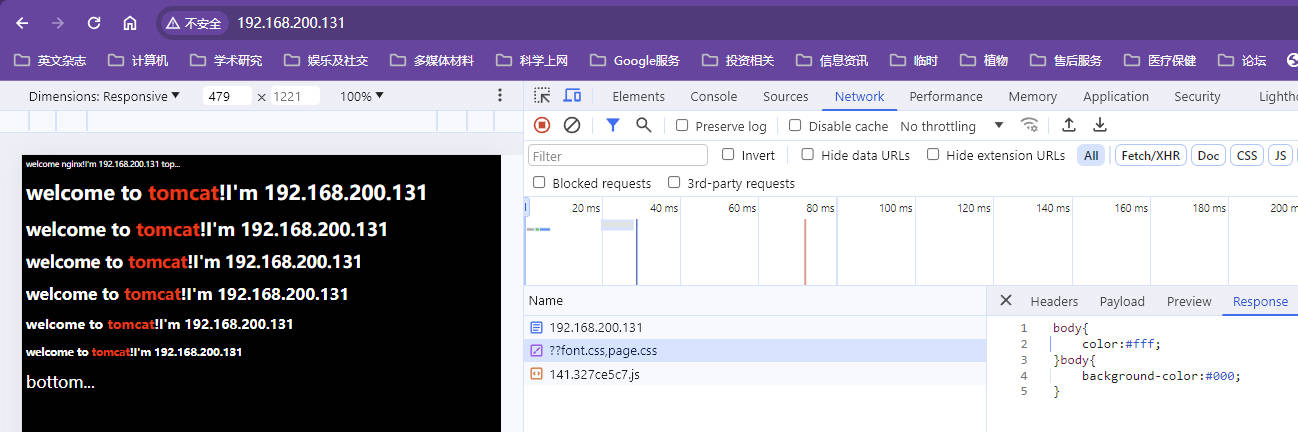

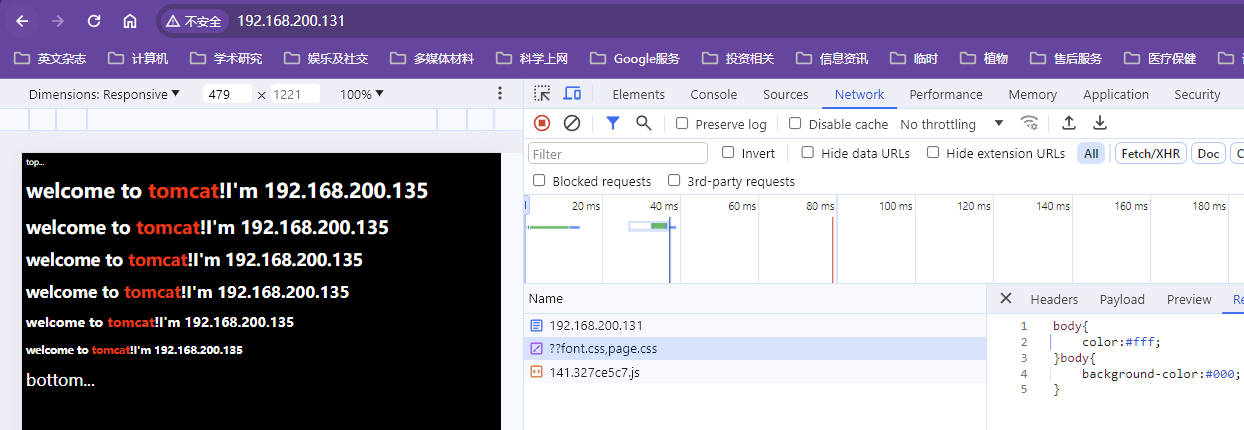

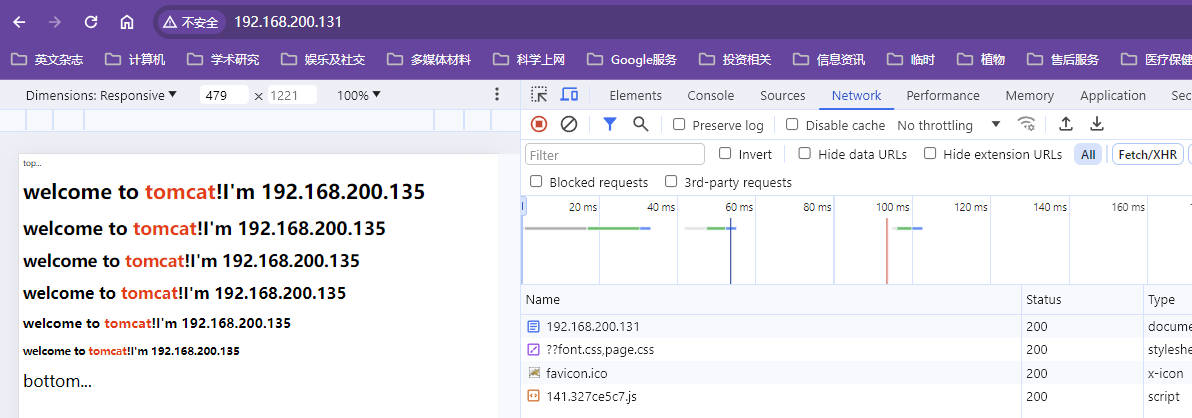

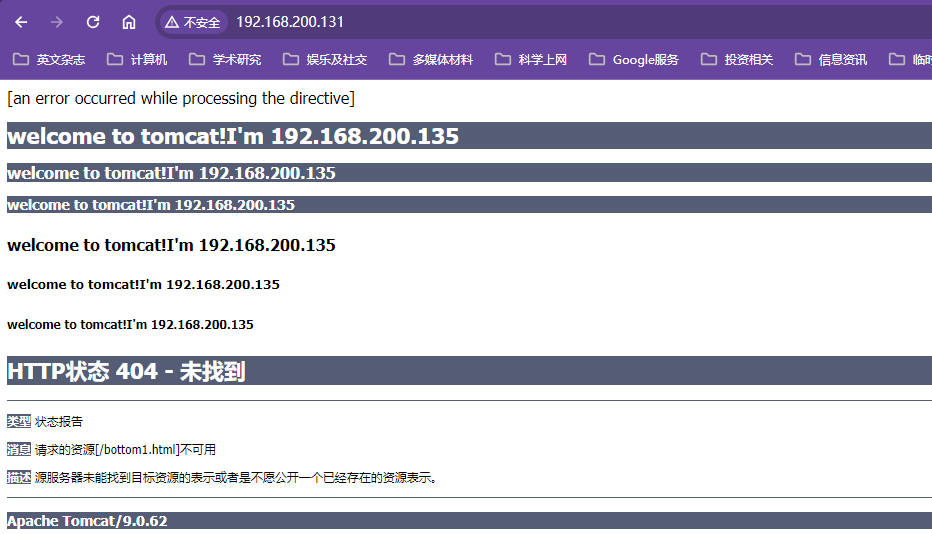

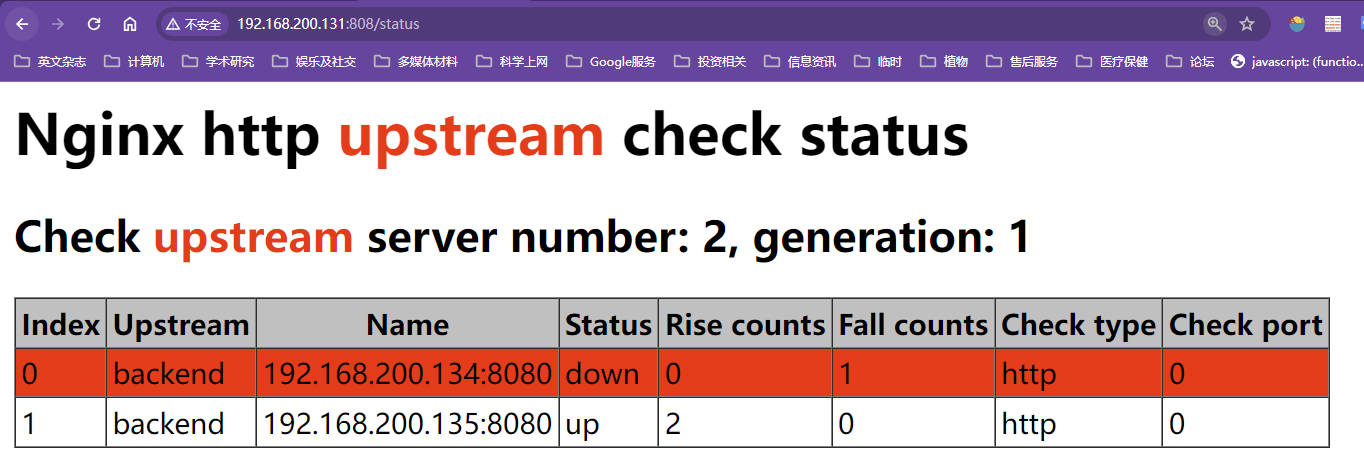

准备了一台nginx代理服务器和三台用来测试负载均衡策略的nginx服务器。ip分别为

192.168.200.132,192.168.200.133,192.168.200.134,192.168.200.135,用132作为代理服务器剩余三台作为被代理服务器测试负载均衡策略,以上服务器都在欢迎页添加了服务器IP信息动态分配nginx服务器的上下线,仅靠nginx的基础命令如down和backup是不行的,一般来说,所有在线机器都挂掉,很有可能是程序运行导致服务器出现共性问题宕机,备用服务器上线也不一定好使,所以实际down和backup都不常用,down需要修改配置文件并在服务器reload一下,这样一般是来不及的,有这个时间可以考虑直接再向集群中再加入一台服务器,所以down和backup实际生产中使用比较少,负载均衡的权重是比较有用的

权重

权重负载均衡策略

给每台服务器设置权重值,有的服务器配置比较高或者网络出口带宽比较高,比如133机器的网络带宽为1000M,134机器的网络带宽为100M,设置133的权重为8,设置134的权重为2,设置135的权重为1;使用nginx代理服务器做负载均衡,每八次请求访问133机器后,每两次请求访问134机器,每一次请求访问135【并不是完全按照8-2-1的顺序执行的,是多次请求中的访问比例满足8:2:1】

nginx.conf

配置被代理服务器的权重是在upstream中server后面配置weight属性

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;upstream proxyServers{server 192.168.200.133:80 weight=8;server 192.168.200.134:80 weight=2;server 192.168.200.135:80 weight=1;}server {listen 80;server_name localhost;location / {proxy_pass http://proxyServers;root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}测试效果

Down服务下线

down可以让某些机器不参与负载均衡,相当于服务直接下线,不再提供服务

nginx.conf

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;upstream proxyServers{server 192.168.200.133:80 weight=8 down;server 192.168.200.134:80 weight=2;server 192.168.200.135:80 weight=1;}server {listen 80;server_name localhost;location / {proxy_pass http://proxyServers;root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}测试效果

Backup备用服务器

备用服务器,指正常情况下不使用被backup标记的服务器,只有其他的机器实在没得用了,才用备用的服务器

nginx.conf

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;upstream proxyServers{server 192.168.200.133:80 weight=8 down;server 192.168.200.134:80 weight=2 backup;server 192.168.200.135:80 weight=1;}server {listen 80;server_name localhost;location / {proxy_pass http://proxyServers;root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}测试效果

使用命令

systemctl stop nginx能停掉nginx服务

其他负载均衡策略

除了轮询和权重,其他的负载均衡策略声场上基本不使用,只做了解即可,最核心的问题是这些负载均衡策略无法做到服务器动态上下线,即即时的上下线服务器;类似hash值映射服务器的对应映射都写死在配置文件中,服务器上下线非常的不灵活死板,特殊场景使用这些方式需要结合Lua脚本在nginx中去编程来动态的管理当前服务器列表,可以动态的监测后端服务器的上下线情况,用程序配置权重值,做定向流量转发以及定向用户转发【定向用户转发存在严重的流量倾斜问题,非常容易造成几台服务器繁忙,几台服务器空闲的情况】,实际生产要么直接使用轮询的方式【存在无法保持会话的问题】,要么就用lua脚本去自定义请求转发规则,直接使用第三方插件的方式非常不灵活

轮询存在无法保持会话的问题:用户登录tomcat服务器,会将用户的状态存储在session中,这个用户状态只是存储在当前这一台tomcat服务器中【但是不是可以通过token令牌实现单点登录吗? 】,其他tomcat服务器中没有存储对应的session,此时用户的访问会被拒绝,凡是需要session的操作都会出现问题,单纯使用轮询负载均衡策略是会出现问题的

ip_hash

nginx会根据请求来源的ip地址将来源相同的请求转发给同一台服务器

存在问题,比如手机的信号时好时坏【比如乘坐高铁飞机移动速度很快】,通信商为了维持信号,将信号切换了一个移动基站,此时ip地址变化,没法保证处在不同地方的移动请求一定访问同一台服务器,无法保持会话状态

所以一般也不会用ip_hash来做负载均衡保持会话状态

least_conn

最少连接数的访问,目的是让后端服务器更加均衡,原理是将每次请求转发到连接数最少的服务器上,

这种方式在实际生产中也有很大的缺陷,服务器的连接数少可能是考虑到机器性能给其配置的权重比较低,才会造成流量倾斜,

正常情况下,不同服务器之间的连接数差异很大这是不大可能发生的;

即使在新加入机器的时候,此时除了新加机器,其他服务器全部进入reload阶段,即不接收新的请求,只处理已经接收的请求,等到新加机器正式上线,所有服务器此时的连接数都趋近于0。只有比较耗时的请求,比如需要两分钟才能解决的请求,才会出现连接数偏差较大的情况,但是几乎见不到这样的请求处理方式【用户点击一下,等待2分钟跳转页面,如文件上传,异步任务呢?如文件上传下载服务器?我真牛逼,马上就讲了除非异步化的处理,以消息队列的方式等待慢服务处理完成以后讲处理状态通知给用户即可,也不需要业务服务器进行长时间的处理并让用户一直等待】,所以这种负载均衡方式没有常用的场景,权重方式下还要慎用,所以几乎看不着这种方式的使用

fair

这种方式需要使用第三方的插件,配置到原始的nginx中才能使用,这种方式根据后端服务器的响应时间来转发请求,这种方式也不是很合理,

响应时间长短还和网络延迟【交换机过热就会造成网络延迟比较高,当前服务器和其他服务器接入的网络交换机不是同一个,就可能存在网络延迟差异的情况,导致网络延迟小的服务器会短时间处理大量的请求,可能直接就将服务器压垮了】、业务逻辑有关系,如果只根据响应时间来判断转发逻辑,会造成短时间内响应时间短的服务器的请求突然急剧增加,短时间内就可能压垮服务器,实际响应时间长的服务器空闲的很,

因为存在流量倾斜的风险并且需要下载第三方插件,所以实际生产这种方式使用的也比较少

url_hash【定向流量转发】

url_hash默认也是不支持的,也需要第三方插件,url_hash是定向流量转发,不一定是定向的用户转发,ip_hash就是定向的用户转发,根据用户的请求url如

http://atguigu.com/register计算哈希值,相同哈希值的url转发到同一台服务器上,这就是定向流量转发,比如登录和注册的哈希值不同会转发到不同的服务器上,在这种情况下,会话状态也无法保持,比如刚注册就要用户登录,这种方式比较适合访问固定资源不在同一个服务器【比如100个文件散落在不同的服务器,此时就可以根据URL去定位文件在哪台服务器上】的场景使用,几乎只有这样一种情况才需要用到url_hash

通过$request_uri做负载均衡

使用场景:访问相同url会转发到同一个服务器,适合用在没有cookie的场景如手机APP,将jsessionid直接带在url的最后,即使相同的请求也能根据jsessionid的不同将用户分配到特定的服务器来管理会话【如果只是集群系统并不是分布式系统下能这么用吧,而且uri整体计算的哈希值也可能不同啊,为什么能保持会话,这不是和url_hash是一回事吗?】

这个是将系统扩容会话管理的时候讲的,不知道和url_hash有什么关联没

在不支持cookie的情况下【手机上的APP不支持cookie】可以直接把jsessionid直接带在URL的后面,根据用户的jsessionid来对用户进行会话管理【存疑,是对jsessionid做哈希还是对整个uri做哈希,对整个uri做哈希还是可能被派发到其他服务器上,一样无法维持会话,而且还得是单一系统的集群才行啊】

第二种情况就是类似url_hash的情况,当资源有所倾斜的时候,根据uri去确定资源位于哪一台服务器上【比如流媒体服务器,文件太大,不可能分发到所有的流媒体服务器上,也没有必要】,文件上传的时候根据请求的url算出哈希值放上对应的服务器【还是有一些问题,如做集群,其实都能解决,再代理一台给集群做负载均衡,虽然不太优雅,实际方案不了解,有机会学习一下】

会话状态保持

保持会话状态一般不用nginx自带的负载均衡策略,这些负载均衡策略为了会话状态保持业务方面肯定会出问题

轮询无法保持会话状态

ip_hash可以保持会话状态,但是这种方式并不好,存在严重的流量倾斜问题且移动端ip随基站变化会发送变化,

java中存在基于客户端的会话保持工具,因为后端服务器只要做到轮询就没办法做到有状态【有状态指在独立的服务器上存储用户的固定信息,比如session就是用户状态信息,服务器存储了session才会 】,解决方案:

springSession默认解决方案把session单独存在redis服务器上,根据请求的cookie在本机找session,找不到就去redis服务器上找session【这也是最基本的集群化session共享,session不会每台服务器都存一份】,这种方式不适用于高并发场景,

高并发情况下需要使用真正的无状态会话token;用户请求到nginx服务器,nginx服务器会转发到一台专门负责权限校验认证的服务器,当用户登录校验完权限后给用户下发权限,权限记录成一个比较长的字符串或者记录在文件中并根据用户登录时间和有效期限以及服务器密码生成加密token,将token下发到客户端,客户端无法对token进行更改,客户请求带token,服务器不存储客户状态,只拿token做校验,只有服务端有密码可以解开token的加密信息【?拿到别人的token在别的客户端使用怎么办,大佬们说是可以的,但是拿不到token,以后看能不能回答这个问题】,这也是现在比较主流的方式

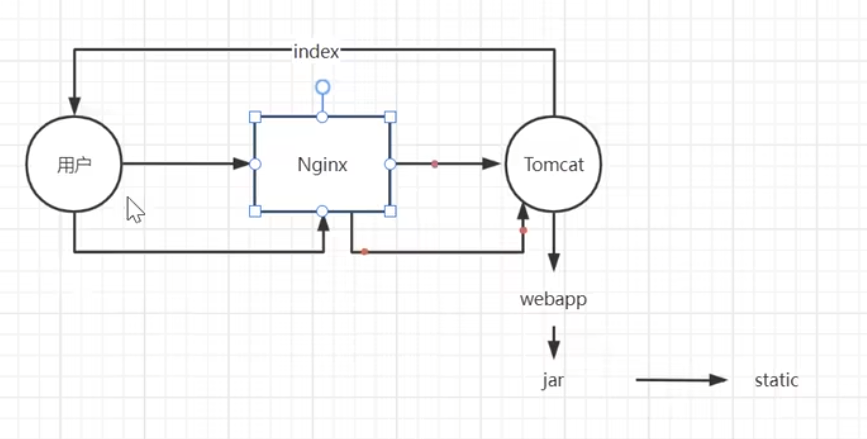

动静分离

动静分离适合中小型的网站,大型网站一般不这么操作,因为小型网站的并发量不高,且需要分离出来的静态资源不是特别多,把这些静态资源挪niginx中,如果是大型系统那么文件就太多了【淘宝,用户上传的文件就非常多,买家秀,卖家秀,商品介绍都属于静态资源,不适合使用动静分离这种简单的技术架构,适合初创企业、网站H5内嵌到APP或者网站中展示,也适用于ERP系统等传统项目】

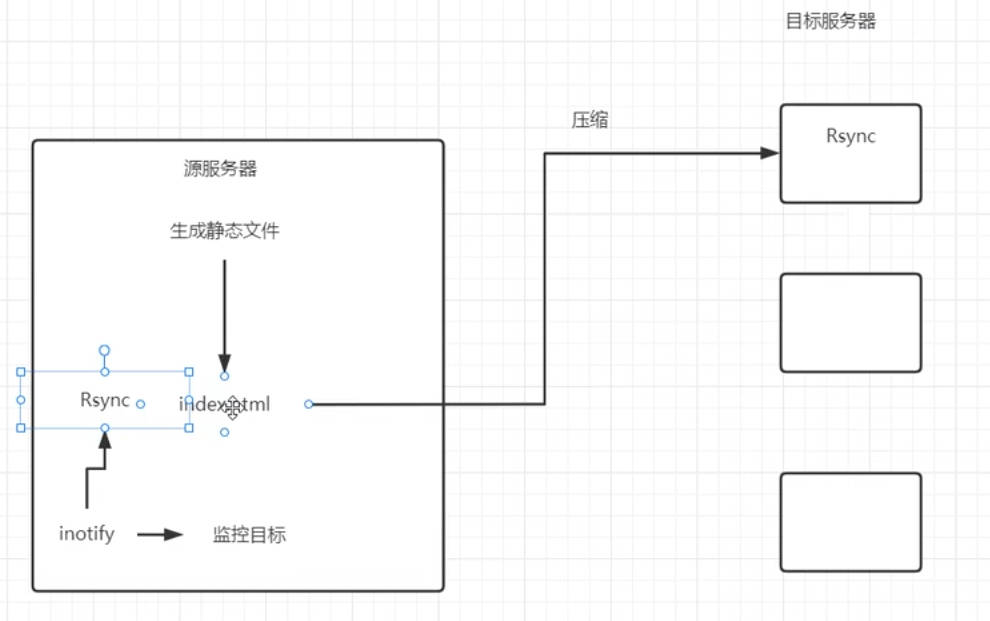

动静分离架构

动静分离可以起到给系统加速的作用,用户请求通过网关,很多时候只需要展示一些图片,js、css等静态文件;此时可以把这些文件放在nginx中,不让这些请求进入后端的服务器,因为一个网页一般都是一个动态响应的主页+内嵌的数个静态资源,不使用动静分离的情况下,所有的请求都会被代理到tomcat,一个网页可能会有上百个请求,还有nginx代理转发的过程,这样不好;如果把静态资源全部前移至nginx,让nginx来响应这些静态资源的请求,让tomcat专心于动态请求的处理,通过动静分离给系统加速

【传统静态资源架构】

用户请求被nginx代理到tomcat,原本项目全部部署到tomcat服务器的某个目录下如webApp,webApp中包含项目类似于SpringBoot相关的jar包,jar包的static目录中会包含一些静态资源,static目录下的静态资源可能存在文件无法上传的问题【可以通过配置配置在外部目录中】,第二个问题是tomcat会响应很多非动态的请求,用户请求打到网页,网页会内嵌很多的图片、css、js资源,一次请求无法完成任务,用户请求到tomcat,tomcat会返回一个主页index.html,这个主页中会镶嵌很多的图片等静态资源,用户此时还会发起请求给nginx,再被代理到tomcat上去找相关的静态资源

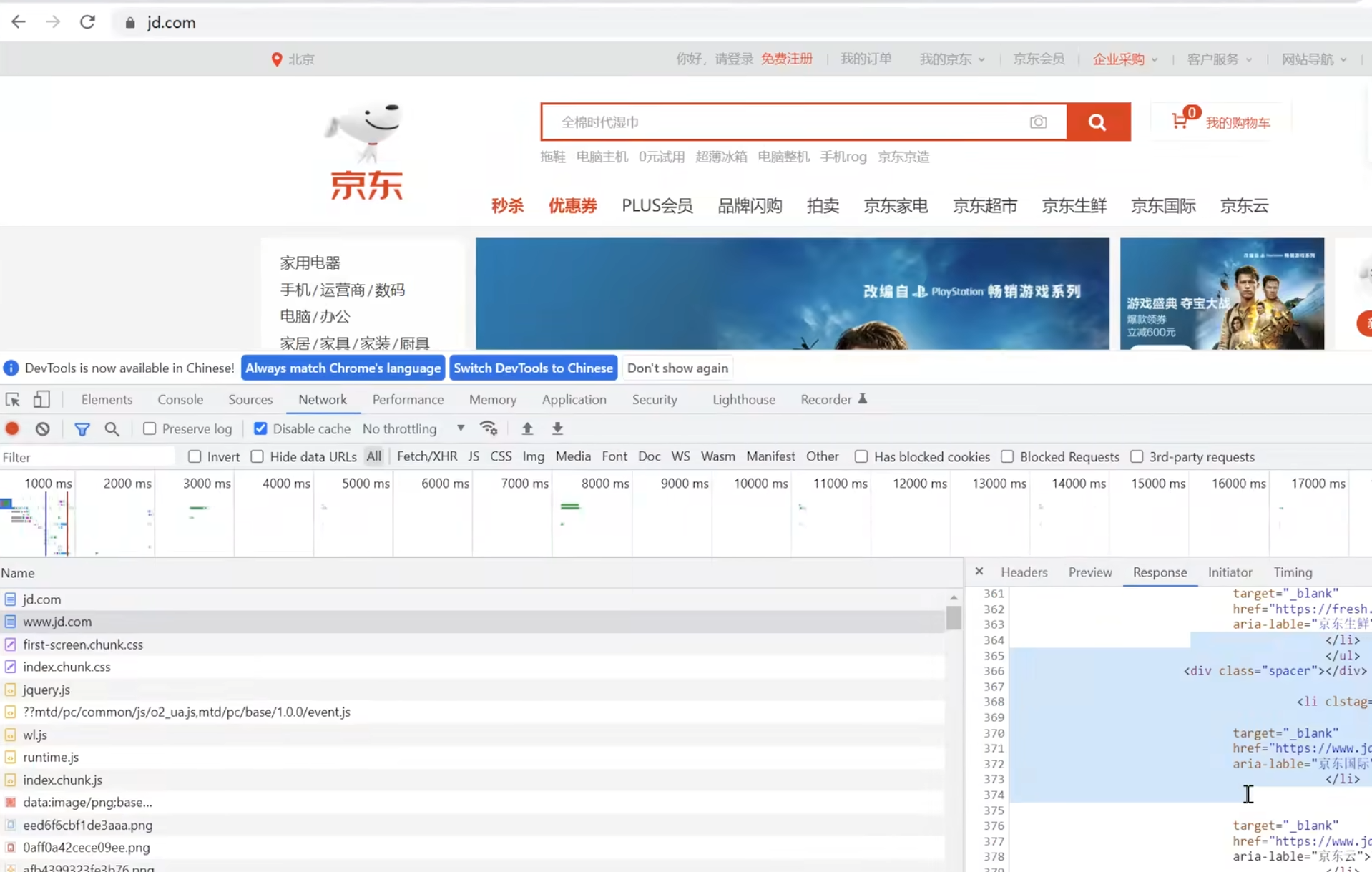

【多次请求说明】

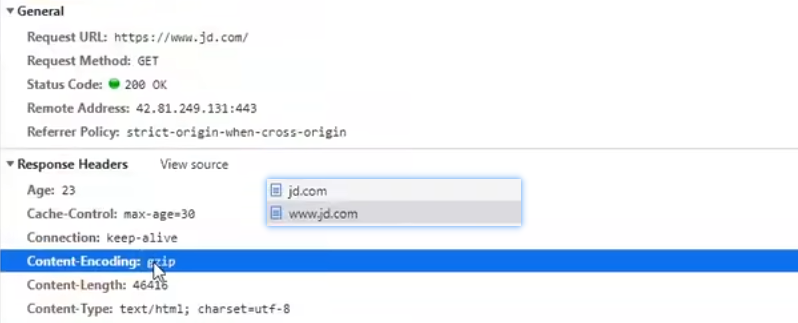

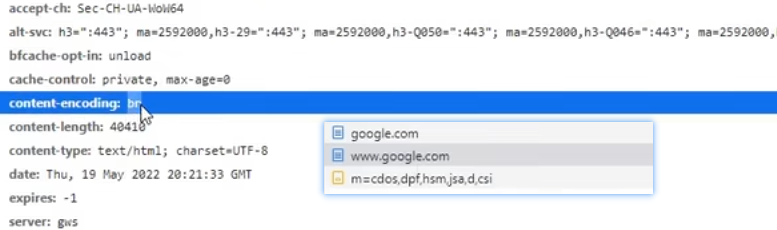

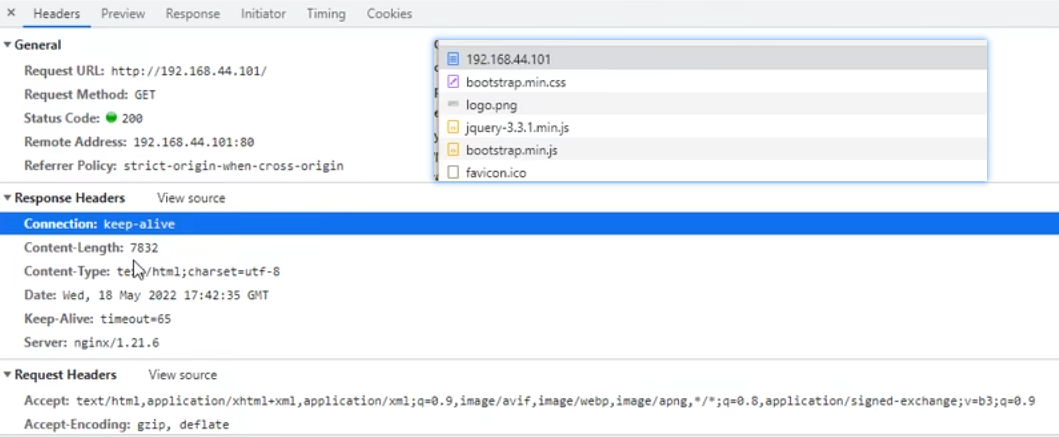

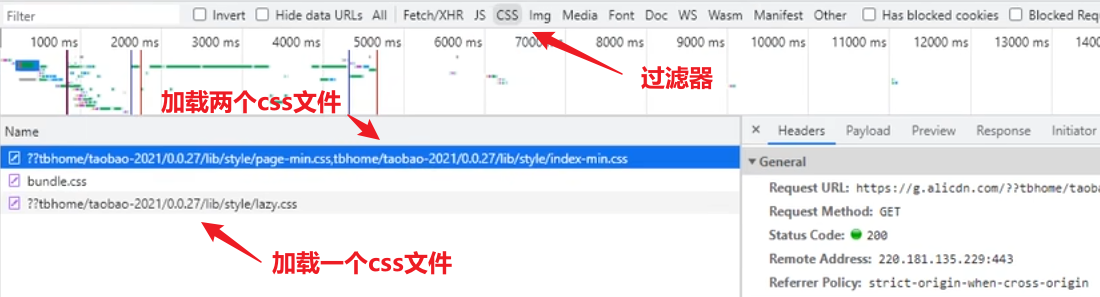

www.jd.com的响应就是一个静态页面,这个响应一般是后端的动态服务器返回的静态页面,该静态页面关联了非常多的图片,css文件,js文件资源,会同时再次并发发起N多个请求给服务器,使用传统架构,这些请求都会并发打到tomcat上,而且页面只要移动,很可能还会发起新增请求,比如鼠标滚轮加载页面,课程演示时又多了100多个请求,都是页面内嵌的图片等静态资源;tomcat的功能主要响应动态的请求,将这些静态资源前置到nginx可以将动态请求和静态请求分离开,静态资源的请求不需要再被代理到tomcat,直接就被nginx处理了响应了

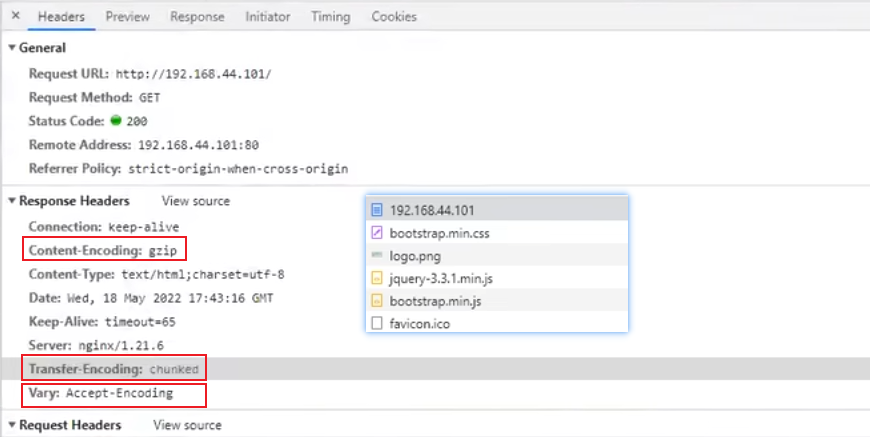

配置动静分离

传统项目经过这样的改造能够大大提高系统的并发量,因为静态文件全部都交给nginx来处理,nginx处理静态文件的能力和tomcat处理静态文件的能力不相上下,不像网上传闻nginx的QPS有两万,tomcat为800完全是胡扯,因为现在java、tomcat已经比较先进了,先进在于利用操作系统底层的NIO,操作系统内核支持高性能网络数据的传输,才能达到这么高的性能,但是每次建立连接tomcat还是会有额外的会话级别的开销,开销还是比nginx高,性能比nginx略低,但是低的不多,因为现在还有keepalive技术的存在,

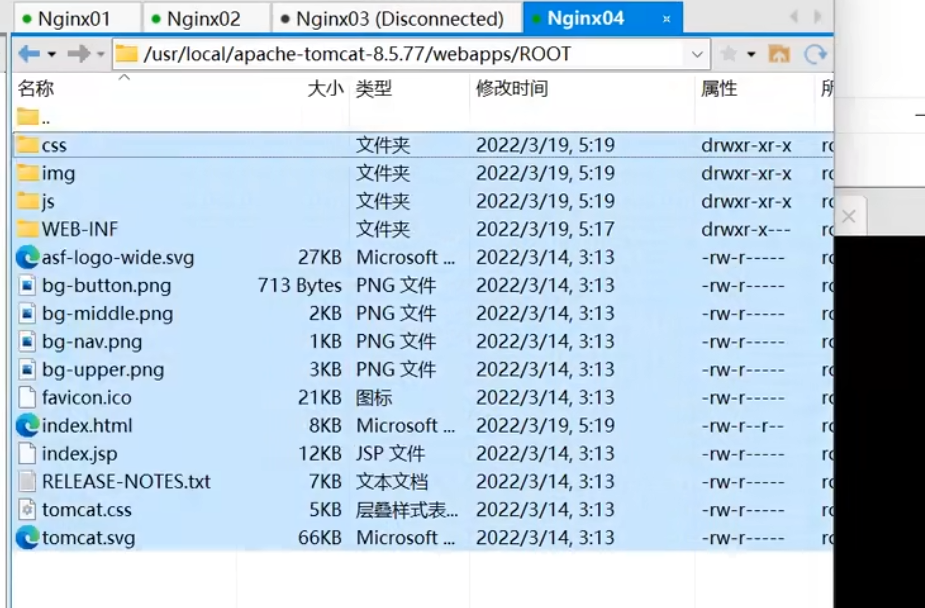

tomcat服务器中的静态资源

tomcat动态服务器上的静态资源,tomcat跑在8080端口

没有资料,有资料我高低也部署一个

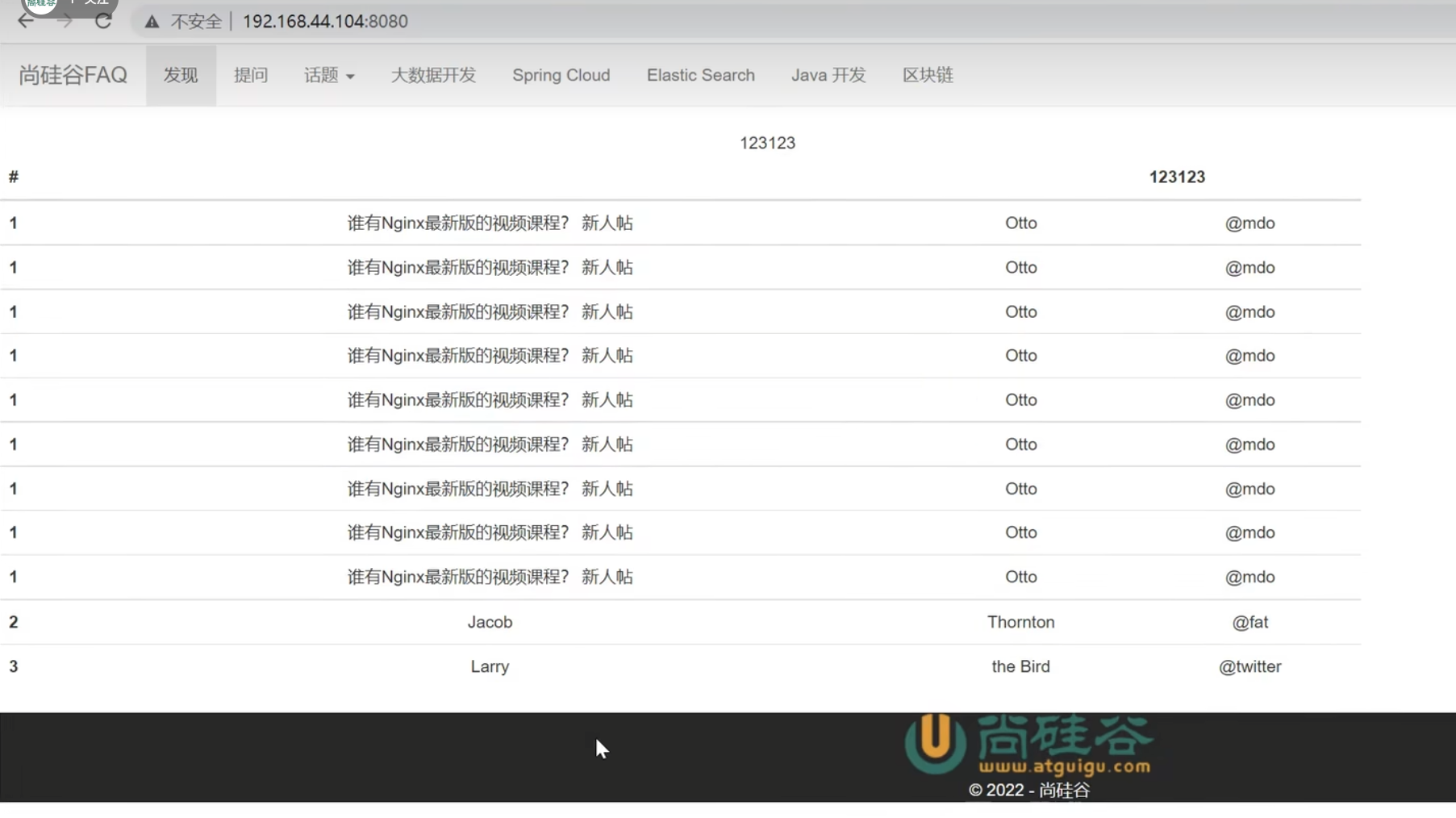

【tomcat中欢迎页的访问】

【源码】

F12Source选项卡下

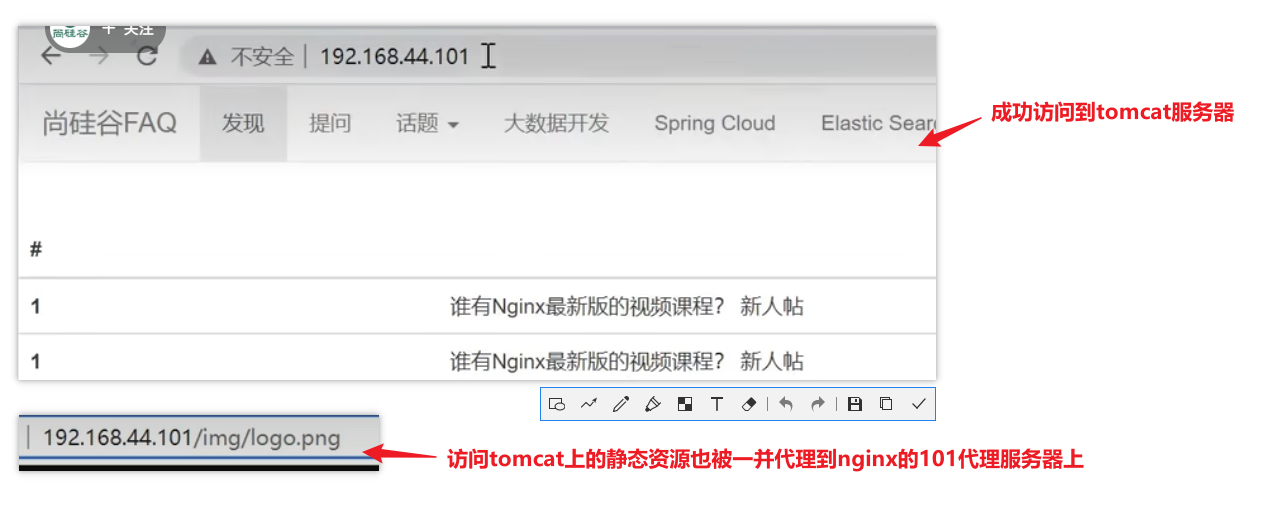

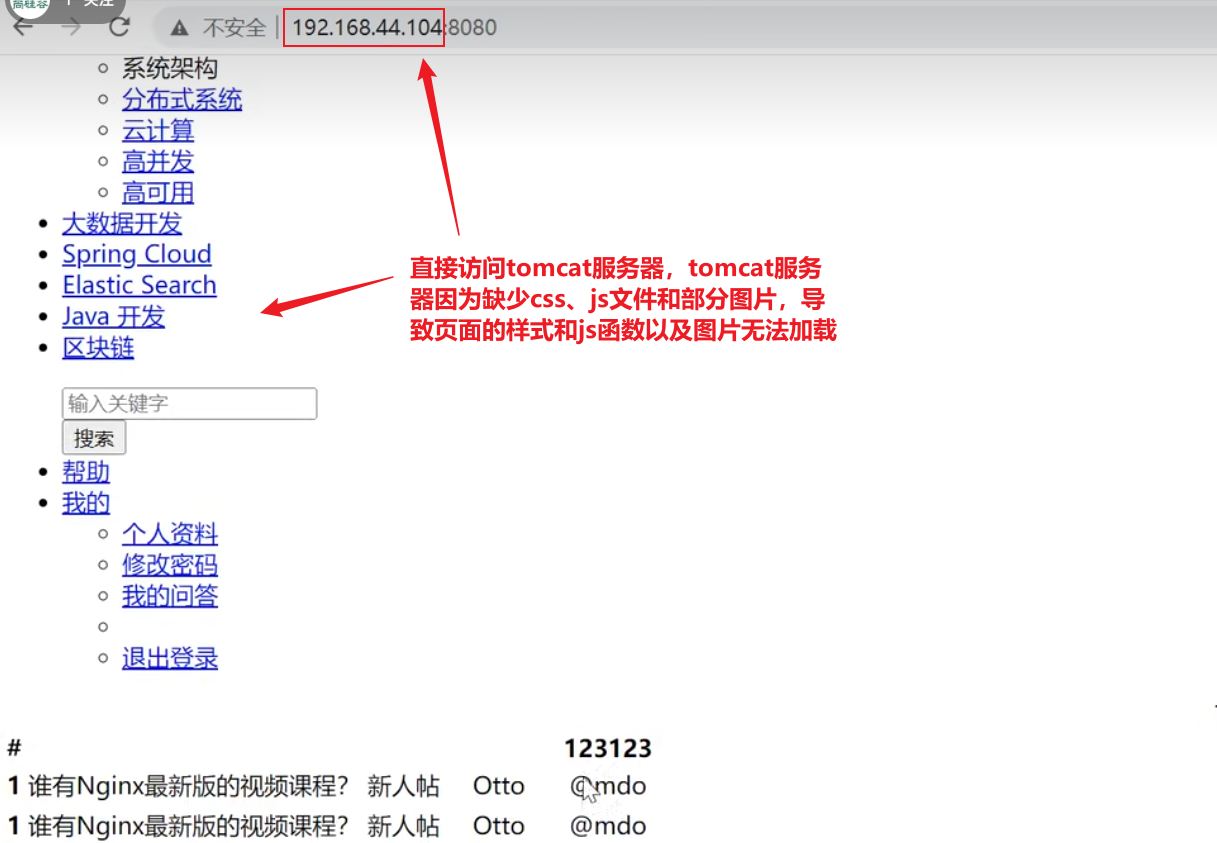

nginx对tomcat服务器的初始配置

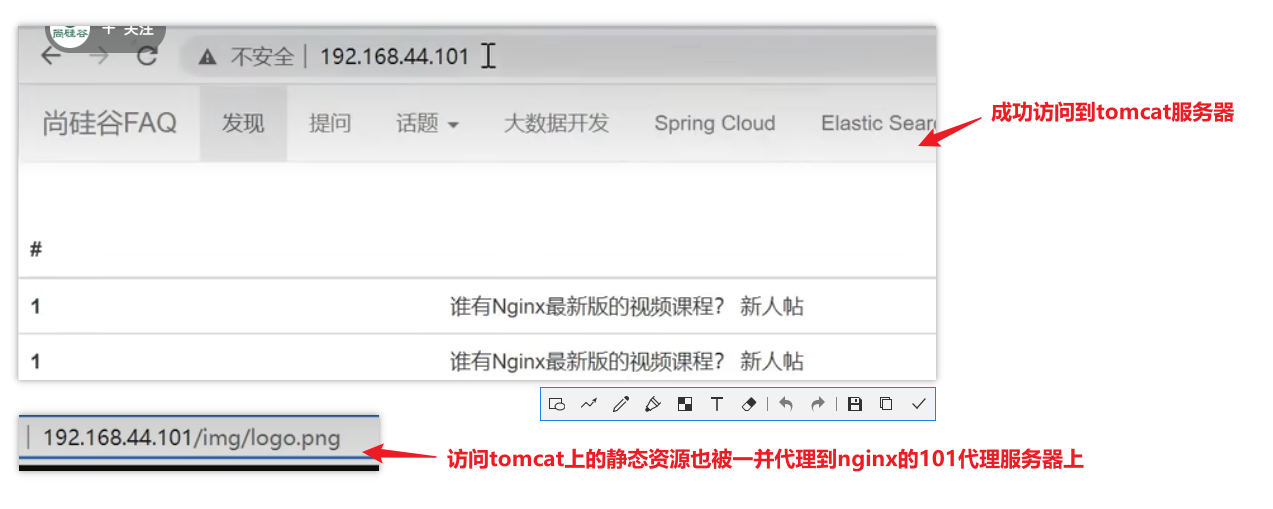

nginx和tomcat在两台虚拟机上,没有搭建项目,借用尚硅谷张一鸣老师的配置演示效果

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;#因为proxy_pass已经指向tomcat服务器的ip和端口号,这个upstream实际已经不认识了,但是不会报错,显示也应该只显示tomcat服务器内容upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.103:80 weight=2 backup;server 192.168.44.104:80 weight=1;}server {listen 80;server_name localhost;location / {#proxy_pass指向tomcat服务器的ip和端口proxy_pass http://192.168.44.104:8080;root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}【测试效果】

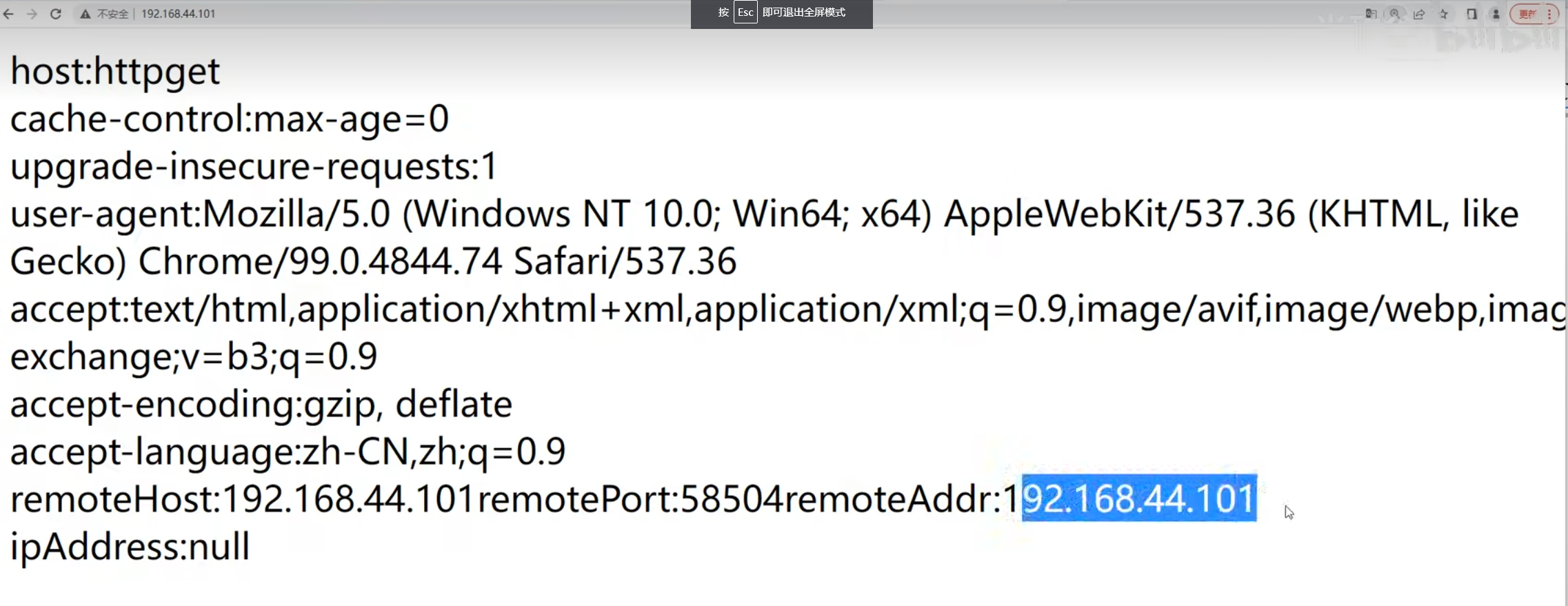

104ip上的8080端口的tomcat成功101nginx代理服务器代理

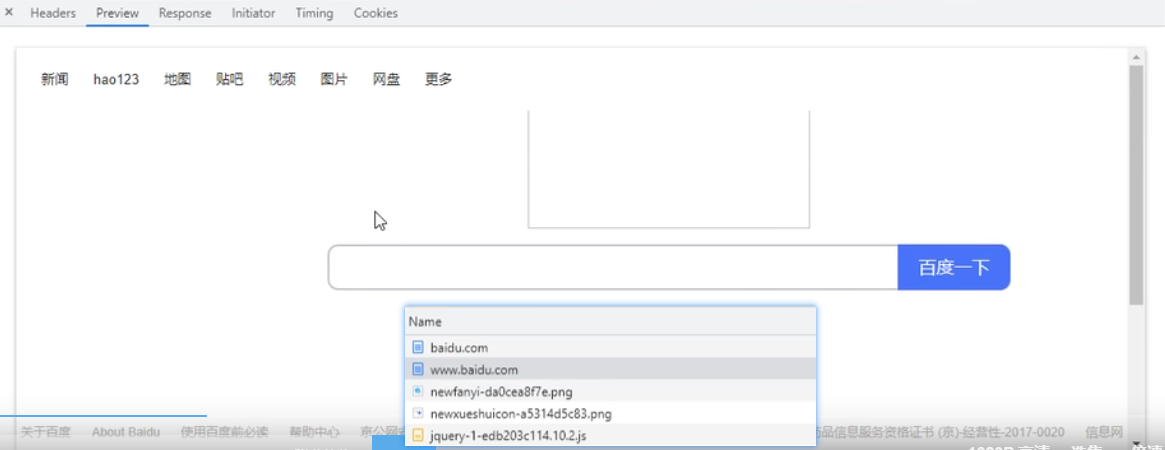

访问tomcat过程解析

用户首次访问tomcat有一个会话的概念,即session,不管用户请求啥都会去检查session,而且tomcat运行在JVM中,执行效率从语言层面来说略低于nginx,首次连接tomcat会生成session并保持链接【keepalive】,因为keepalive可以复用之前的网络连接通道,不至于创建出无数个连接诶;比如同时有200个请求打个tomcat,可能中间会握手连接十几次,连接都会得到复用,因为大多文件请求是瞬时的过程,

以京东为例,请求后的页面加载不是一次性加载完毕,分多个阶段,当滚轮滑到一定位置需要展示时才会去加载资源,不至于资源加载请求的并发量特别的高,比如一次并发二三十个请求,建立十几二十个链接,再有这种请求时还会复用之前的连接,

tomcat还会利用底层的一些技术如epoll【高性能网络接口,网络数据传输变得很快,只是java和tomcat调用的系统底层实现】、

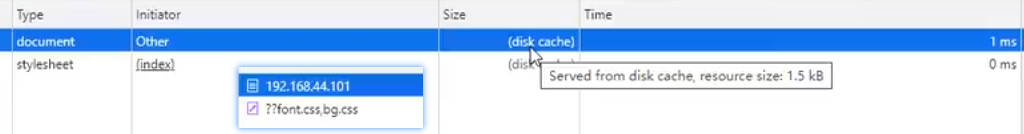

静态和缓存一类的东西利客户端越近越好,减少网路开销,在内网环境下,nginx转发静态资源请求给服务器,nginx再接收服务器的静态资源是没必要的开销,让nginx读取静态资源响应给客户端效率最高,资源开销最小

简单配置

缺点:根据请求路径匹配站点目录【路径匹配规则,优先匹配最长的,最长的匹配不了再匹配短的。所以先匹配下面的】,目录多的情况下location要配置非常多,不像虚拟主机的server_name的配置属性值能写很多个

nginx对静态资源的第一种简单配置

适用于静态资源少,目录少的情况

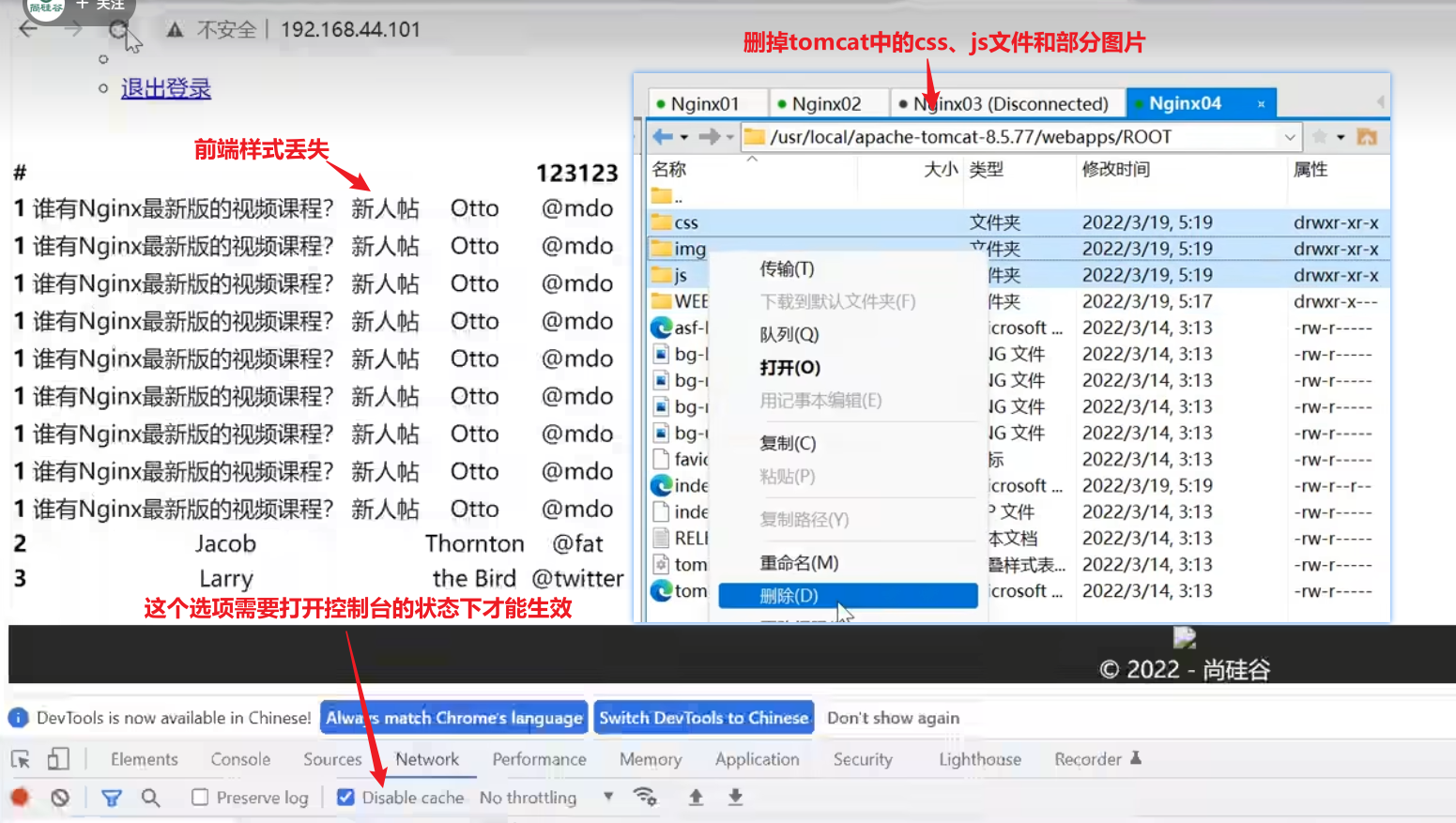

为了演示效果,上传完成后将104上的静态资源全部删掉

【删掉后的访问效果】

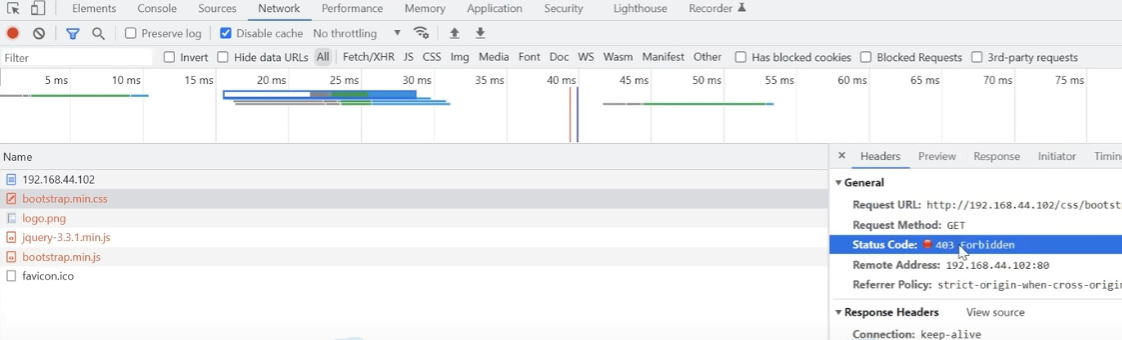

样式没了,下拉菜单也没了,部分图片也没了,注意此时nginx服务器上还没有对应的静态资源

在nginx代理服务器上虚拟几个目录,将静态资源上传到nginx服务器对应的目录下,

【使用proxy_pass,配置目录失效】

此时考虑的是静态资源放在nginx服务器的哪个地方,因为使用poxy_pass,此时直接使用html目录是无效的,所有访问html目录下的请求都会被代理到配置的tomcat服务器上,此时考虑如何对静态资源目录进行配置,此时需要配置多个location【后面详细讲location配置规则】,使得根据请求路径判断文件的地址

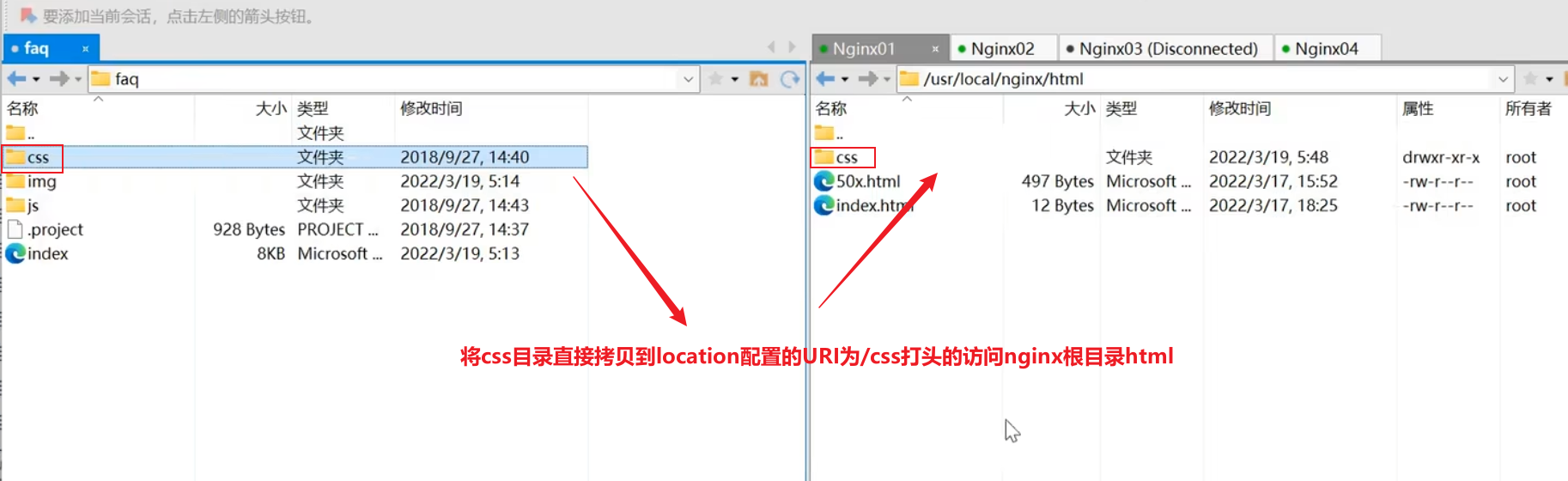

【location即静态资源目录配置】

配置location添加站点URI以/css打头的访问nginx服务器下的html目录

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;#因为proxy_pass已经指向tomcat服务器的ip和端口号,这个upstream实际已经不认识了,但是不会报错,显示也应该只显示tomcat服务器内容upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.103:80 weight=2 backup;server 192.168.44.104:80 weight=1;}server {listen 80;server_name localhost;location / {#proxy_pass指向tomcat服务器的ip和端口proxy_pass http://192.168.44.104:8080;}#uri打头为/css的请求会走nginx在该站点下的对应的根目录去寻找资源location /css {root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}【将css文件拷贝到根目录下】

注意配置的uri打头为css,此时也只上传了css文件,并没有上传另外两个img和js文件到该目录下

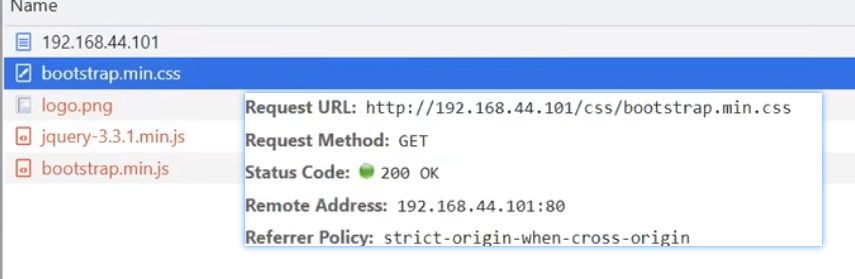

测试效果

此时样式已经有了,注意此时样式相关的文件在nginx服务器的根目录html下的css目录下,tomcat中的该文件已经删除

【对应css文件的请求路径】

uri打头带

/css

完整配置

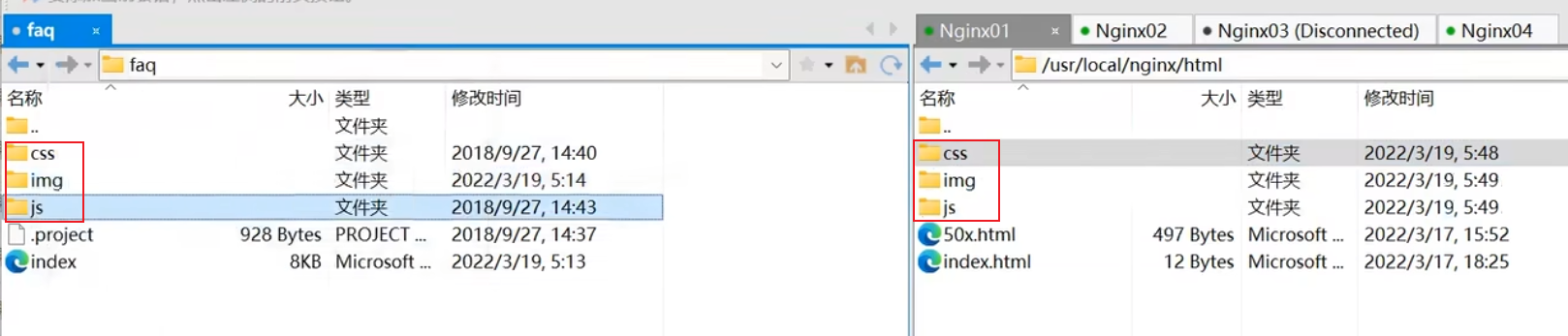

将静态资源目录都配置到nginx的html目录下,即将html目录配置为'/css','/js','/img'作为uri打头情况下的请求的资源根目录

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;#因为proxy_pass已经指向tomcat服务器的ip和端口号,这个upstream实际已经不认识了,但是不会报错,显示也应该只显示tomcat服务器内容upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.103:80 weight=2 backup;server 192.168.44.104:80 weight=1;}server {listen 80;server_name localhost;#默认规则,匹配所有以'/'打头的请求URI,优先级比较低,测试过程能够看到凡是有/的子路径,就会去匹配请求的子路径/css,符合优先精确匹配的原则location / {#proxy_pass指向tomcat服务器的ip和端口proxy_pass http://192.168.44.104:8080;}#uri打头为/css的请求会走nginx在该站点下的对应的根目录html去寻找资源location /css {root html;index index.html index.htm;}#uri打头为/js的请求会走nginx在该站点下的对应的根目录html去寻找资源location /js {root html;index index.html index.htm;}#uri打头为/img的请求会走nginx在该站点下的对应的根目录html去寻找资源location /img {root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}【静态资源文件上传】

不同字符打头的uri请求路径都要单独配置location,但是都可以配置成同一个根目录

最终测试效果

正则配置

写正则表达式可以将上述三个匹配路径合并成一个正则表达式,只需要多写一个location

配置详情

【nginx.conf】

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;#因为proxy_pass已经指向tomcat服务器的ip和端口号,这个upstream实际已经不认识了,但是不会报错,显示也应该只显示tomcat服务器内容upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.103:80 weight=2 backup;server 192.168.44.104:80 weight=1;}server {listen 80;server_name localhost;#默认规则,匹配所有以'/'打头的请求URI,优先级比较低,测试过程能够看到凡是有/的子路径,就会去匹配请求的子路径/css,符合优先精确匹配的原则location / {#proxy_pass指向tomcat服务器的ip和端口proxy_pass http://192.168.44.104:8080;}# ~* 表示要开始写正则表达式了,区分大小写的正则 ~ 开头,不区分大小写的正则 ~* 开头,(css|js|css)表示\后匹配括号中内容, | 表示或,location ~*/(css|js|css) {root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}测试效果

开启Disable cache的情况下反复刷新,让请求不要走缓存

动静分离存在的问题

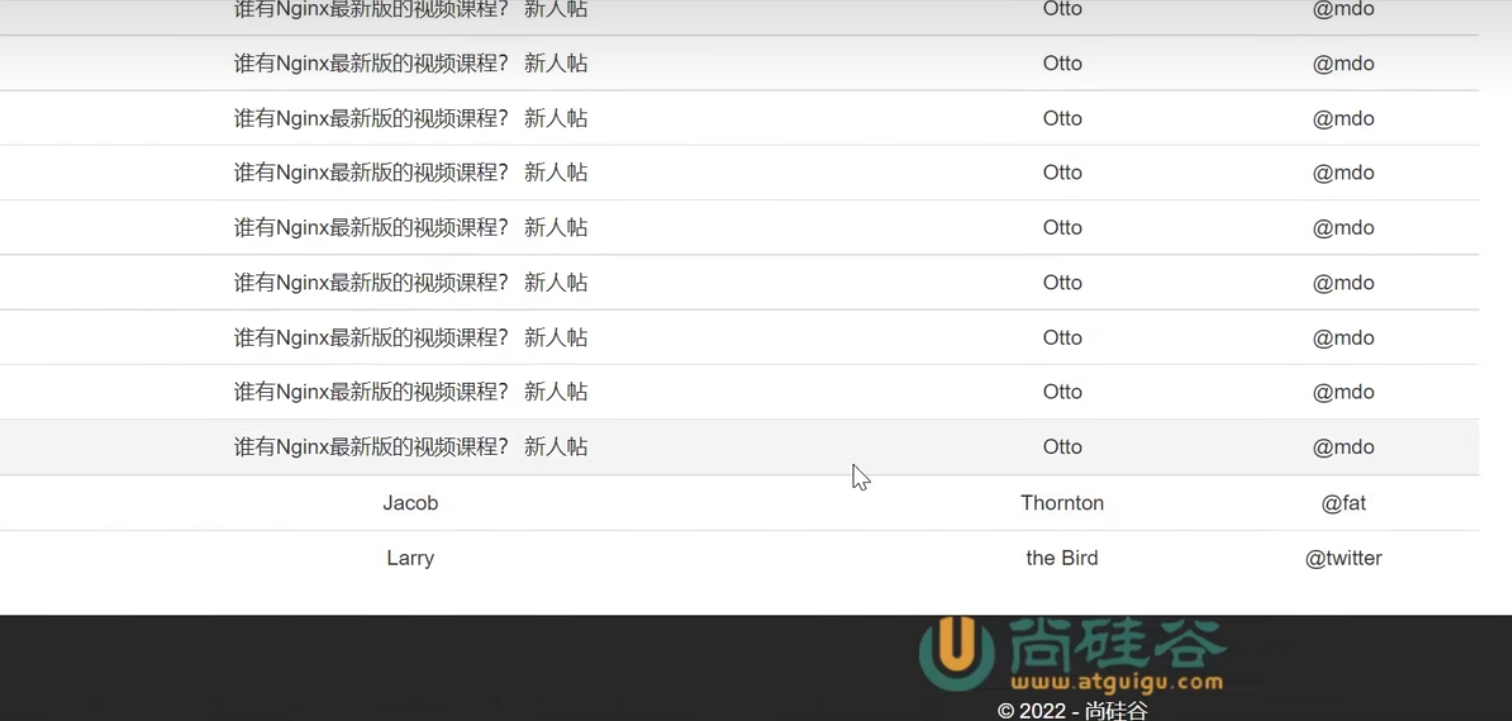

注意使用nginx管理静态css、js文件和图片,此时再直接访问tomcat服务器,tomcat中没有对应的静态资源,页面的样式、js函数和照片都无法加载

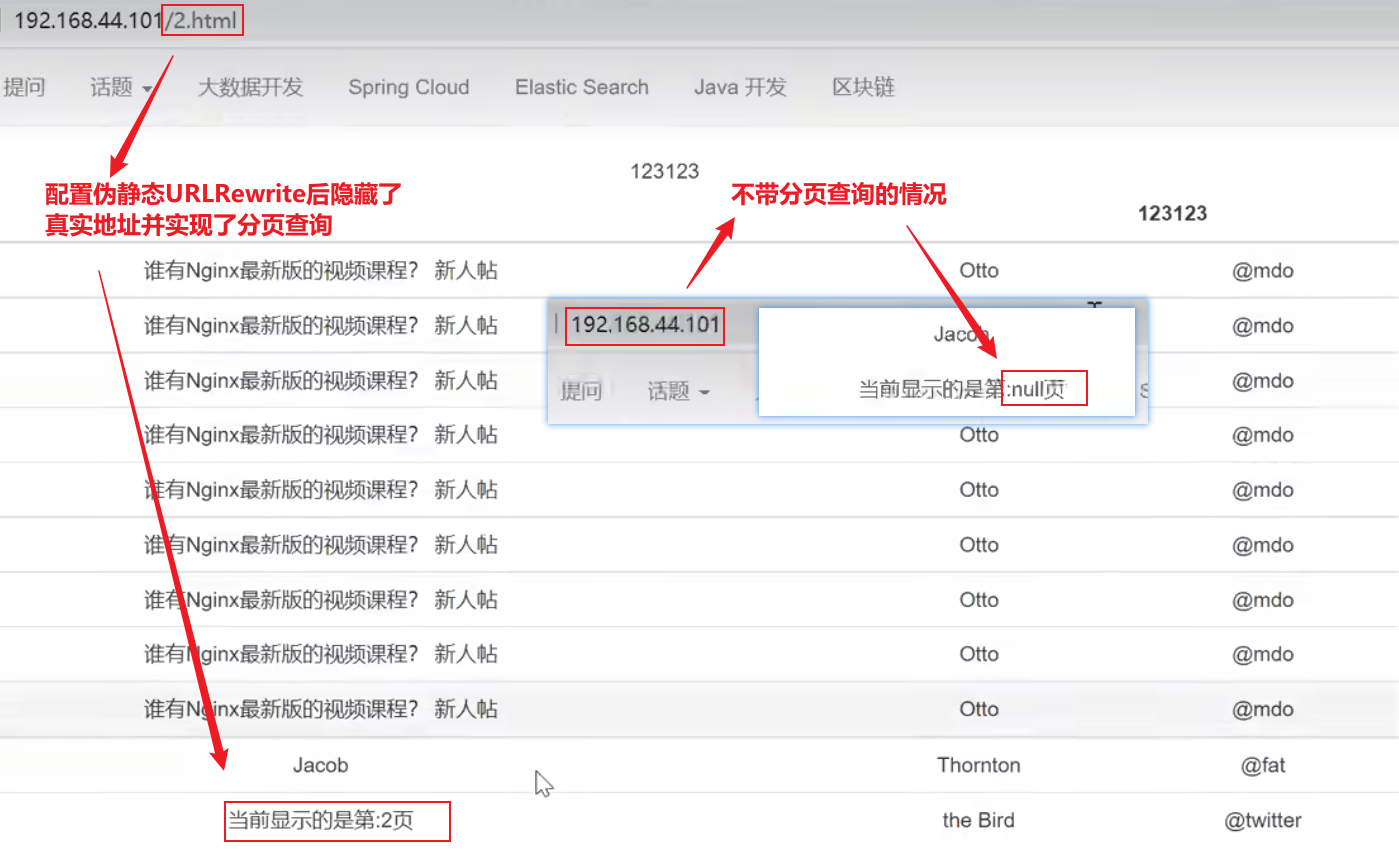

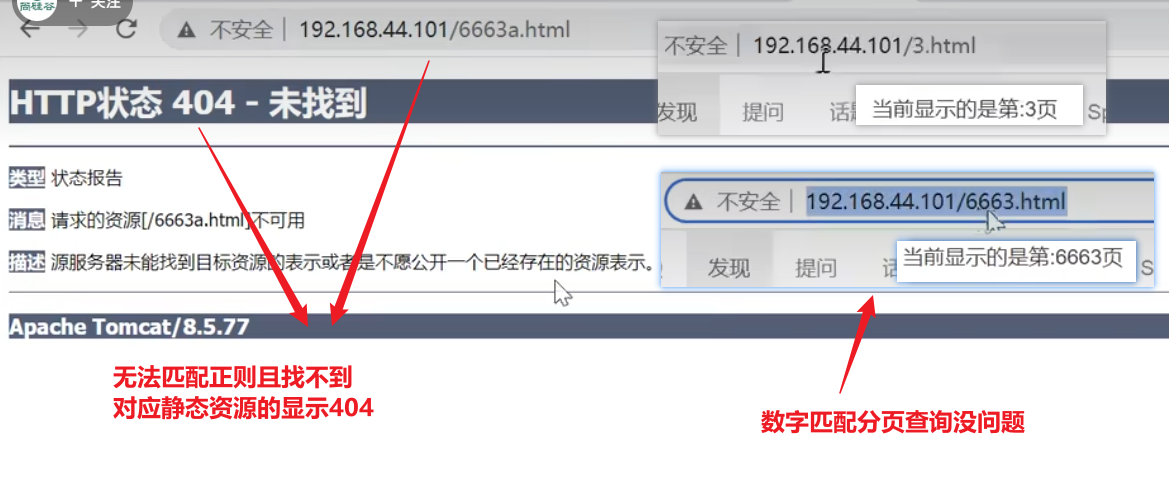

URLRewrite

能够隐藏真实的后端地址

http://192.168.44.101/index.jsp?pageNum=2这是查询分页评论的链接,连接长且暴露入参,可以将该连接隐藏起来,让请求连接伪静态变成http://192.168.44.101/2.html

配置URLRewrite伪静态

通过proxy_pass同一个站点的rewrite关键字指定,属性值使用正则表达式

nginx.conf

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;#因为proxy_pass已经指向tomcat服务器的ip和端口号,这个upstream实际已经不认识了,但是不会报错,显示也应该只显示tomcat服务器内容upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.103:80 weight=2 backup;server 192.168.44.104:80 weight=1;}server {listen 80;server_name localhost;#默认规则,匹配所有以'/'打头的请求URI,优先级比较低,测试过程能够看到凡是有/的子路径,就会去匹配请求的子路径/css,符合优先精确匹配的原则location / {#正则表达式以^开头,以$结尾,正则表达式匹配访问nginx服务器的该站点下的URI部分;演示用的是静态的形式,即定死2.html,入参也定死了2#/index.jsp?pageNum=2是真实的访问地址;#最后的break是请求转发的形式,转发形式FLAG 有 4 种:break、last、redirect、permanent;break 表示本条规则匹配完成即终止, 不再匹配后面的任何规则。rewrite ^/2.html$ /index.jsp?pageNum=2 break;#proxy_pass指向tomcat服务器的ip和端口proxy_pass http://192.168.44.104:8080;}# ~* 表示要开始写正则表达式了,区分大小写的正则 ~ 开头,不区分大小写的正则 ~* 开头,(css|js|css)表示\后匹配括号中内容, | 表示或,location ~*/(css|js|css) {root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}伪静态页面配置效果

显示的是访问静态资源2.html,但是本机实际没有2.html这个资源

不足:没有介绍怎么实现动态的将客户端的参数传递给实际的请求地址,仅仅只是配置了一个静态页面

配置动态参数的伪静态URLRewrite

nginx.conf

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;#因为proxy_pass已经指向tomcat服务器的ip和端口号,这个upstream实际已经不认识了,但是不会报错,显示也应该只显示tomcat服务器内容upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.103:80 weight=2 backup;server 192.168.44.104:80 weight=1;}server {listen 80;server_name localhost;#默认规则,匹配所有以'/'打头的请求URI,优先级比较低,测试过程能够看到凡是有/的子路径,就会去匹配请求的子路径/css,符合优先精确匹配的原则location / {#[0-9]+表示匹配任意位数字,正则表达式中使用小括号括起来的部分表示URLRewrite时用来入参的参数,实际地址中的$1表示入参选择正则表达式中第一个括号括起来的内容,如果有第二个入参可以用$2表示使用第二个括号括起来的参数,可以使用多个参数rewrite ^/([0-9]+)$ /index.jsp?pageNum=$1 break;#proxy_pass指向tomcat服务器的ip和端口proxy_pass http://192.168.44.104:8080;}# ~* 表示要开始写正则表达式了,区分大小写的正则 ~ 开头,不区分大小写的正则 ~* 开头,(css|js|css)表示\后匹配括号中内容, | 表示或,location ~*/(css|js|css) {root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}配置效果

根据客户端地址的参数将入参参数动态的传递给真实请求地址

参数说明

rewrite是实现URL重写的关键指令,根据regex (正则表达式)部分内容,重定向到replacement,结尾是flag标记。

rewrite/*关键字*/ <regex>/*正则*/ <replacement>/*替代内容*/ [flag]/*flag标记*/参数要领

关键字:关键字中的error_log不能改变,rewrite关键字可以使用的标签段位置:server、location、if;

正则:perl兼容正则表达式语句进行规则匹配

替代内容:将正则匹配的内容替换成replacement

flag标记:rewrite支持的flag标记,有四种

rewrite关键字有优先级区分,break的优先级最高,

flag标记类型 标记含义 last 本条规则匹配完成后,继续向下匹配新的location URI规则,一直匹配到配置文件最下面的URI规则 break 本条规则匹配完成即终止,不再匹配后面的任何location URI规则,继续执行后续的proxy_pass redirect 返回302临时重定向,响应页面后浏览器地址会显示配置文件中当前页面真实的URL地址 permanent 返回301永久重定向,浏览器地址栏会显示跳转后的URL地址 【flag标记为redirect的显示效果】

相当于nginx发起302请求,让客户端自己重定向到真实地址

临时重定向和永久重定向对用户来说没有区别,是给网络爬虫看的,比如百度来爬取网页,临时重定向以后还可以爬取,永久重定向永远记录重定向地址,这里讲的不清楚,无伤大雅,有机会了解网络爬虫再结合学习

注意:重定向ip地址还是nginx的地址192.168.44.101,不是tomcat104的地址

网关服务器

同时带有代理服务器、负载均衡和URLRewrite功能的服务器就能被称为网关服务器,网关配置可以直接用cloud的gateway的filter的RewritePath去写,可以不用nginx配置

目前nginx已经用上了反向代理、负载均衡、动静分离和URLRewrite的功能了

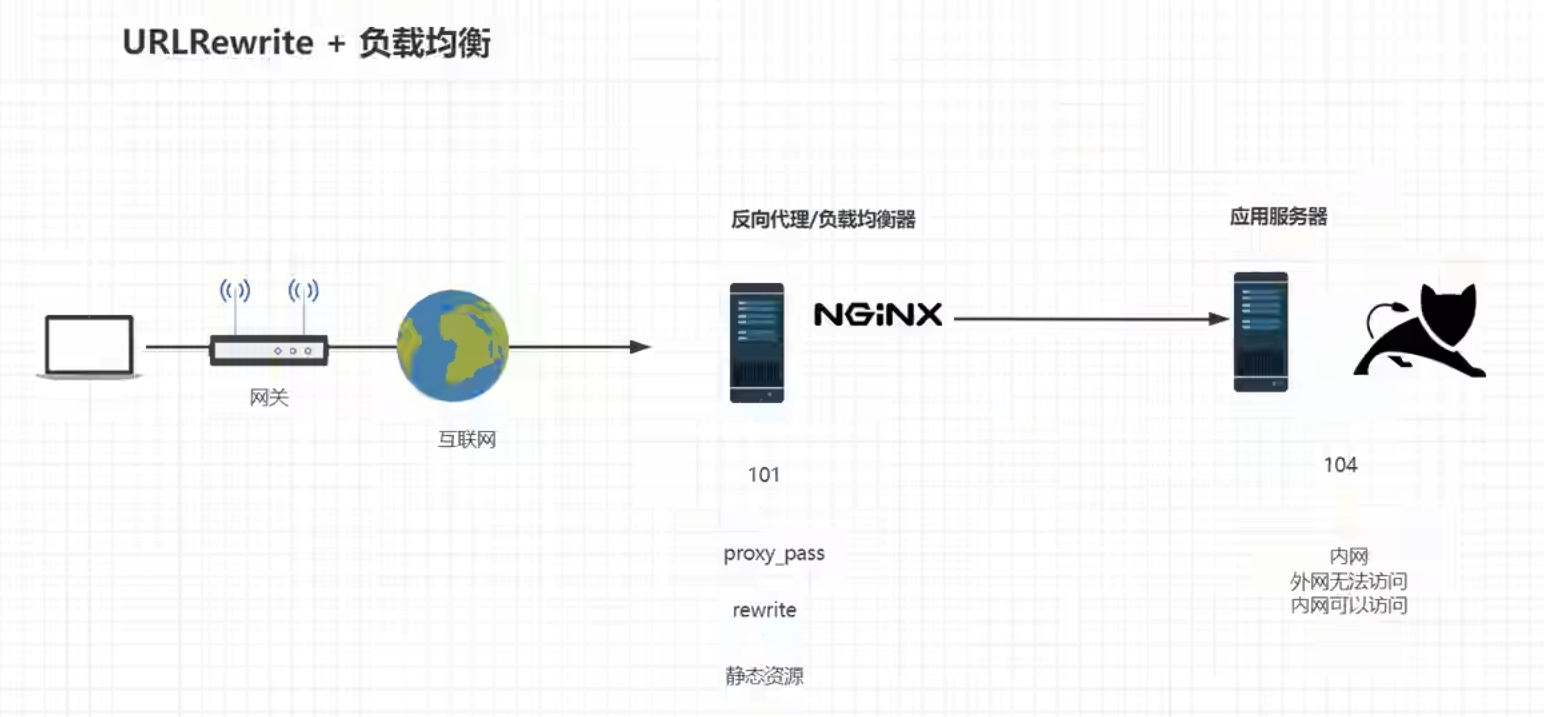

当前系统架构

nginx在此处担任起了反向代理,动静分离和URL重写的作用,此时直接访问tomcat会导致一些资源无法访问,需要设置tomcat只能从内网访问,不能从外网访问;

设置防火墙关闭tomcat外网访问

直接开启防火墙不设置端口通讯会切断一切外网tcp端口的连接,但是注意这种情况下xshell还是能连接的,此时打开tomcat所在的8080端口,但是又不希望外网访问到,只希望nginx能访问到

使用命令

firewall-cmd --permanent --add-rich-rule="rule family="ipv4" source address="192.168.44.101" port protocol="tcp" port="8080" accept"添加nginx反向代理服务器的ip地址192.168.44.101为可信任的ip地址,并对该地址在104机器上开启tcp协议上的8080端口通讯此时104机器上的tomcat只能被反向代理服务器101访问,外网已经访问不了该tomcat了,实现了不介入互联网,通过nginx反向代理服务器将一切资源转交给外网,如果nginx挂掉了,在这种配置的前提下这台tomcat服务器就彻底访问不到了

此时nginx就相当于tomcat服务的大门,大门一旦关闭了tomcat服务器的任何服务都访问不了了,此时nginx换个更专业的名字就是网关服务器,之前叫代理服务器、负载均衡器都很片面,无法包含他的一切功能【反向代理服务器、负载均衡器、URLRewrite、】

整合nginx的反向代理、负载均衡、URLRewrite完整功能

proxy_pass使用upstream时ip和端口号都写在upstream中,rewrite还是写在proxy_pass的上面,只是匹配uri

nginx.conf

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;#因为proxy_pass已经指向tomcat服务器的ip和端口号,这个upstream实际已经不认识了,但是不会报错,显示也应该只显示tomcat服务器内容upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.104:8080 weight=1 backup;}server {listen 80;server_name localhost;location / {rewrite ^/([0-9]+)$ /index.jsp?pageNum=$1 break;proxy_pass http://proxyServers;}location ~*/(css|js|css) {root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}访问效果

102服务down了,此时只会显示备用的tomcat服务器

防盗链

防盗链指存在服务器上的资源只能由我们自己的服务器进行访问,其他引用的服务器无法访问,

盗链

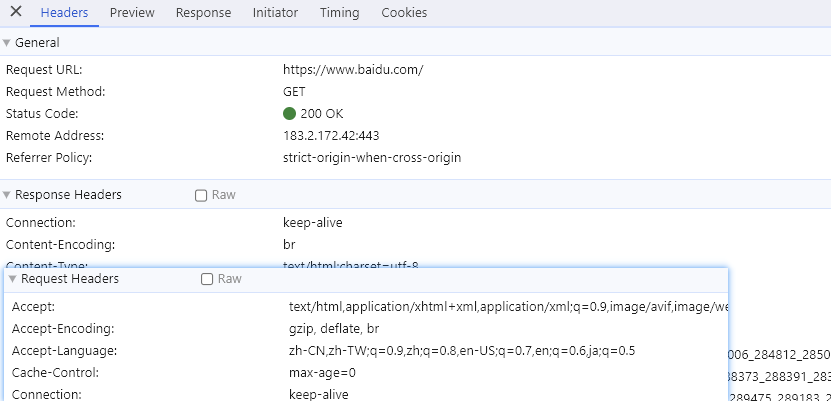

当用户访问某个主页,主页响应以后会二次甚至多次去请求当前站点主页中用到的引用资源【css、js文件和图片资源】,二次请求的时候会在请求的时候在请求头中添加referer参数,参数值就是首次请求的请求地址的URL,这是http协议规定的,由浏览器遵守的规定,只会出现在二次请求中,首次请求的请求头中是没有的,表示本次请求是从第一次请求的响应页面过来的;

此时可以根据请求头中是否含有referer属性来判断该请求的来源是一次请求响应结果进行的二次请求,还是某个用户单独进行的请求【用户无法操纵请求头中的referer的属性值,因为网络数据想要安全,涉及到的HTTP协议内容都必须由浏览器本身来进行填充?但是我试过向请求头中添加token】

如果别的站点对相同资源进行了引用,二次请求时可以根据请求头中的referer属性判断对资源的请求是否是自己的站点,因为referer属性是浏览器进行填充的,合法的浏览器是无法进行篡改的,如果不是自己的站点就可以判断是非法请求【说明有其他的网站引用了自己不想让别人引用的资源,允许别人引用就不需要对防盗链进行配置】;

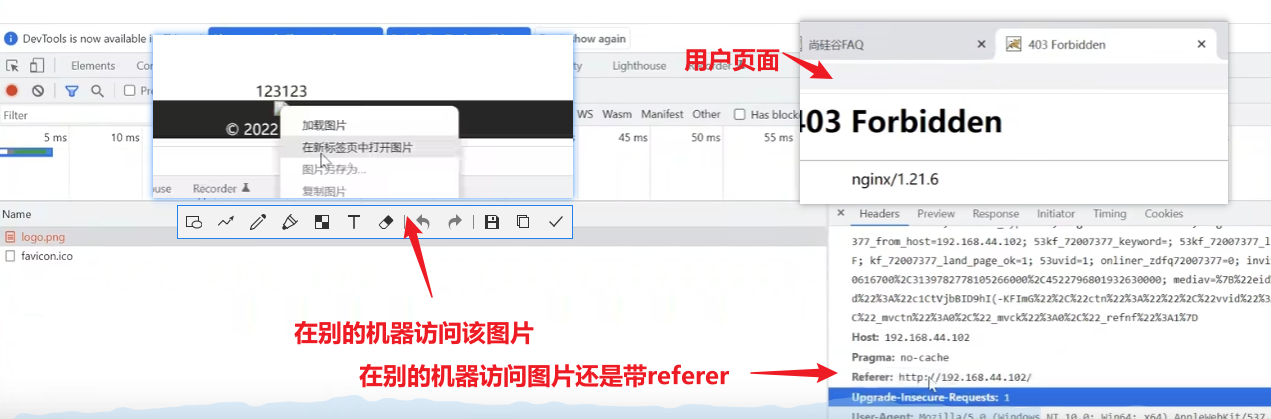

一般来说,网站上的资源希望别的站点使用,增加曝光量,不是所有的资源都需要防盗链;一般防盗链的使用场景如公众号上的图在自己的网站上引用就会提示不能在外地引用该图片资源【也是不缺流量或者资源的size很大,或者资源很稀缺,只希望用户只能在该站点才能看到该资源才会这样设置】

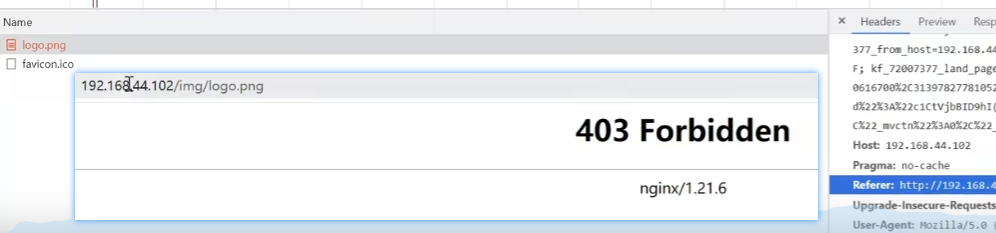

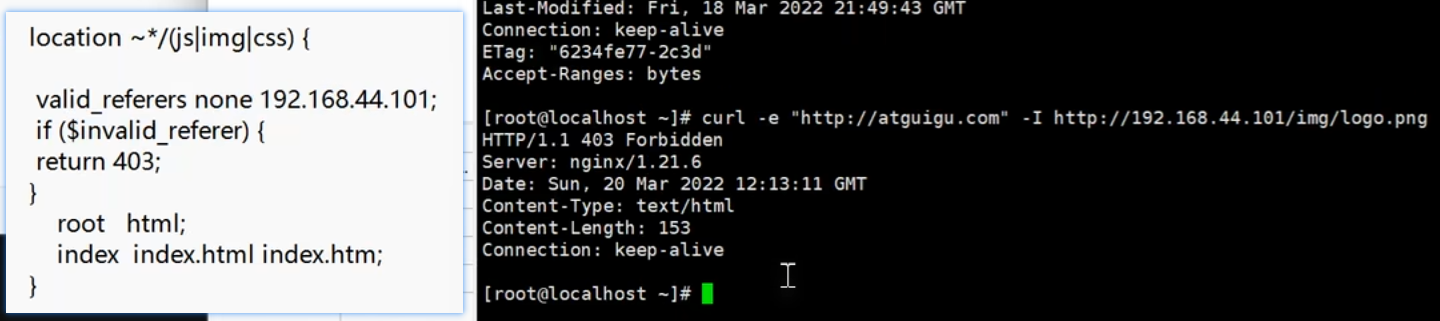

防盗链配置

新建一个站点102,配置站点102的proxy_pass为101,此时访问102会直接跳到101,

此时我们想实现被别的站点代理的二次请求的css、js和图片文件不能被访问的配置方法

更改101的配置文件nginx.conf【此时101是静态资源存放的服务器】

需要把对资源的限本站点访问的设置配置到资源站点即location下,不能配置在service下

本例中不希望css、js文件和图片不能被访问,需要配置在

location ~*/(css|js|css)站点下xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;#因为proxy_pass已经指向tomcat服务器的ip和端口号,这个upstream实际已经不认识了,但是不会报错,显示也应该只显示tomcat服务器内容upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.104:8080 weight=1 backup;}server {listen 80;server_name localhost;location / {rewrite ^/([0-9]+)$ /index.jsp?pageNum=$1 break;proxy_pass http://proxyServers;}location ~*/(css|js|css) {#检测二次请求的主机ip是否符合配置项,设置有效的referer的ip为101,如果访问的referer不是有效的referer,就返回错误码403,该站点下的下述配置指定站点目录的配置就不走了,就达到了访问该站点下限制访问的静态资源的站点目录找不到了#有效的ip可以设置多个,referer为这些ip的时候可以不限制访问valid_referers 192.168.44.101;#注意此处if和()之间必须有空格if ($invalid_referer) {return 403;}root html;index index.html index.htm;}#出错跳转nginx目录下的错误页error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}配置效果

【请求状态】

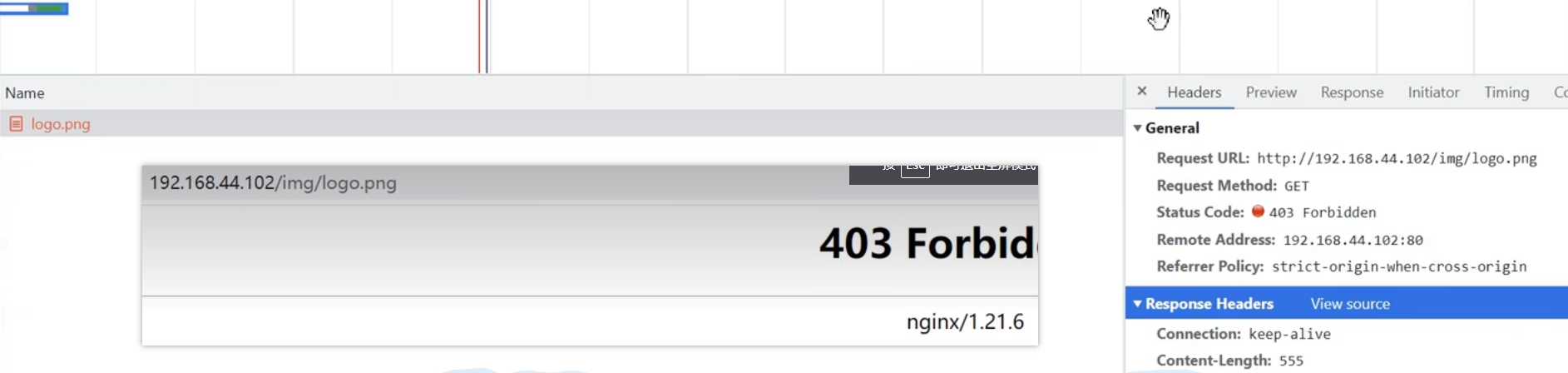

二次请求的response中没有数据,头信息中的状态码为403

【其他服务器单独访问图片效果】

仍然无法访问,还是报错403

【地址栏输入地址访问效果】

不仅是引用访问非法,直接地址栏访问也是不行的,直接在地址栏输入其他服务器ip加资源路径也是不行的,只要访问了非本机服务器,而是中途被代理的服务器,就无法访问被限制访问的资源,只能访问对应的站点才能访问相应的资源

也可以使用none关键字配置非应用但是地址栏访问允许的设置,即检测到请求中不带referer就允许访问

配置非引用状态下的资源允许访问

从被引用界面点击新标签打开图片,这种情况下带referer,这种情况下是无法访问的,虽然地址栏的地址是一样的,只能通过在地址栏输入地址且请求头不带referer属性才能访问加了none关键字对应资源

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.104:8080 weight=1 backup;}server {listen 80;server_name localhost;location / {rewrite ^/([0-9]+)$ /index.jsp?pageNum=$1 break;proxy_pass http://proxyServers;}location ~*/(css|js|css) {#添加了none关键字,此时请求非引用即不带referer就可以从别的服务器访问对应的资源,但是引用不可以valid_referers none 192.168.44.101;if ($invalid_referer) {return 403;}root html;index index.html index.htm;}error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}}}【地址栏直接访问效果】

【通过引用在新标签打开图片的方式访问效果】

带referer不行

关键字意义

none, 检测 Referer 头域不存在的情况。即请求没有referer属性即是直接访问不是引用访问的情况

blocked,检测 Referer 头域的值被防火墙或者代理服务器删除或伪装的情况。这种情况该头域的值不以“http://” 或 “https://” 开头。

不常用,即请求的

referer不带http或者https的情况下资源可以访问,目前可以看到referer中是带http的

使用curl测试防盗链

curl工具,该工具是linux系统下的工具,默认不会安装,windows是自带的,curl在做测试方面更加纯粹,更加方便一些;浏览器为了给用户做访问加速会在多个地方做缓存,导致用户刷新时可能无法即时刷新最新的页面,可以使用curl测试配置是否生效更加方便准确

使用命令

yum install -y curl在linux上安装curl使用命令

curl -I http://192.168.44.101/img/logo.png对目标地址发起请求,返回响应的头报文信息,不带-I会完整的显示响应内容,包括响应体使用命令

curl -e "http://baidu.com" -I http://192.168.44.101/img/logo.png对目标地址发起带引用的访问请求,即在请求头信息中添加referer参数注意,带引用的引用值不匹配设置的引用值,即使是访问原服务器地址的资源请求也一样会返回设置的403错误码

防盗链友好提示配置

实际生产中防盗链拒绝访问不会直接返回错误码,会响应一个对应错误提示的图片或者错误的提示页面

防盗链生效返回错误提示页面

在101服务器的根目录html中创建对应的错误页面401.html

在nginx.conf中配置错误代码对应的站点资源

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.104:8080 weight=1 backup;}server {listen 80;server_name localhost;location / {rewrite ^/([0-9]+)$ /index.jsp?pageNum=$1 break;proxy_pass http://proxyServers;}location ~*/(css|js|css) {#添加了none关键字,此时请求非引用即不带referer就可以从别的服务器访问对应的资源,但是引用不可以valid_referers none 192.168.44.101;if ($invalid_referer) {return 401 ;}root html;index index.html index.htm;}error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}error_page 401 /401.html;location = /401.html {#在root目录即html目录下去找资源401.htmlroot html;}}}访问效果

在页面引用中还是和原来一样,原因是文档的编码方式和图片的编码方式不同,当单独在新地址栏带引用访问对应资源就会显示错误页信息

整合URLRewrite返回报错图片

当引用的图片发生拒绝访问的情况,如果是跳转一个报错页面,内嵌于引用网页的图片不能显示对应的报错页面,但是这种方式本质上已经消耗了本地服务器的流量,请求经过处理也响应了内容,用URLRewrite的方式能返回一个友好提示的图片替代原来访问的图片

准备好对应的友好提示图片x.png【名字随意】,

nginx.conf

xxxxxxxxxxworker_processes 1;events {worker_connections 1024;}http {include mime.types;default_type application/octet-stream;sendfile on;keepalive_timeout 65;upstream proxyServers{server 192.168.44.102:80 weight=8 down;server 192.168.44.104:8080 weight=1 backup;}server {listen 80;server_name localhost;location / {rewrite ^/([0-9]+)$ /index.jsp?pageNum=$1 break;proxy_pass http://proxyServers;}location ~*/(css|js|css) {#添加了none关键字,此时请求非引用即不带referer就可以从别的服务器访问对应的资源,但是引用不可以valid_referers none 192.168.44.101;if ($invalid_referer) {rewrite ^/ /img/x.png break;#需要用图片提示友好信息,要注释掉返回的错误码,使用rewrite来指定满足条件后的真实访问地址#return 401 ;}root html;index index.html index.htm;}error_page 500 502 503 504 /50x.html;location = /50x.html {root html;}error_page 401 /401.html;location = /401.html {#在root目录即html目录下去找资源401.htmlroot html;}}}引用图片访问效果

nginx的高可用配置

高可用配置【Highly Available】,一台nginx做代理服务器、负载均衡器可能会发生单点故障导致后端服务完全不可用,此时要考虑配置多台nginx服务器来避免nginx不可用的情况,

此时会发生要实现nginx的切换或者nginx服务器的负载均衡需要再加一台代理服务器或者负载均衡器在nginx服务器集群之前,但是此时又会存在负责nginx服务器集群服务器切换和负载均衡问题的服务器需要设置集群,那么这样永远存在不停地在nginx服务器集群前加机器的问题,这样在nginx服务器集群前加机器控制nginx服务器的切换无法解决nginx服务器集群的控制切换问题

通过keepalived技术可以实现在不在nginx服务器集群前加机器的前提下实现nginx服务器的切换和控制,keepalive就是一个小小的软件,跑在nginx服务器集群的每个nginx服务器中,keepalived的作用是实现不同机器上的keepalived的通讯,检测集群中机器是否存在宕机,

nginx集群的运行

局域网内不同的nginx服务器的ip地址不能相同,用户请求主要用111的nginx服务器进行请求代理,如果nginx服务器111挂掉,keepalived会发现111机器挂掉,并将用户请求代理的地址改成112nginx服务器

但是如何判断一台机器是真的宕机了,还是假死状态【交换机过热、网络分区故障】,

网络分区故障:机房一个机柜中存在多台不同ip的主机,每个机柜对应有自己的小型交换机,如果交换机和交换机之间发生了通讯故障就发生了网络分区故障【即同一个机柜中不同ip的机器之间的通讯没问题,由于交换机之间的通讯故障,两个机柜之间的机器通讯断掉了,即网络分区故障】

当发生故障原nginx服务器假死,如果此时通过修改新nginx服务器的ip地址为原故障nginx服务器的ip【两台nginx服务器所处的机柜不同】,当原nginx服务器正常恢复以后,会发生ip冲突的情况;

多个nginx服务器是以主从的方式对外提供服务,并不会同时对外提供服务,从nginx服务器作为主服务器的备用,如果同时对外提供服务就变成了集群的形式,

如果采用主机宕机,将主机的ip直接切成备用机的ip,即修改备用机的ip为主机ip,此时在逻辑上确实能实现nginx服务器的切换,但是在使用场景中存在nginx服务器假死导致原nginx服务器重启发生两台nginx服务器ip地址冲突的情况

解决办法:

在局域网内虚拟出一个ip地址,术语叫做虚拟IP【VIP】,keepalived不去修改nginx服务器的真实ip地址,而是将虚拟IP来回漂移指向不同真实ip的nginx服务器,而用户直接访问入口的是虚拟IP【基于VRRP实现】,

一旦主机宕机,虚拟IP漂移到备用机上,如果此时主机恢复,此时涉及到主机的竞选机制,可以通过配置机器优先级【优先级越高,竞选称为主机的概率就越高】、keepalived只负责对虚拟IP进行漂移,不会修改真实的IP,不会导致出现较大的问题

注意,一台主机可以配置多个IP地址,不是一个机器只有一个ip地址,一个网卡【不是网关】上也可以配置多个地址,【一个机器可以有多个网卡,不同的网卡接入不同的网络,比如一个网卡接内网访问后端的应用服务器,另一个网卡接外网来接入电信、联通等主干网】,一个网卡上还可以配置好多个ip,只是最好不要配置太多

keepalived实现将用户的请求从主机迁移到备用机上,因为用户访问的ip一般不能主动更改【ip解析也不能老是更换,因为用户本机上的DNS缓存的域名解析还没来得及更新】,解决办法就是用户固定访问的ip地址在不同物理ip的机器上来回漂移

keepalived

keepalived是比较简单的软件,原理是检测keepalived的进程是否存在,不是依靠特别高明的机制,keepalived进程如果存活,就能相互之间发送数据包进行通信,如果无法通信了,就把虚拟IP按优先级漂移到可以通信的机器上

keepalived还可以通过编写脚本来控制keepalived监听的具体进程,当前keepalived只是监听自身的进程,并没有监听nginx的进程,如果nginx出问题但是keepalived没出问题,虚拟IP也是无法漂移的;脚本和keepalived也是分开的,和nginx也是分开的,脚本运行在目标机器上,三者唯一的联系就是运行在同一台机器上,脚本在设定时间间隔检测nginx当前是否报错,响应请求是否正常的200,如果连续监测到nginx的响应码不是200,就会将keepalived的进程kill掉,从而实现虚拟IP的漂移【此处不讲,可以自己研究一下】

keepalived的选举方式也很简单,就是根据配置文件优先级确定的,一旦新加入一台机器的keepalived的优先级更高,就自动将当前master改成BACKUP了,keepalived的应用不止nginx,是对主机和进程的检测,只是检测机器的keepalived是否或者,所以可以检测一切服务如多态mysql、redis、消息中间件、应用服务器等,都可以通过脚本检测进程运行状态,设定条件杀死keepalived进程实现虚拟IP的漂移

安装keepalived

编译安装

解压安装包,在当前目录下使用命令

./configure查看安装环境是否完整,如果有如下报错信息需要使用命令yum install openssl-devel安装openssl-devel的依赖xxxxxxxxxxconfigure: error:!!! OpenSSL is not properly installed on your system. !!!!!! Can not include OpenSSL headers files. !!!编译安装以前安装过,后面补充,包括上一条命令添加安装的位置

安装步骤

使用命令

yum install -y keepalived安装keepalived需要在线监测的所有机器都要安装keepalived

如果安装提示缺少

需要:libmysqlclient.so.18()(64bit),依次使用命令wget https://dev.mysql.com/get/Downloads/MySQL-5.7/mysql-community-libs-compat-5.7.25-1.el7.x86_64.rpm和rpm -ivh mysql-community-libs-compat-5.7.25-1.el7.x86_64.rpm安装对应的依赖【是否需要注意mysql的版本和本机匹配,我这里匹配了没有问题】,然后再次执行yum install -y keepalived安装keepalived即可keepalived的配置文件在目录

/etc/keepalived/keepalived.conf,使用命令vim /etc/keepalived/keepalived.conf修改keepalived的配置文件用来做nginx服务器在线监测的keepalived配置

【默认的keepalived配置文件】

xxxxxxxxxx! Configuration File for keepalivedglobal_defs {#这一段是机器宕机以后发送email通知,作用不大notification_email {acassen@firewall.locfailover@firewall.locsysadmin@firewall.loc}notification_email_from Alexandre.Cassen@firewall.locsmtp_server 192.168.200.1smtp_connect_timeout 30#global_defs中只有router_id有点用,其他的都可以删掉router_id LVS_DEVELvrrp_skip_check_adv_addrvrrp_strictvrrp_garp_interval 0vrrp_gna_interval 0}vrrp_instance VI_1 {state MASTERinterface eth0virtual_router_id 51priority 100advert_int 1authentication {auth_type PASSauth_pass 1111}virtual_ipaddress {192.168.200.16192.168.200.17192.168.200.18}}#仅仅用来检查nginx服务器的存活状态不用关心从这里往下的所有配置,即virtual_server都可以删掉virtual_server 192.168.200.100 443 {delay_loop 6lb_algo rrlb_kind NATpersistence_timeout 50protocol TCPreal_server 192.168.201.100 443 {weight 1SSL_GET {url {path /digest ff20ad2481f97b1754ef3e12ecd3a9cc}url {path /mrtg/digest 9b3a0c85a887a256d6939da88aabd8cd}connect_timeout 3nb_get_retry 3delay_before_retry 3}}}virtual_server 10.10.10.2 1358 {delay_loop 6lb_algo rrlb_kind NATpersistence_timeout 50protocol TCPsorry_server 192.168.200.200 1358real_server 192.168.200.2 1358 {weight 1HTTP_GET {url {path /testurl/test.jspdigest 640205b7b0fc66c1ea91c463fac6334d}url {path /testurl2/test.jspdigest 640205b7b0fc66c1ea91c463fac6334d}url {path /testurl3/test.jspdigest 640205b7b0fc66c1ea91c463fac6334d}connect_timeout 3nb_get_retry 3delay_before_retry 3}}real_server 192.168.200.3 1358 {weight 1HTTP_GET {url {path /testurl/test.jspdigest 640205b7b0fc66c1ea91c463fac6334c}url {path /testurl2/test.jspdigest 640205b7b0fc66c1ea91c463fac6334c}connect_timeout 3nb_get_retry 3delay_before_retry 3}}}virtual_server 10.10.10.3 1358 {delay_loop 3lb_algo rrlb_kind NATpersistence_timeout 50protocol TCPreal_server 192.168.200.4 1358 {weight 1HTTP_GET {url {path /testurl/test.jspdigest 640205b7b0fc66c1ea91c463fac6334d}url {path /testurl2/test.jspdigest 640205b7b0fc66c1ea91c463fac6334d}url {path /testurl3/test.jspdigest 640205b7b0fc66c1ea91c463fac6334d}connect_timeout 3nb_get_retry 3delay_before_retry 3}}real_server 192.168.200.5 1358 {weight 1HTTP_GET {url {path /testurl/test.jspdigest 640205b7b0fc66c1ea91c463fac6334d}url {path /testurl2/test.jspdigest 640205b7b0fc66c1ea91c463fac6334d}url {path /testurl3/test.jspdigest 640205b7b0fc66c1ea91c463fac6334d}connect_timeout 3nb_get_retry 3delay_before_retry 3}}}

【做nginx代理服务器的keepalived配置文件】

xxxxxxxxxx ! Configuration File for keepalived global_defs { #global_defs中只有router_id有点用,其他的都可以删掉,这个是当前机器的自定义名字,随便起名的,当前机器的ip是131 router_id nginx131 } #vrrp是keepalived在内网中通讯的协议【vrrp虚拟路由冗余协议】,atlisheng是实例名称,也是自定义的 vrrp_instance atlisheng { #state是当前机器的状态,当前机器是master state MASTER #interface需要和本机的网卡的名称对应上,这里修改ip地址为ens32,需要和interface对应 interface ens32 #这个不用管 virtual_router_id 51 #主备竞选的优先级,谁的优先级越高,谁就是master;Keepalived 就是使用抢占式机制进行选举,一旦有优先级高的加入,立即成为 Master priority 100 #检测间隔时间 advert_int 1 #内网中一组keepalive的凭证,因为内网中可能不止一组设备跑着keepalived,需要认证信息证明多个keepalived属于一组,同一组的authentication要保持一致,这样能决定一组keepalived中的一台机器宕机,虚拟IP是否只在本组内进行漂移,而不会漂移到其他组上 authentication { auth_type PASS auth_pass 1111 } #虚拟IP,虚拟IP可以填写好几个,意义不大,一般虚拟一个IP即可,这里设置成192.168.200.200,用户访问的是虚拟的ip,不再是真实的ip地址 virtual_ipaddress { 192.168.200.200 #192.168.200.17 #192.168.200.18 } }【备用机的keepalived配置】

注意同一组的实例名、virtual_router_id、authentication得是一样的

注意备机的priority 要设置的比主机小,state需要改成BACKUP

且备用机使用命令

ip addr不会看到虚拟ip的信息

xxxxxxxxxx ! Configuration File for keepalived global_defs { router_id nginx132 } vrrp_instance atlisheng { state BACKUP interface ens32 virtual_router_id 51 priority 50 advert_int 1 authentication { auth_type PASS auth_pass 1111 } virtual_ipaddress { 192.168.200.200 } }使用命令

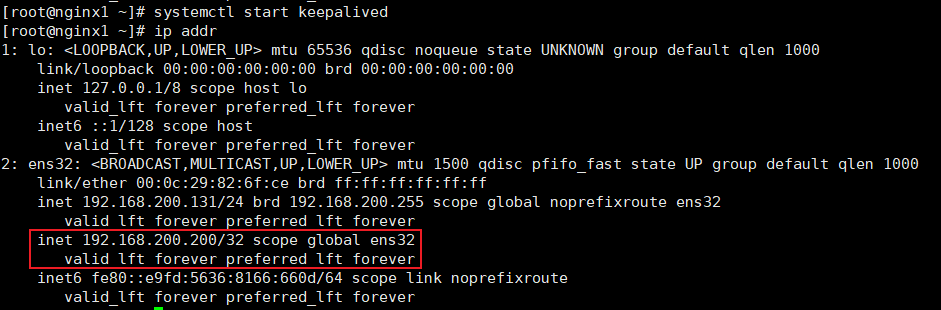

systemctl start keepalived运行keepalived

安装成功测试

启动keepalived后使用命令

ip addr查询ip信息在ens32下在原来真实的ip下会多出来一个inet虚拟ip:

192.168.200.200,master即主机上才有,备机上是没有的,即虚拟IP漂移到哪一台机器上才会出现这个虚拟IP

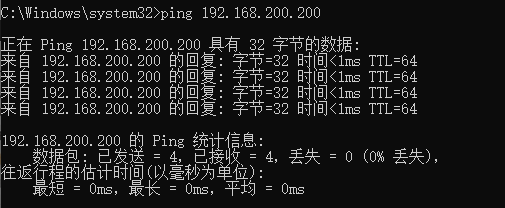

在windows命令窗口使用命令

ping 192.168.200.200 -t在windows系统ping一下这个虚拟IP,观察该ip是否能ping通没有-t只会ping4次,像下图这种情况

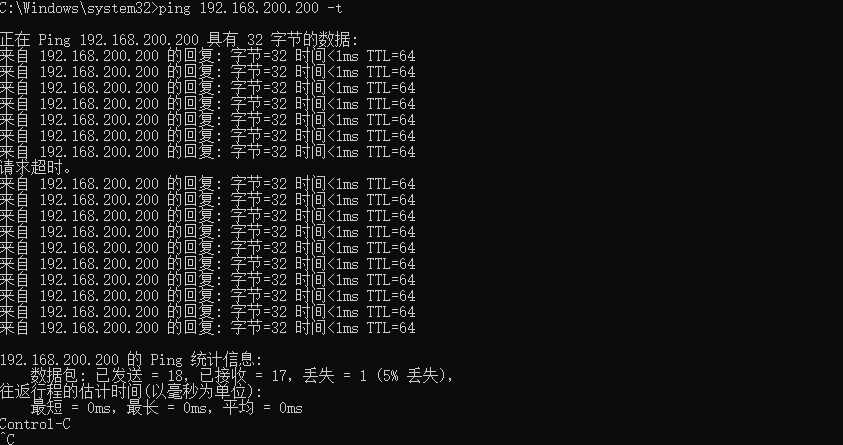

在linux系统下使用命令

init 0关掉master机器模拟nginx服务器宕机,在windows命令窗口观察网络通信情况windows通信切换时丢包一次,然后再次ping通,在备用机132上使用命令

ip addr能够观察到虚拟ip漂移到132机器上

网络协议

客户端与服务器网络通信是通过客户端最底层的socket,即基于网卡的特别基础的网络接口,有一门课叫socket编程,学习socket编程会涉及TCP的编程和UDB的编程,这两种网络协议就已经是较为上层的网络协议了,socket是比操作系统更底层的协议,和物理硬件完成交互,通过操作系统内核和网卡驱动去传输数据,TCP/IP协议是中间层的网络协议,用TCP/IP协议传输的网络数据,对方服务器时不知道数据包传输何时结束的,基本的TCP/IP协议只是用来传递数据的;通常在TCP协议上加一层形成应用层的高级协议,越高级的协议在使用的时候比较简单,但是底层比较复杂;HTTP请求头中包含请求参数,请求体中是真实想要传递的透明数据【比如图片】

HTTP的安全性缺陷

因为Http协议的底层协议没有一个是保证数据传输是安全不会被劫持的,

防火墙不能防止数据传输被劫持,防火墙只能防止本机的端口莫名其妙的向外传递数据,防一些病毒和未知的程序,服务器的防火墙一般只会开启固定的对外通信端口,还可以根据用户的行为设定一些限制访问规则,比如频繁访问等功能,但是没有针对数据网络传递过程中的数据安全性

家里的网络传递经过自家的网关会经过小区的网关,然后到接到会有一个网关,然后区里还有一个大的,市里还有一个大的路由网关,才会接入到主干网络,如果访问的服务器在美国,期间经过的网关路由可能会多达十几二三十个,每个节点都要将数据包传递到下一个节点,最终传递到服务器;在每个网关节点内都是可以看到传递的网络数据的,如果能猜出来传输数据是按照什么协议编码的可以直接按照协议去数据包解码,看到传递的明文内容,所以http协议在数据传输的过程中是不安全的,而且有很多的节点都能监听到【比如公共场合的WiFi不要去传递很私密的东西,可能数据包会被截取做处理】

网络数据传输加密的解决方案

最简单的加密算法是凯撒加密算法

凯撒加密算法就是将明文向后挪动一位【123明文变成231密文】

用户数据经过凯撒加密算法从明文变成密文经过网络传输到服务器,服务器通过凯撒加密算法将数据解密以后处理将响应数据加密成密文再传递给客户端

客户端和服务器采用同一种算法来对数据明文加密解密的过程称为对称加密,优点是简单,缺点是对称加密算法一定要内置在服务器端,如果一个项目是开源的,就能获取到加密算法列表,并在中间节点使用这些加密算法去破解这些密文;并且客户端也需要这些加密算法来对用户的数据来进行加密,

即对称加密算法的保密性无法保证,又因为服务器和客户端都要内置加密算法导致对称加密算法不够灵活

在对称加密的基础上

如果客户端在首次向服务端传递数据时传递一个加密密码,即服务器需要使用该密码作为加密协议的因子才能解开密文,关键是用户的密码如何安全传递给服务器不被中间节点拦截住

所以对称加密算法实际上是无法解决安全问题的,即便使用密码进行解密,但是密码的传递还是不安全的

HTTPS原理

非对称加密算法基本原理

服务器生成一个加密因子,该加密因子不在互联网上进行传播;非对称加密算法加密和解密是不同的算法,客户端存在一个公钥,服务器存在一个私钥,用户首次请求去服务器主机的443端口而非80端口获取公钥,通过公钥和加密算法在数据传输前对明文进行加密生成密文,服务器接收到密文后用私钥和解密算法解开密文得到明文;响应请求以后用私钥和加密算法对响应进行加密【公钥私钥都是加密算法的因子】,密文传递给客户端以后可以用公钥和算法进行解密【请求是公钥加密,私钥解密;响应是私钥加密,公钥解密】

只是以上两点还无法满足安全性,此外还有第三点特征,公钥加密,公钥无法解开密文【因为公钥还是会经过各个节点,存在窃取的风险】

对称加密算法要安全一定要保证私钥要安全,这套非对称加密算法就是https协议的底层算法

存在问题

响应内容也存在被解密的风险

除此以外,这种非对称加密算法也不是绝对安全的,有些节点会存在模拟服务器的行为,拦截用户的请求,替用户去请求目标服务器的443端口获取真实服务器想要颁发给用户的公钥,然后自己给用户颁发自己的公钥,此后拦截用户的请求解密用户密文篡改用户请求信息并替代用户用服务器颁发的公钥进行加密向真实服务器发起请求

进一步优化

这种模拟目标服务器拦截用户请求篡改用户请求信息代替用户请求的行为类似于将银行颁发的银行卡存在自己手上,而向用户颁发自己发行的银行卡

此时需要一个第三方,该第三方不在网络中进行信息传递,同时当目标服务器颁发凭证时知晓和确认凭证且在用户使用凭证时对凭证进行确认,这个机构就叫CA机构,对服务器下发的公钥进行认证,CA机构也是一套系统,提供认证服务

服务器下发公钥之前会向CA机构提交公钥,CA机构会对公钥的提交者的身份进行验证,验证方式一般是给提交公钥的服务器提供一个即时生成的随机验证码文件,要求服务器将该文件上传放在目标域名服务器的指定目录下,CA机构通过指定目录访问该验证文件从而判定是可信任受客户管理的服务器地址【正常情况下拦截者是无法向提交公钥的服务器上传文件的】

当CA机构对提交公钥的服务器验证后,CA机构会使用CA机构的私钥和加密算法对服务器提交的公钥再进行一次非对称加密并生成CA证书【浏览器的地址栏最前面的菜单中有链接是安全的,点开就能查到对应的安全证书,网站单位和颁发机构、时效等等】

再有用户请求443端口想要公钥直接下发CA证书,不再下发公钥了

操作系统中内置了CA机构的公钥,使用CA机构的公钥能解开CA机构私钥加密的CA证书,CA证书也只能通过操作系统内置的CA公钥去解密,中间节点能拦截到CA证书,也能通过CA机构的公钥解密证书,但是无法篡改并生成新的CA证书,因为CA机构的私钥不可能丢,只要不是用这个私钥加密的CA证书,使用CA机构公钥就无法解密,无法被正常解密的CA证书就不认可为可信任的CA证书【非私钥加密,即使是公钥加密公钥也无法解开】

这也是为什么要用正版操作系统,由其是证书方面,避免在系统上被恶意软件安装了root根证书,导致外来root根证书成了可信任的状态,一般杀毒软件也会防范这种根证书的植入,任何操作系统都有内置的CA公钥,包括移动端

同时还要使用正版的浏览器,一系列的认证流程都是浏览器完成的,如果浏览器有问题,即便证书再安全,安全性也无法保证

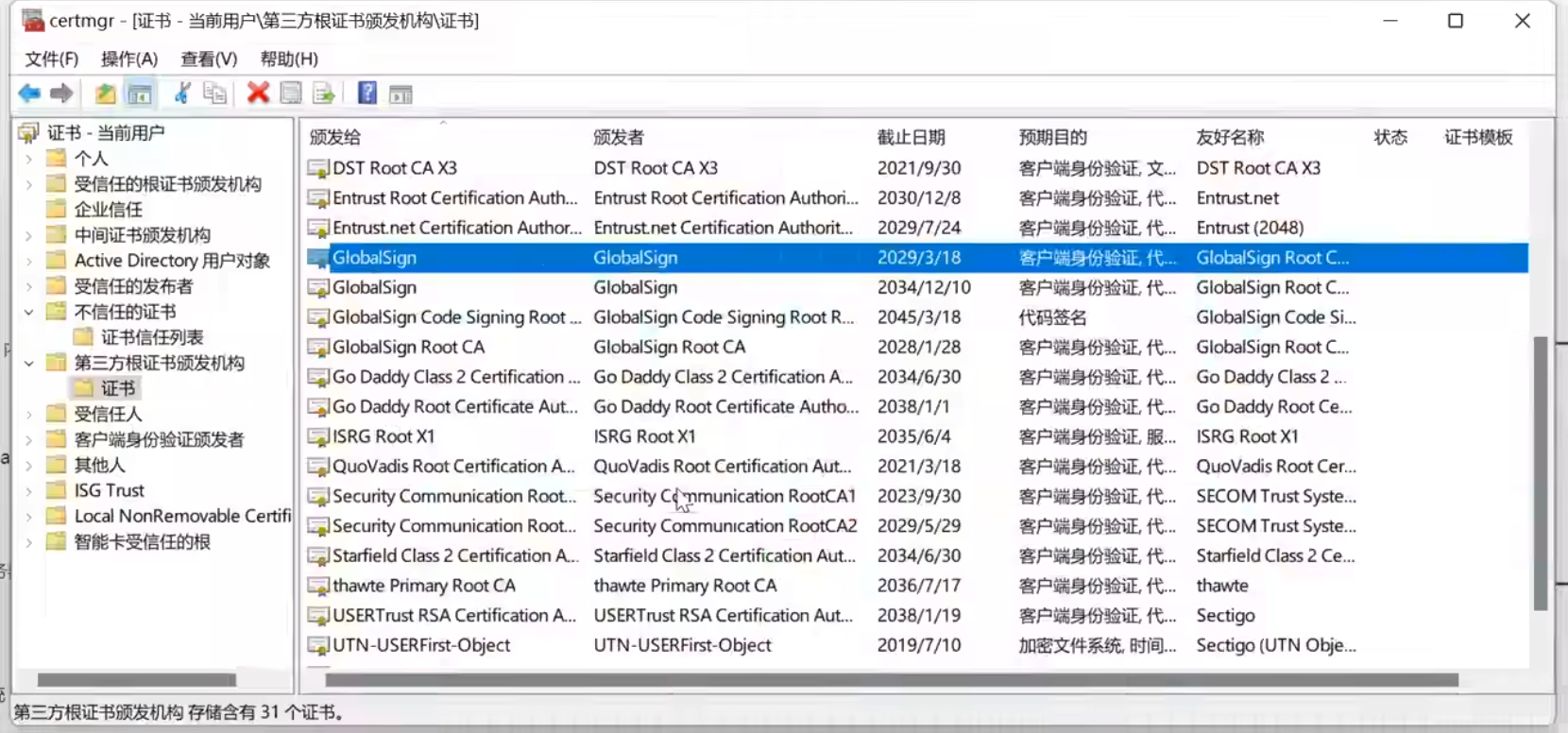

所有内嵌在操作系统的证书可以通过

win+r呼出的窗口输入certmgr.msc显示的界面进行查看,第三方根证书颁发机构都是非常知名的机构,这些证书就是CA机构的公钥

https被称为21世纪互联网最伟大的发明,在以前网络数据传输的安全性非常不可信任,数据非常容易被篡改,https发明以后数据安全性就好了很多,像银行这种对数据加密性要求很高的机构除了引入数据传输安全加密,还会引入其他的加密方案,包括加密键盘控件,避免输入账户密码的时候被恶意软件监听键盘输入;当然这种情况下还是可能被录屏导致不安全

证书自签名

证书自签名意思就是CA机构的角色是服务器自己扮演的,这种应用场景非常少,因为这种情况下,用户访问时浏览器不会有受信任证书的提示,浏览器也不会认为这是一个安全可靠的连接,因为CA机构不是系统内置的,而是用户自己签的CA证书,使用场景非常少,只有内网环境下才会用到自签名,CS的连接也可能用到自签名,但是用处也不大

自签名可以用OpenSSL实现

OpenSSL是一款非常出名的开源软件,相当于在开源界扛把子的地位,罗永浩在2015年左右拿出200w直接赞助给OpenSSL,对互联网安全贡献非常大,还赞助过OpenResty,OpenResty是提供给nginx做高并发的,OpenSSL是提供nginx上https的,OpenSSL基本上内嵌在操作系统上,没有可以使用yum源进行安装,基于命令行的工具,可以生成CA证书

XCA是基于OpenSSL的一款图形化工具,下载地址:https://www.hohnstaedt.de/xca/index.php/download

在线申请CA证书

中小企业可能会负责这件事,在线申请一个证书,绑定到一台服务器上,给服务器安装上nginx,对nginx进行配置,让nginx跑一些开源的程序

购买域名

域名的提供商非常多,最著名的就是万网,net.cn;注册域名到大的平台商,小商户可能带着域名跑路

注意顶级域名中含有中文的域名最好不要买,健壮性不行,稍微老一点的软件都不支持中文的编码,虽然目前流行的浏览器都支持中文

直接阿里云购买

购买主机

主机云服务器就是阿里云ECS,大陆的云服务器需要备案,香港和国外的云服务器不需要备案,CentOS7.4用的比较多,系统也比较靠谱

轻量级服务器有专门的产品界面,不在ESC中

使用xshell连接公网IP能连接上系统,需要输入设置的root账户和密码

在云服务器上安装nginx,该nginx版本除了基础的tengine和OpenResty,还集成了运行环境,包括PHP、数据库等等

使用命令

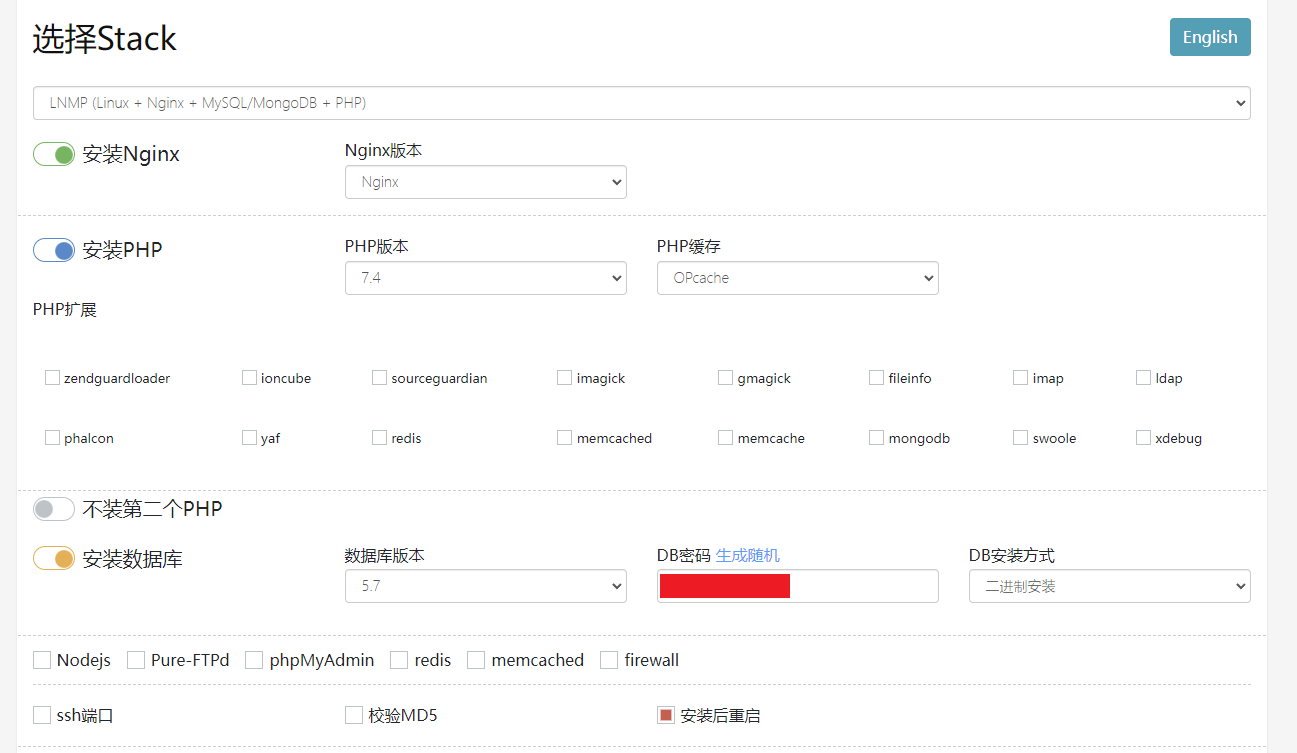

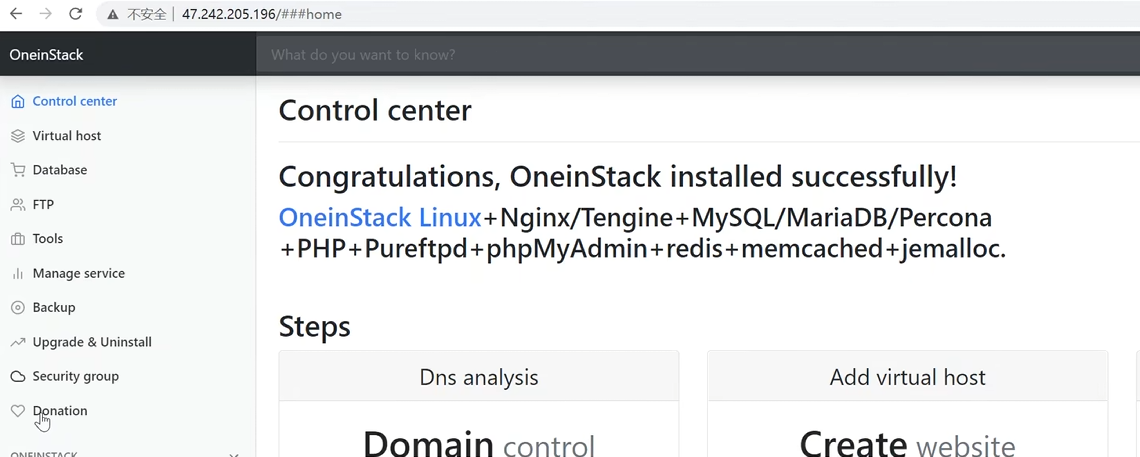

lnmp,l表示nginx、n表示nginx、m表示mysql、p表示php【安装php是为了演示bbs】oneinstack.com是一个集成环境,可以选择安装的产品并生成安装命令【云服务器安装nginx配置】

【生成的安装命令】

阿里云的云服务器默认是安装了wget的

我这儿安装好了没有位置提示,这里记老师的,nginx安装目录

/usr/local/nginx、数据库的安装目录/usr/local/mysql、数据库的data dir:/data/mysql、PHP的安装目录/usr/local/php、Opcache控制面板URL:http://172.18.45.195/ocp.php我这儿安装非常快,一分钟可能都没到,老师上课装了27分钟

wget -c http://mirrors.oneinstack.com/oneinstack-full.tar.gz && tar xzf oneinstack-full.tar.gz && ./oneinstack/install.sh --nginx_option 1 --php_option 9 --phpcache_option 1 --db_option 2 --dbinstallmethod 1 --dbrootpwd 个人数据库密码 --reboot配置云服务器的安全组【防火墙】

80、443、22端口,mysql数据库最好不要开放远程通讯端口,线上mysql管理最好安装一个PHPMyAdmin,redis开放6379端口一定要设置密码,很容易被黑

开放对应端口后浏览器访问对应公网ip,对应的大陆服务器没有备案会显示内容禁止访问,没有设置CA认证,地址前面也会提示不安全,使用oneinstack安装的nginx访问80端口会显示oneinstack的控制面板,控制面板中的Virtual host中的./vhost.sh是其提供的修改nginx.conf的脚本文件,oneinstack修改了nginx的配置,在最小配置的基础上还增加了其他配置,暂时先不管;此外还将欢迎页的根目录设置成了oneinstack的控制台,对应的root目录被改成了

/data/wwwroot/default,暂时还是用html,将server 80端口的服务的root改成html,其他的配置先不管,里面还配置了对php脚本的访问

【oneinstack修改的nginx配置文件】

这里和老师的情况不同,我这里默认的nginx配置被注释掉了,老师的是生效的,等服务器备案下来了再说

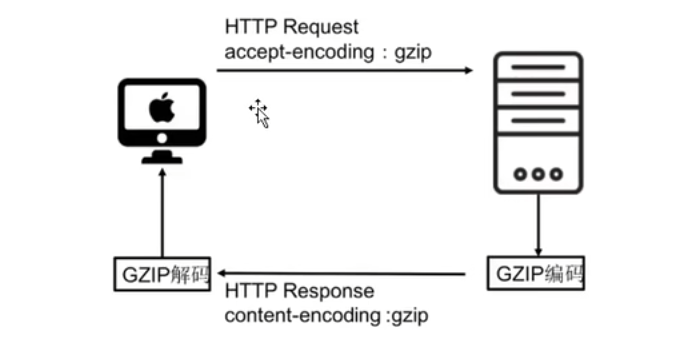

xxxxxxxxxxuser www www;worker_processes auto;error_log /data/wwwlogs/error_nginx.log crit;pid /var/run/nginx.pid;worker_rlimit_nofile 51200;events {use epoll;worker_connections 51200;multi_accept on;}http {include mime.types;default_type application/octet-stream;server_names_hash_bucket_size 128;client_header_buffer_size 32k;large_client_header_buffers 4 32k;client_max_body_size 1024m;client_body_buffer_size 10m;sendfile on;tcp_nopush on;keepalive_timeout 120;server_tokens off;tcp_nodelay on;fastcgi_connect_timeout 300;fastcgi_send_timeout 300;fastcgi_read_timeout 300;fastcgi_buffer_size 64k;fastcgi_buffers 4 64k;fastcgi_busy_buffers_size 128k;fastcgi_temp_file_write_size 128k;fastcgi_intercept_errors on;#Gzip Compressiongzip on;gzip_buffers 16 8k;gzip_comp_level 6;gzip_http_version 1.1;gzip_min_length 256;gzip_proxied any;gzip_vary on;gzip_typestext/xml application/xml application/atom+xml application/rss+xml application/xhtml+xml image/svg+xmltext/javascript application/javascript application/x-javascripttext/x-json application/json application/x-web-app-manifest+jsontext/css text/plain text/x-componentfont/opentype application/x-font-ttf application/vnd.ms-fontobjectimage/x-icon;gzip_disable "MSIE [1-6]\.(?!.*SV1)";##Brotli Compression#brotli on;#brotli_comp_level 6;#brotli_types text/plain text/css application/json application/x-javascript text/xml application/xml application/xml+rss text/javascript application/javascript image/svg+xml;##If you have a lot of static files to serve through Nginx then caching of the files' metadata (not the actual files' contents) can save some latency.#open_file_cache max=1000 inactive=20s;#open_file_cache_valid 30s;#open_file_cache_min_uses 2;#open_file_cache_errors on;log_format json escape=json '{"@timestamp":"$time_iso8601",''"server_addr":"$server_addr",''"remote_addr":"$remote_addr",''"scheme":"$scheme",''"request_method":"$request_method",''"request_uri": "$request_uri",''"request_length": "$request_length",''"uri": "$uri", ''"request_time":$request_time,''"body_bytes_sent":$body_bytes_sent,''"bytes_sent":$bytes_sent,''"status":"$status",''"upstream_time":"$upstream_response_time",''"upstream_host":"$upstream_addr",''"upstream_status":"$upstream_status",''"host":"$host",''"http_referer":"$http_referer",''"http_user_agent":"$http_user_agent"''}';######################## default ############################# server {# listen 80;# server_name _;# access_log /data/wwwlogs/access_nginx.log combined;# root html;# index index.html index.htm index.php;# #error_page 404 /404.html;# #error_page 502 /502.html;# location /nginx_status {# stub_status on;# access_log off;# allow 127.0.0.1;# deny all;# }# location ~ [^/]\.php(/|$) {# #fastcgi_pass remote_php_ip:9000;# fastcgi_pass unix:/dev/shm/php-cgi.sock;# fastcgi_index index.php;# include fastcgi.conf;# }# location ~ .*\.(gif|jpg|jpeg|png|bmp|swf|flv|mp4|ico)$ {# expires 30d;# access_log off;# }# location ~ .*\.(js|css)?$ {# expires 7d;# access_log off;# }# location ~ ^/(\.user.ini|\.ht|\.git|\.svn|\.project|LICENSE|README.md) {# deny all;# }# location /.well-known {# allow all;# }# }########################## vhost #############################include vhost/*.conf;}oneinstack默认将nginx配置成了服务,可以直接使用

systemctl的相关命令【服务器备案中,后面补效果】目前图用的课堂的

在线生成证书

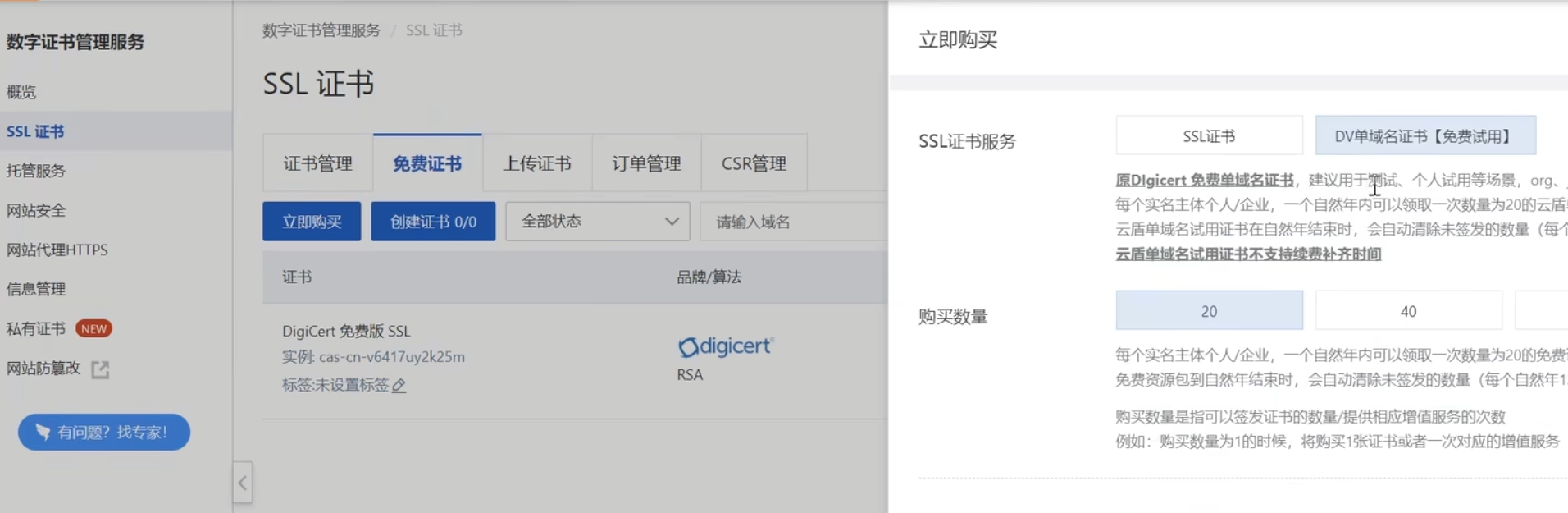

在云服务商搜索SSL证书【应用安全】

整DV单域名证书是免费的,但是限制主体域名【只能设置单个二级域名,一年可以设置20个】,类似通配符等自定义域名需要付费购买,还挺贵,一年几百上千,企业小或者单人没必要买付费的

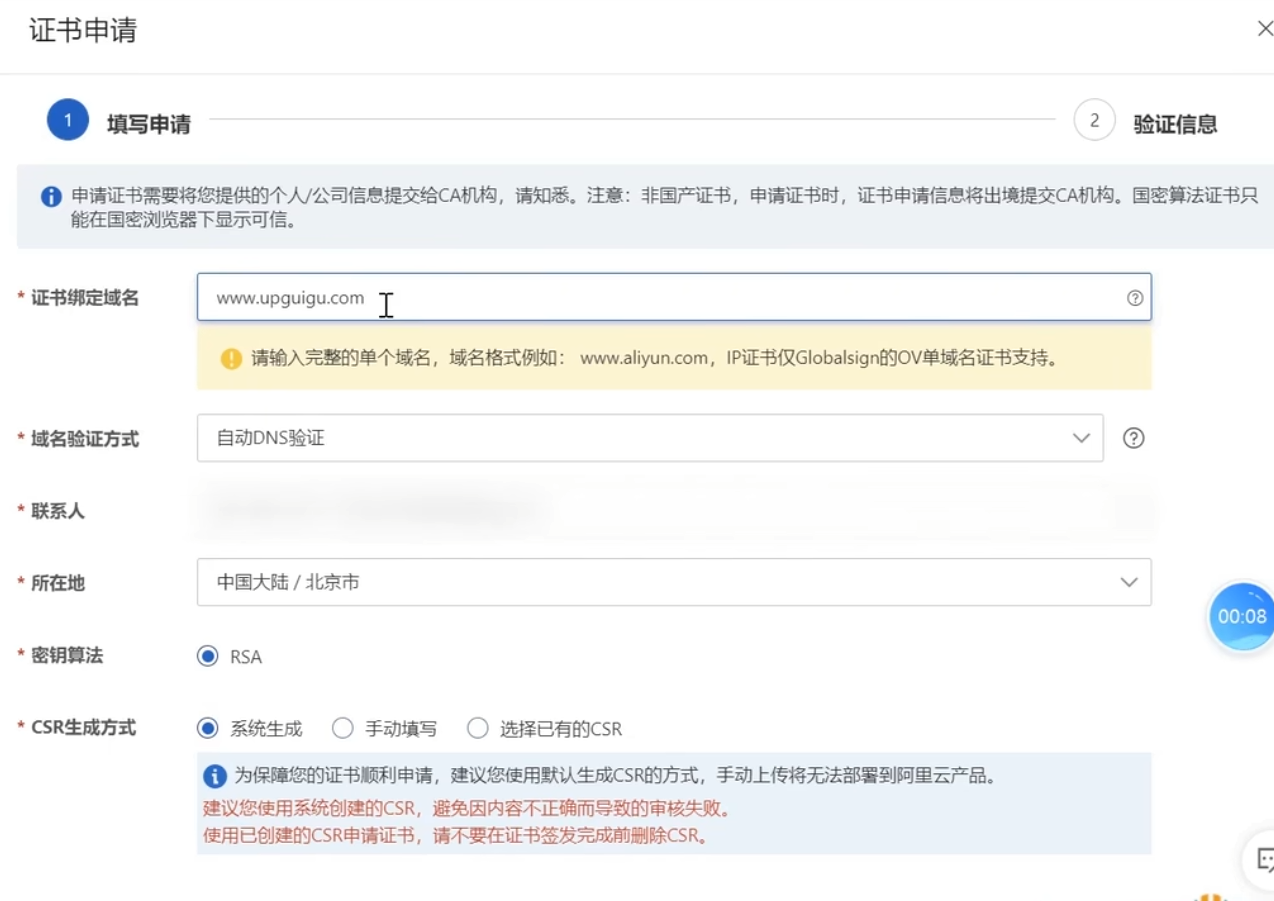

【申请填写信息】

域名验证方式选择自动DNS验证,后续验证的时候点击一下验证就会自动验证,如果是手动需要去配置指定的域名解析供认证机构去进行验证,一般只有域名和服务器在同一个平台才可以自动DNS验证,以文件的形式验证还需要点击上传文件

密钥算法RSA就是非对称的加密算法,CSR是证书文件【直接系统生成即可】

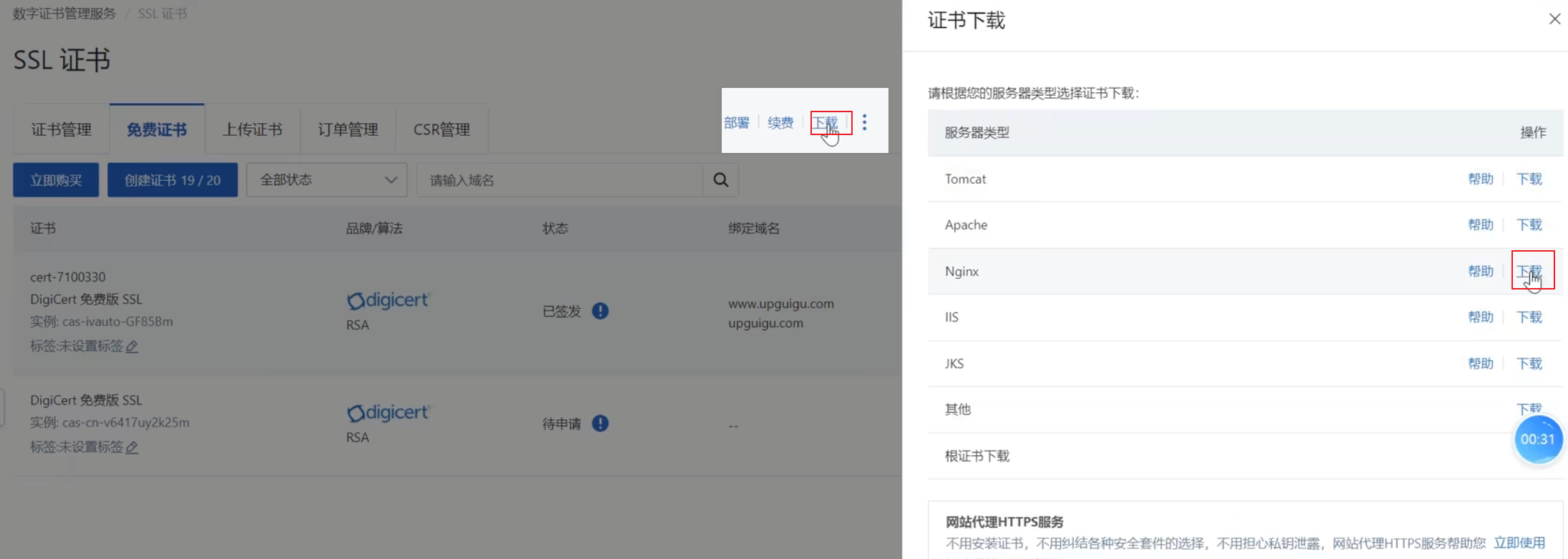

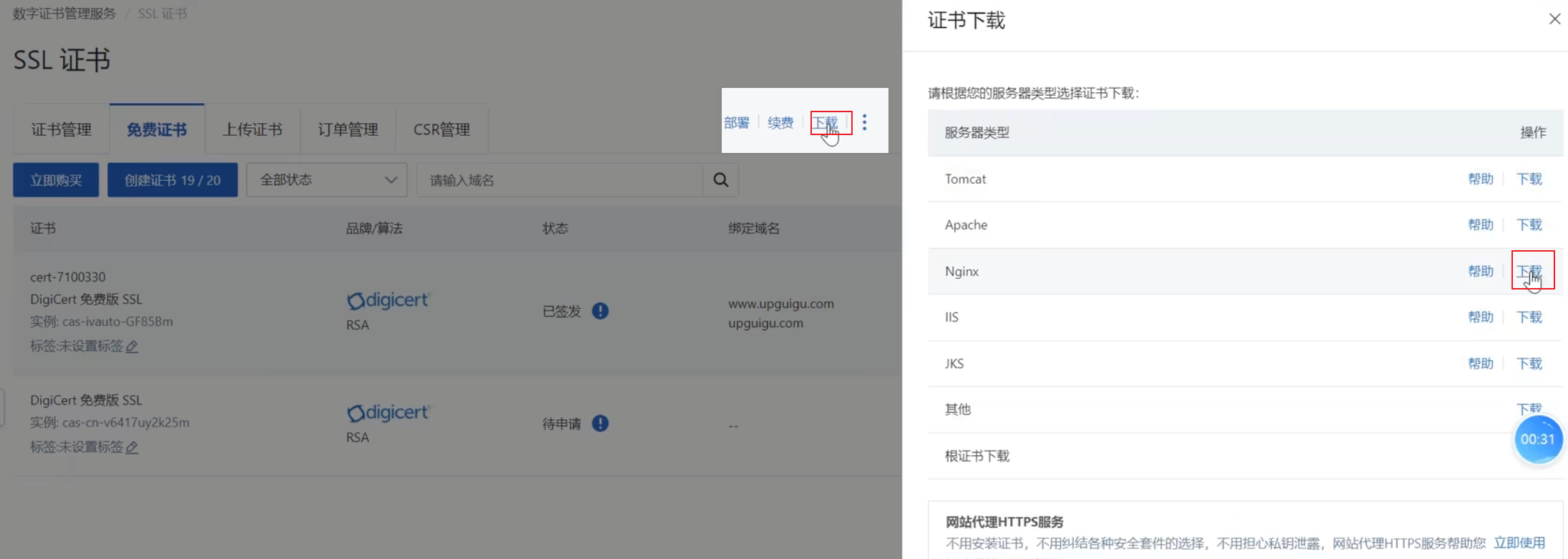

成功提交以后会显示申请审核中,审核成功后会显示已签发,签发速度极快,几秒钟就能签发

证书下载

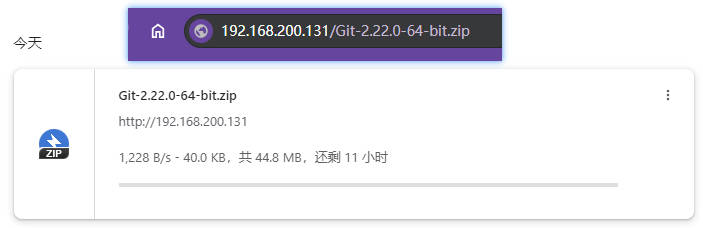

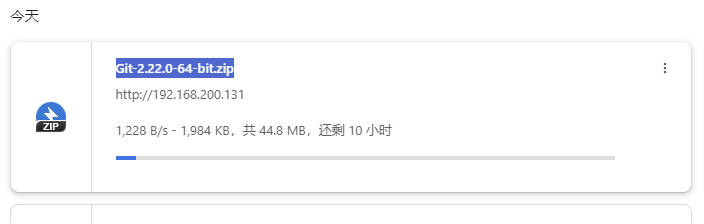

将证书下载下来传到服务器上,nginx的下载下来是一个zip压缩包

【证书文件】

一共有两个文件,以

.key结尾的文件是私钥,以.pem结尾的文件是证书,两个文件都要传到服务器上nginx的conf目录下,默认会从conf目录下找这两个文件

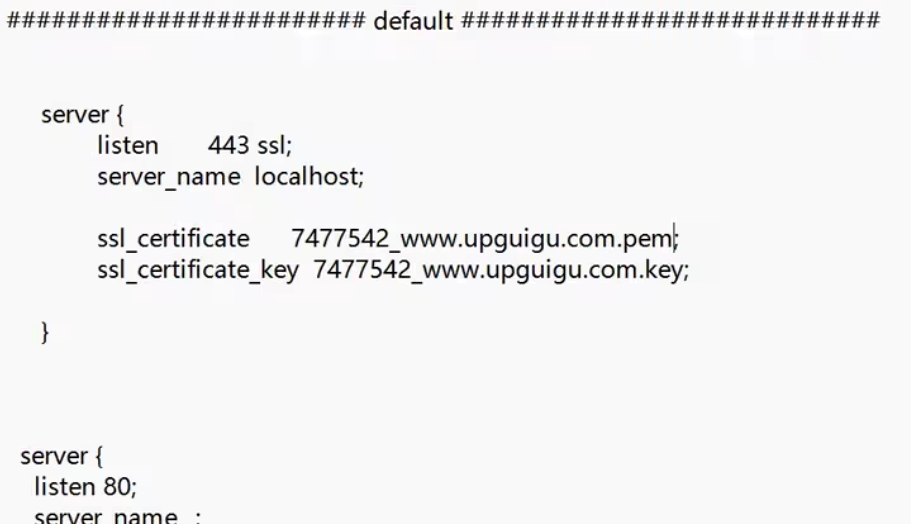

证书安装

直接复制粘贴到nginx.conf的server80服务器的同级,端口是443,ssl_certificate是证书的位置,使用相对路径【注意文件要在conf目录下】

xxxxxxxxxxserver{#所有的请求都会去443端口获取公钥listen 433 ssl;#这个名字localhost是因为没有其他域名写的server_name www.concurrency.cn;ssl_certificate CA认证文件的pem文件带后缀名称;ssl_certificate_key CA认证文件的key文件带后缀名称;}【证书安装】

重新加载nginx没报错就表示安装成功,此时输入

https://域名就会显示安全,http开头还是会显示不安全;这种配置如果二级域名不是www就会显示不安全

安装开源社区BBS

BBS就是Discuz,非常出名,国内的开源社区鼻祖,现在已经被腾讯收购,网站

https://discuz.dismall.com/【原网址已经被改了】很多的大型互联网网站bbs系统用的都是discuz,可以基于discuz进行二次改造,和现有系统进行集成,直接在官网下载安装:Discuz! X3.5 正式版【2023-10-01】 - Discuz! X 程序发布 - Powered by Discuz! (dismall.com)

discuz是PHP做的,但是可以和系统进行整合,整合之后系统相当于进行了一次升级,成为了异构系统【使用了不同的语言,不同的社群解决方案组成了一个大的系统】,还有其他很多有名的大型开源项目

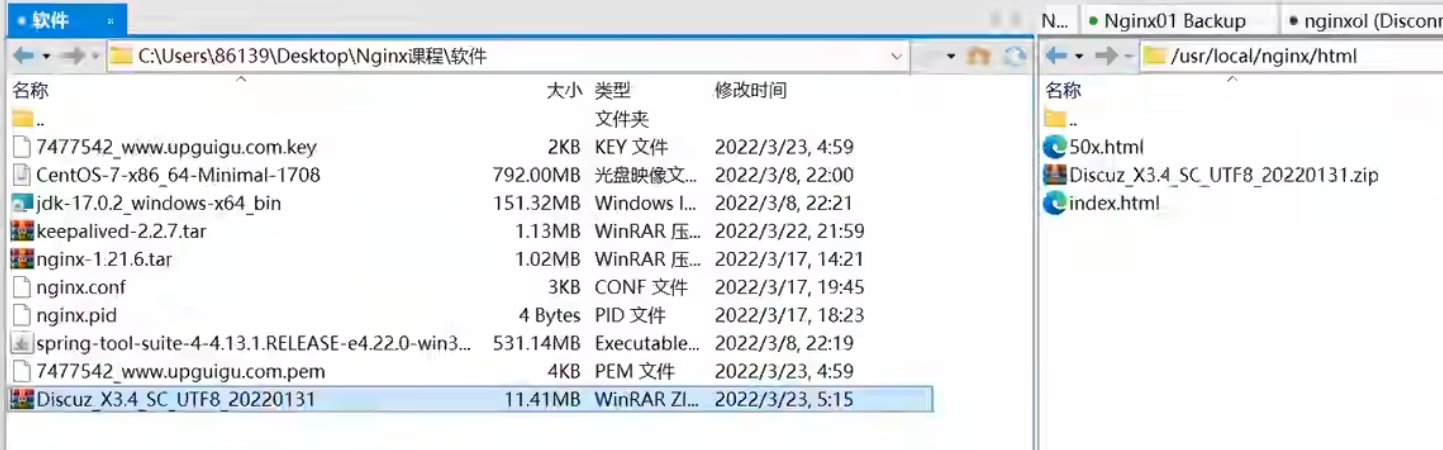

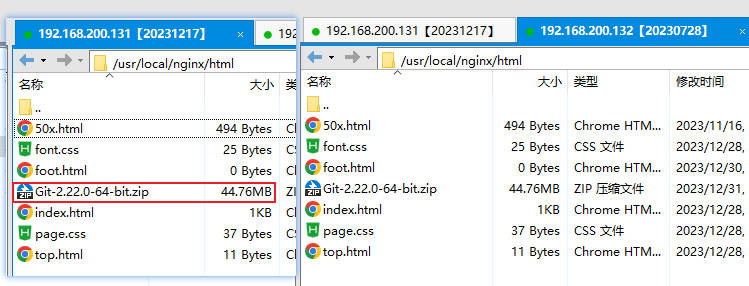

【上传discuz的zip文件到nginx的html目录】

上传Discuz_X3.4_SC_UTF8_20220131到nginx的html目录,类似这样的开源项目还有WordPress【国内外都非常出名】

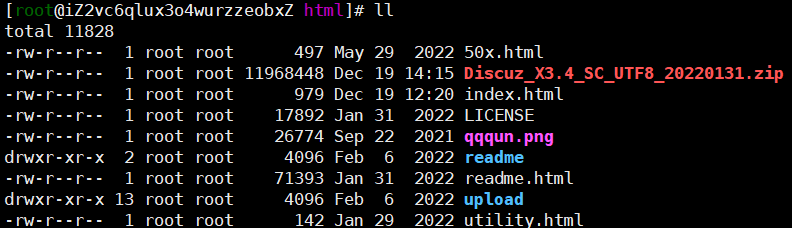

使用命令

unzip Discuz_X3.4_SC_UTF8_20220131.zip解压该安装包【解压后的文件】

bbs的安装不是在命令行安装的,是在线安装的,通过访问本机服务器地址来在本机的网站上进行安装

源码目录是upload目录,使用命令

mv upload/ bbs将upload目录改名为bbs

注意此时通过https访问安装目录

https://concurrency.cn/bbs/install/会失败,因为https默认会先访问443端口,但是443端口在nginx.conf文件中没有对该站点进行php环境的配置,所以直接访问该网址会失败;但是http的80站点,不访问443端口的URL:http://concurrency.cn/bbs/install/是可以使用的此时配置所有的请求都走https协议,将http协议下的PHP的所有配置移到443端口下

注意,似乎不是https会首次访问443端口,而是只会访问443端口,包括后续的请求;http才会始终访问80端口

【nginx.conf中80端口下php的相关配置】

xxxxxxxxxxuser www www;worker_processes auto;error_log /data/wwwlogs/error_nginx.log crit;pid /var/run/nginx.pid;worker_rlimit_nofile 51200;events {use epoll;worker_connections 51200;multi_accept on;}http {include mime.types;default_type application/octet-stream;server_names_hash_bucket_size 128;client_header_buffer_size 32k;large_client_header_buffers 4 32k;client_max_body_size 1024m;client_body_buffer_size 10m;sendfile on;tcp_nopush on;keepalive_timeout 120;server_tokens off;tcp_nodelay on;fastcgi_connect_timeout 300;fastcgi_send_timeout 300;fastcgi_read_timeout 300;fastcgi_buffer_size 64k;fastcgi_buffers 4 64k;fastcgi_busy_buffers_size 128k;fastcgi_temp_file_write_size 128k;fastcgi_intercept_errors on;#Gzip Compressiongzip on;gzip_buffers 16 8k;gzip_comp_level 6;gzip_http_version 1.1;gzip_min_length 256;gzip_proxied any;gzip_vary on;gzip_typestext/xml application/xml application/atom+xml application/rss+xml application/xhtml+xml image/svg+xmltext/javascript application/javascript application/x-javascripttext/x-json application/json application/x-web-app-manifest+jsontext/css text/plain text/x-componentfont/opentype application/x-font-ttf application/vnd.ms-fontobjectimage/x-icon;gzip_disable "MSIE [1-6]\.(?!.*SV1)";##Brotli Compression#brotli on;#brotli_comp_level 6;#brotli_types text/plain text/css application/json application/x-javascript text/xml application/xml application/xml+rss text/javascript application/javascript image/svg+xml;##If you have a lot of static files to serve through Nginx then caching of the files' metadata (not the actual files' contents) can save some latency.#open_file_cache max=1000 inactive=20s;#open_file_cache_valid 30s;#open_file_cache_min_uses 2;#open_file_cache_errors on;log_format json escape=json '{"@timestamp":"$time_iso8601",''"server_addr":"$server_addr",''"remote_addr":"$remote_addr",''"scheme":"$scheme",''"request_method":"$request_method",''"request_uri": "$request_uri",''"request_length": "$request_length",''"uri": "$uri", ''"request_time":$request_time,''"body_bytes_sent":$body_bytes_sent,''"bytes_sent":$bytes_sent,''"status":"$status",''"upstream_time":"$upstream_response_time",''"upstream_host":"$upstream_addr",''"upstream_status":"$upstream_status",''"host":"$host",''"http_referer":"$http_referer",''"http_user_agent":"$http_user_agent"''}';######################## default ############################server{#所有的请求都会去443端口获取公钥listen 433 ssl;#这个名字localhost是因为没有其他域名写的server_name localhost;ssl_certificate CA认证文件的pem文件带后缀名称;ssl_certificate_key CA认证文件的key文件带后缀名称;}server {listen 80;server_name _;access_log /data/wwwlogs/access_nginx.log combined;root html;#从此处开始是http协议中包含PHP的配置index index.html index.htm index.php;#error_page 404 /404.html;#error_page 502 /502.html;location /nginx_status {stub_status on;access_log off;allow 127.0.0.1;deny all;}location ~ [^/]\.php(/|$) {#fastcgi_pass remote_php_ip:9000;fastcgi_pass unix:/dev/shm/php-cgi.sock;fastcgi_index index.php;include fastcgi.conf;}location ~ .*\.(gif|jpg|jpeg|png|bmp|swf|flv|mp4|ico)$ {expires 30d;access_log off;}location ~ .*\.(js|css)?$ {expires 7d;access_log off;}location ~ ^/(\.user.ini|\.ht|\.git|\.svn|\.project|LICENSE|README.md) {deny all;}location /.well-known {allow all;}#PHP的配置到此结束}########################## vhost #############################include vhost/*.conf;}【更改后的配置文件】

xxxxxxxxxxuser www www;worker_processes auto;error_log /data/wwwlogs/error_nginx.log crit;pid /var/run/nginx.pid;worker_rlimit_nofile 51200;events {use epoll;worker_connections 51200;multi_accept on;}http {include mime.types;default_type application/octet-stream;server_names_hash_bucket_size 128;client_header_buffer_size 32k;large_client_header_buffers 4 32k;client_max_body_size 1024m;client_body_buffer_size 10m;sendfile on;tcp_nopush on;keepalive_timeout 120;server_tokens off;tcp_nodelay on;fastcgi_connect_timeout 300;fastcgi_send_timeout 300;fastcgi_read_timeout 300;fastcgi_buffer_size 64k;fastcgi_buffers 4 64k;fastcgi_busy_buffers_size 128k;fastcgi_temp_file_write_size 128k;fastcgi_intercept_errors on;#Gzip Compressiongzip on;gzip_buffers 16 8k;gzip_comp_level 6;gzip_http_version 1.1;gzip_min_length 256;gzip_proxied any;gzip_vary on;gzip_typestext/xml application/xml application/atom+xml application/rss+xml application/xhtml+xml image/svg+xmltext/javascript application/javascript application/x-javascripttext/x-json application/json application/x-web-app-manifest+jsontext/css text/plain text/x-componentfont/opentype application/x-font-ttf application/vnd.ms-fontobjectimage/x-icon;gzip_disable "MSIE [1-6]\.(?!.*SV1)";##Brotli Compression#brotli on;#brotli_comp_level 6;#brotli_types text/plain text/css application/json application/x-javascript text/xml application/xml application/xml+rss text/javascript application/javascript image/svg+xml;##If you have a lot of static files to serve through Nginx then caching of the files' metadata (not the actual files' contents) can save some latency.#open_file_cache max=1000 inactive=20s;#open_file_cache_valid 30s;#open_file_cache_min_uses 2;#open_file_cache_errors on;log_format json escape=json '{"@timestamp":"$time_iso8601",''"server_addr":"$server_addr",''"remote_addr":"$remote_addr",''"scheme":"$scheme",''"request_method":"$request_method",''"request_uri": "$request_uri",''"request_length": "$request_length",''"uri": "$uri", ''"request_time":$request_time,''"body_bytes_sent":$body_bytes_sent,''"bytes_sent":$bytes_sent,''"status":"$status",''"upstream_time":"$upstream_response_time",''"upstream_host":"$upstream_addr",''"upstream_status":"$upstream_status",''"host":"$host",''"http_referer":"$http_referer",''"http_user_agent":"$http_user_agent"''}';######################## default ############################server{#所有的请求都会去443端口获取公钥listen 433 ssl;#这个名字localhost是因为没有其他域名写的server_name localhost;ssl_certificate CA认证文件的pem文件带后缀名称;ssl_certificate_key CA认证文件的key文件带后缀名称;#从此处开始是http协议中包含PHP的配置,没有index.php也会去找index.php,优先级从前到后,前面的文件找不到就去找后面的index index.html index.htm index.php;#error_page 404 /404.html;#error_page 502 /502.html;location /nginx_status {stub_status on;access_log off;allow 127.0.0.1;deny all;}location ~ [^/]\.php(/|$) {#fastcgi_pass remote_php_ip:9000;fastcgi_pass unix:/dev/shm/php-cgi.sock;fastcgi_index index.php;include fastcgi.conf;}location ~ .*\.(gif|jpg|jpeg|png|bmp|swf|flv|mp4|ico)$ {expires 30d;access_log off;}location ~ .*\.(js|css)?$ {expires 7d;access_log off;}location ~ ^/(\.user.ini|\.ht|\.git|\.svn|\.project|LICENSE|README.md) {deny all;}location /.well-known {allow all;}#PHP的配置到此结束}server {listen 80;server_name _;access_log /data/wwwlogs/access_nginx.log combined;root html;}########################## vhost #############################include vhost/*.conf;}将http协议的请求转发到443端口

http协议跳转https,一般服务器上都是这样配置的,在80站点下添加如下配置

此时任何http协议请求都会自动跳转到https上

xxxxxxxxxxserver {listen 80;#站点域名server_name www.concurrency.cn concurrency.cn;access_log /data/wwwlogs/access_nginx.log combined;#该配置实现http协议跳转https协议,server_name是当前的域名,即用户访问的是哪个域名就跳到哪儿,也就是当前80站点配置的域名,重定向的协议是https协议,request_uri是用户实际请求的urireturn 301 https://$server_name$request_uri;root html;}安装

在html目录下使用命令

chmod -R 777 bbs/将目录权限设置为可写状态,学习环境为了方便可以直接改成777,生产环境不要这么做,要根据用户需求设定具体的权限【生产环境的权限配置比较复杂,需要根据实际情况来】,更改以后刷新页面可以观察到当前状态全部变成绿色注意不需要创建目录,只需要更改bbs的权限即可

【数据库配置】

数据库会自动帮助用户创建对应自定义名字的数据库,管理员账户和密码需要自己设置,该过程比较慢,耐心等待,成功了会显示论坛已完成安装,此时自己网站上的bbs论坛系统就可以正常使用了,可以测试一下发帖

后台管理在管理中心,需要输入管理员账户和密码进行登录,功能很多

系统扩容

原有的用nginx构建的站点在运行过程中可能会产生一些瓶颈【内容越来越多,访问频次越来越高】,拉低用户的体验,此时需要用扩容来实现让系统支持更高的并发量和吞吐量

扩容方式有:单机垂直扩容、水平扩展、细腻度拆分、数据异构化、服务异步化;这里只重点讲了单机垂直扩容

扩容的原则:无状态原则和弹性原则

实际上从这里开始到多级缓存都在讲扩大系统对并发请求容量的各种手段和扩容衍生出来的一系列问题的解决手段

扩容方式

单机垂直扩容

简单粗暴直接增加硬件资源,类似一个井使用的人多了,水不够用把井打的更深;这种方式存在瓶颈,当一个井不够用了,再怎么深挖都不能解决问题【比如人太多了,只有一口井不停地打水还是不能让每个人都分到水】,这种一次性增加的成本或者资产从老板角度来看可能比招几个资深程序员来优化系统要更省钱

对云服务资源的增加,比如项目部署在云服务器上,可以通过增加云服务器的配置【换更高性能的磁盘、增加CPU的核数、增加内存】

自建机房或者云服务的可以考虑提升硬件质量,比如选用更好的产品来增加系统的并发度【知名品牌的高性能服务器厂商有IBM、浪潮、DELL、HP】

将CPU/主板更新到主流的产品

网卡:很多时候系统的瓶颈不是硬件瓶颈,是网络上的瓶颈,网络瓶颈可以通过购买更高的带宽解决【现在的网卡不局限于百兆、千兆;还有万兆即10G/40G的网卡,带宽特别高的网卡非常稀缺,一般还需要特定的渠道才能买的到】,还可以在主板上增加网口和网卡的个数【一个主板不止能插一个网卡,一个操作系统上也可以有不止一个IP地址】,可以通过串行和并行的方式,串行是流量通过多个网口接入系统后汇集到一块;并行的方式是指配置多个IP地址【貌似也是在主板上插入两块网卡】,服务器的一个网卡可以接入电信的网络,另一个网卡接入联通的网络,两个网卡的IP地址不同;流量的串行和并行都是非常成熟的方案,这也是网络工程师一般去做的事;网卡除了提升带宽来提升网络性能,现在的网卡还会内置芯片,提升网卡对数据包,网络请求在经过网卡时就进行初步处理,减少操作系统的工作

磁盘:磁盘控制系统内部数据的传输熟读,常见的磁盘种类:SAS(SCSI)HDD(机械)、HHD(混合)、SATA SSD、PCI-e SSD、MVMe SSD【MVMe是协议,MVMe SSD的速度和效率是最高的,相比如HDD的各种磁盘在读取和写入的速度上都是指数级别的提升】,在服务器上对磁盘的要求更多的是随机读取的效率,一般nginx部署在服务器上主要提供静态网页的资源,网页在磁盘上的读取一般都是随机的读取【因为无法预测用户究竟想要哪个网页】,随机读取方面还是SSD的速度比HDD的速度要高得多的多,但是HDD磁盘也是非常常见的,因为这种磁盘的可靠性会比较高7200转,服务器用的HDD一般是一万转或者一万五千转,转速越快磁头到磁盘的寻址速度就越快,转速快可能会导致故障率变高,HDD磁盘的故障一般都发生寻址过程中,磁盘栈的越快,磨损的几率就越高,一旦磁盘上盘片磨损,就会产生坏道,就可能导致磁盘中数据的丢失,HDD磁盘在服务器上还是比较主流,就是可靠性比较高,但是磁盘速度越快,出现坏道的概率就越大,而且一般转速高容量大的磁盘会比较贵

SSD速度快,故障率高,过热、读取写入频次过高,使用时间太长都会导致故障,故障可能会导致全盘数据丢失,一般将SSD作为系统主盘【系统盘】,并在SSD上存储热点数据,将数据库mysql等安装在SSD上;由于SSD容易发生故障的原因,一般都采用多副本机制,将SSD上的数据采用多副本的方式进行冗余存储【也有备份的比较成熟的方案raid5,多副本机制的实现有同时写入,单一读取;也有同时写入,同时读取的方式】,一般的公司都会在内网中对线上服务器中的数据再做一次备份

HDD比较适合冷数据的存储,也适合大文件的存储,因为单位容量成本低【用来存储电影数据等】

水平扩容

【集群化系统架构】

keepalived负责nginx服务器的高可用,后端服务器提供数据的统一称为上游服务器,流量接入层的服务器统一称为中游服务器,集群中的每台上游服务器中运行的代码都是一样的,分布式系统和单一的集群系统的区别是分布式系统中系统功能被拆分到多个服务器中,这些特定的服务器负责特定的服务,分布式系统中不一定有集群;单一的集群系统是每个服务器都是一个完整的系统,集群内的每台服务器都是一样的,集群是分布式系统的子集

nginx可以通过proxy_pass和UpStream关键字将用户请求中转到上游的集群服务器

在原来的单机系统垂直扩容基础上提供集群化增加更多机器的方式来整体对外提供服务,优点是成本低

集群化比单机扩容还要廉价,投入包含买服务器,研发和运维成本,单机提升达到一定程度的时候再增加单机硬件水平成本会格外的高【比如非常好的内存条可能主板不兼容,还需要更换主板】,更常见的是通过软件的手段提升系统的性能,在系统集群化配置的前提下:可以使用以下方式来分发请求

细粒度拆分

分布式,将已经集群化的系统通过数据分区【将一个nginx上存储的过多的文件,将文件拆分成几块分布在不同的nginx服务器上】、上游服务SOA化【SOA:面向服务做技术架构,主要针对后端的应用服务器,将原本庞大的单体系统拆分成更加细腻度、特定模块提供特定服务的分布式系统架构,这些模块运行在单独的服务器上,SpringCloud和Dubbo都属于SOA的一部分,nginx对这些细腻度的每个模块都单独进行代理】、入口细分【入口有浏览器、移动端原生APP和物联网应用、H5内嵌式应用,配置根据用户的请求入口来访问不同的nginx服务器达到分流的效果】再拆分成分布式的系统

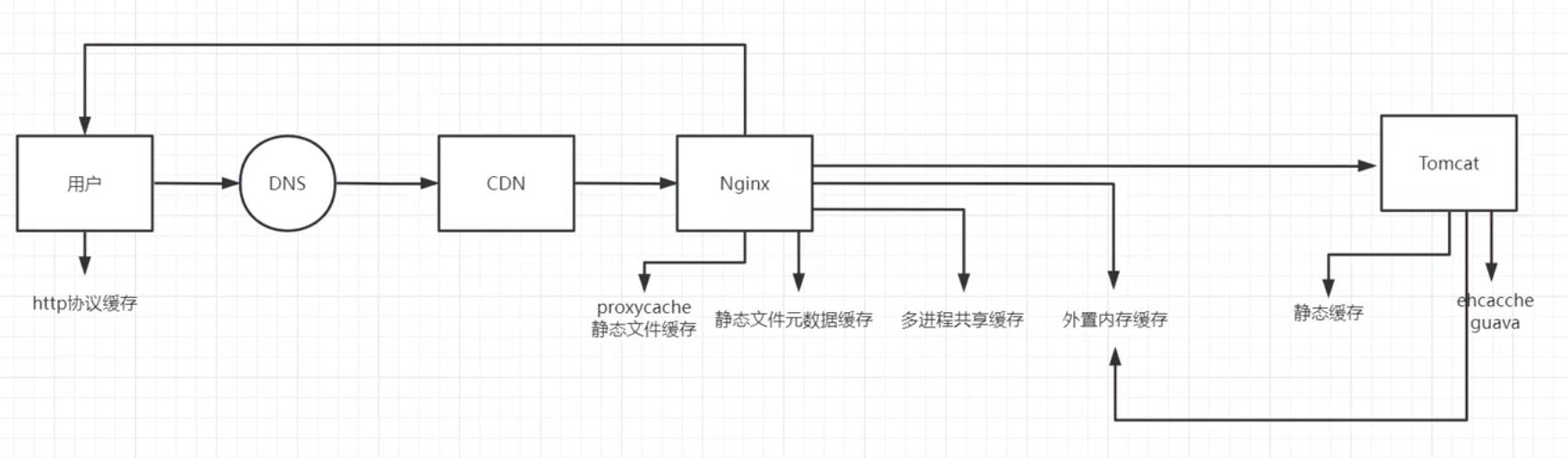

数据异构化

最初是把nginx作为静态资源的主要载体,数据库和tomcat服务器作为对计算数据文件的存储载体;数据异构化是将数据进行拆分分布在不同的对象上【客户端、CDN、nginx服务器、DB、web服务器】;数据异构化中的一种方式就是做多级缓存,将缓存数据拆分分别做客户端缓存、CDN缓存、异地多活【把数据和缓存放在多个物理的空间如不同地区的机房去存储】、Nginx缓存后端服务器数据【nginx既可以做动静分离,还可以做动态数据的缓存】

服务的异步化

同步:用户从发起请求,请求数据通过网络传递、服务器处理响应到数据渲染,用户一直在等待的过程称为同步

异步:用户请求到服务器后针对需要长时间处理的请求,如上传下载文件可以先简单的给用户一个响应,让用户可以做其他事情,等真正处理完成后再把结果响应并通知到用户

服务异步化的实现方式:拆分请求【用户下载请求拆分成第一次查询文件大小并选择普通下载还是多线程下载;又比如比较复杂的用户信息填写使用下一步按钮引导的方式让用户完成填写,而不是一股脑的把表单丢给用户】、消息中间件

会话管理

依靠nginx自身的配置对集群化的会话管理在扩容方式的水平扩容中已经进行了介绍,以下介绍利用第三方

水平扩容会话管理

nginx自身对服务器集群会话的管理的配置

非分布式的集群化系统上游服务以Tomcat服务器为例,会保存用户登录的信息即session在服务器中,集群中的其他服务器没有这个session,也就没有相应的会话信息,维持用户会话状态的方案有以下几种

Redis+SpringSession:这是使用上游服务器自身提供的功能来维持会话,SpringSession是一个框架,会把用户的会话状态存储在Redis中,这是通过java来保持用户的会话,但是这种方式由于java的性能相比于nginx偏低,此外还需要额外增加服务器,此外如果上游服务器比较多,此时redis一台服务器很可能不堪重负,整体系统设计的复杂度也会非常高;如果使用nginx解决这个问题,就可以省去很多为了维持会话导致的额外开销

ip_hash:主要是为了在非分布式的集群系统中维持用户会话【其实之前已经讲过】,原生开源版本自带,根据客户端IP地址通过哈希算法得到定值,用哈希值对上游服务器取模将请求定向转发到一台服务器上【一致性哈希】,这里面存在一个问题,类似于网吧、学校、稍微大一些的公司或宽带用户共用一个IP地址,可能导致大量的请求取到一个哈希值,全被转发到一个服务器上,造成流量严重倾斜,这种方式特别不适合运行在局域网中的系统,如企业中的ERP、校园中的教务系统、考试系统【考生集中在几个学校考试,一共就只有几个IP】,但是分发效率很高,能够避免像用Redis+SpringSession的额外开销

除此以外,用户使用过程中如果发生服务器宕机的情况,用户的会话状态也会直接消失

这种ip_hash方式的应用场景一般是中小型项目初期的快速扩容,不想改代码,只需要添加机器就能立即扩大系统的并发度,用nginx来做流量分发原代码根本不需要改;如果使用SpringSession需要改代码,打包测试一系列操作

缺点:一旦服务器出现宕机,服务器中的会话状态就会丢失,尤其在与钱有关的系统中,所有分步操作都没有持久化全部保存在内存或者session中的情况下,请求在机器宕机后被转发到其他机器中,操作还能继续,但是此前的操作全部丢失,用户的体验极差

模拟使用ip_hash负载均衡策略做会话管理的配置

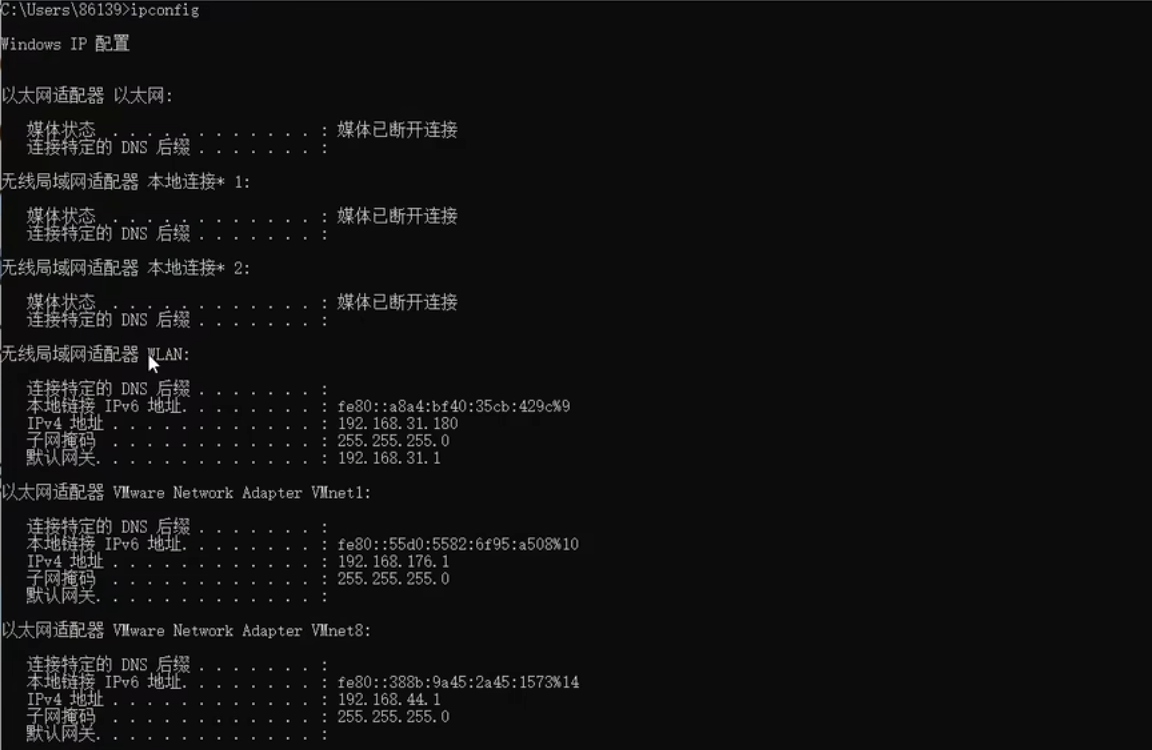

使用3台nginx模拟集群情况下的会话管理情况,一台131做代理服务器,另外两台132和133做上游服务器

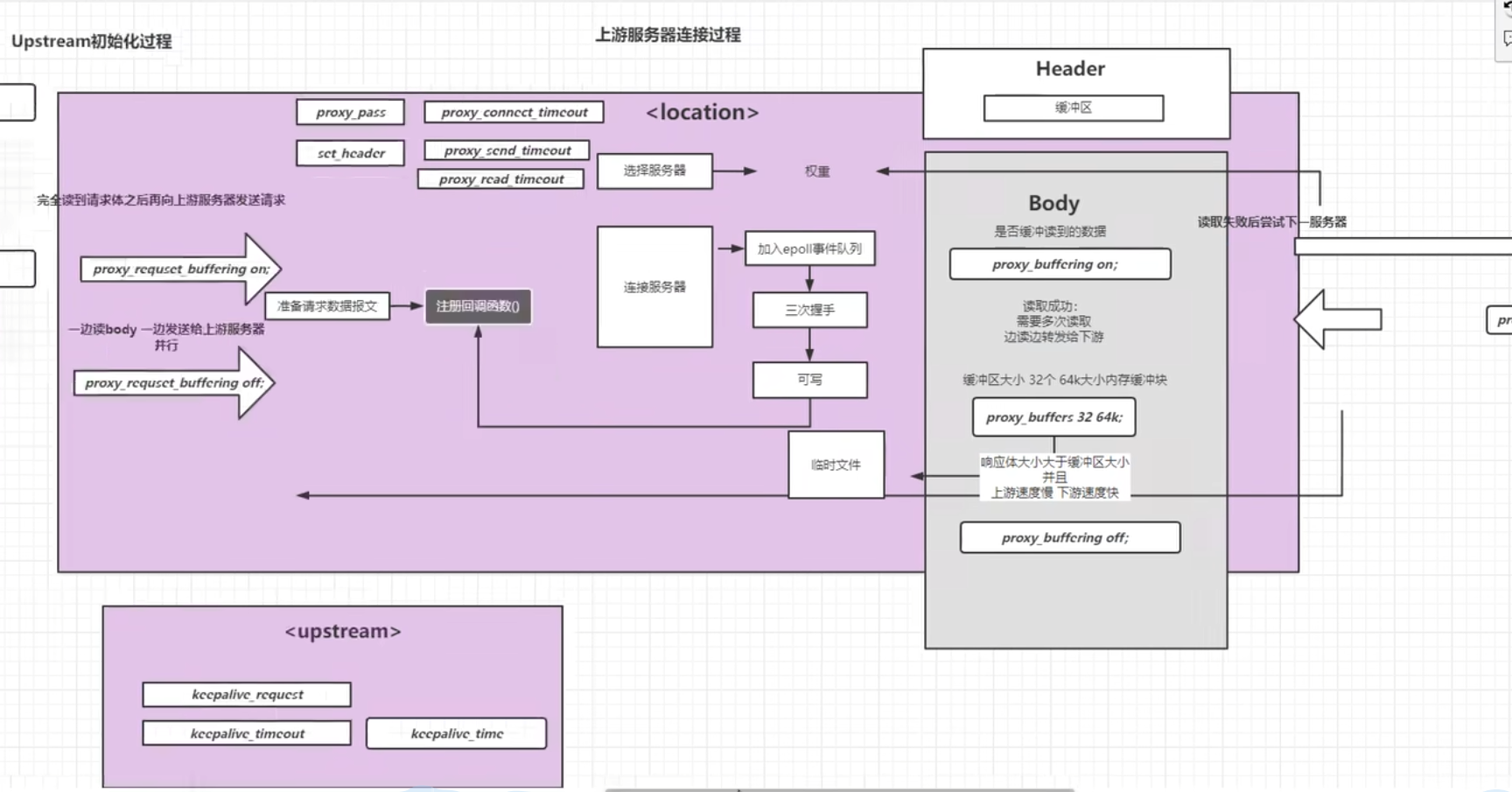

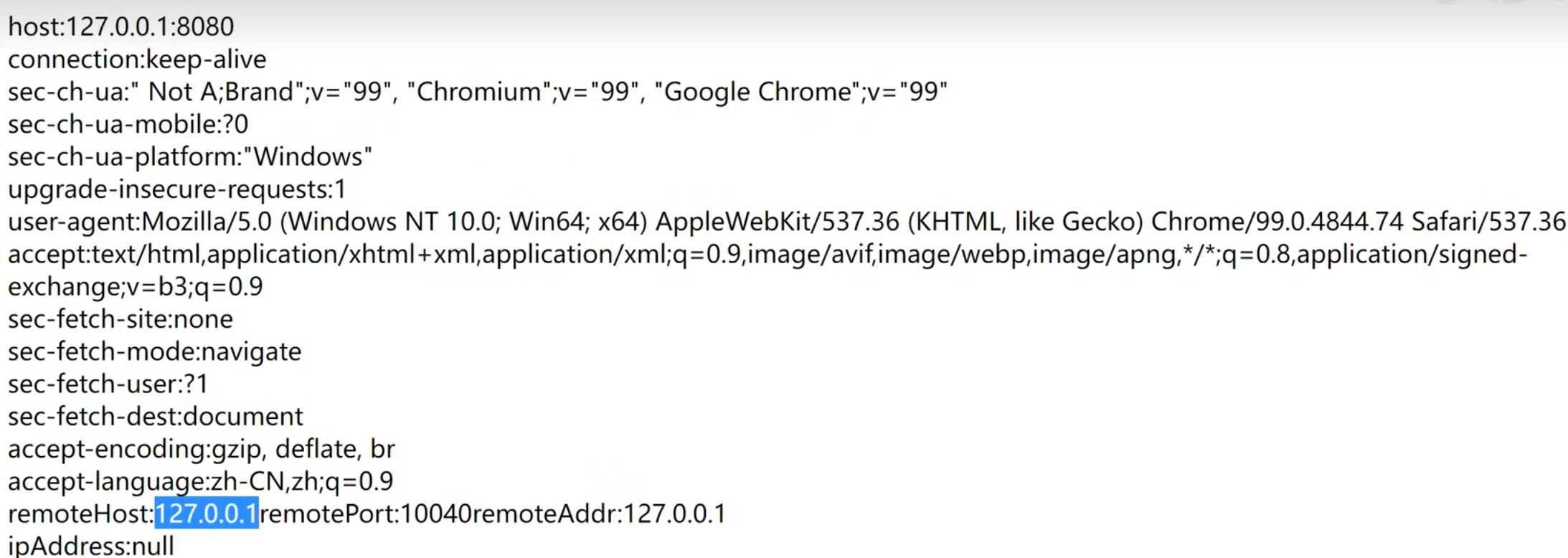

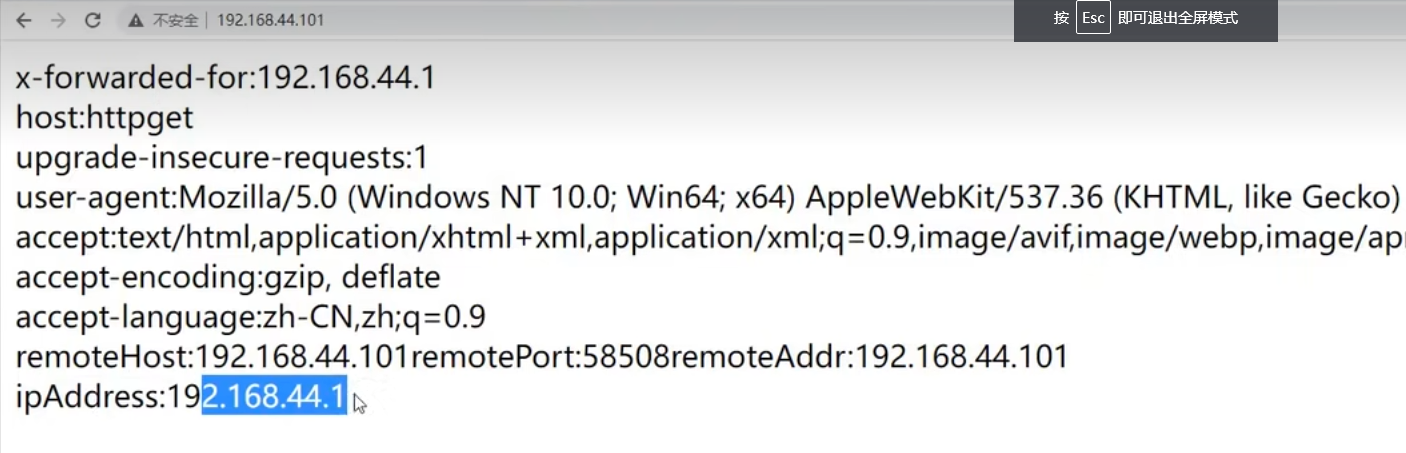

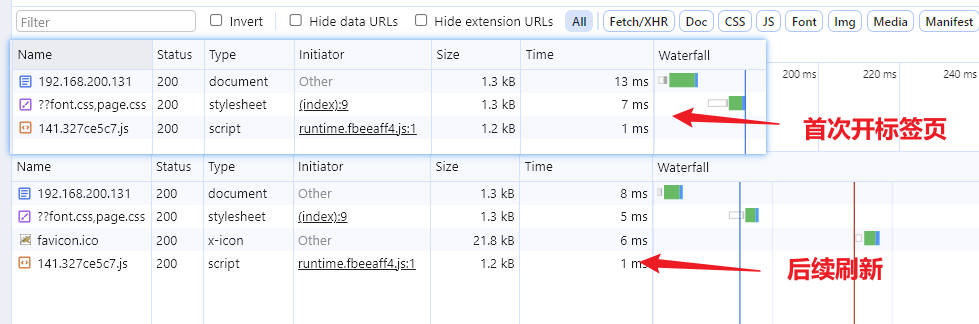

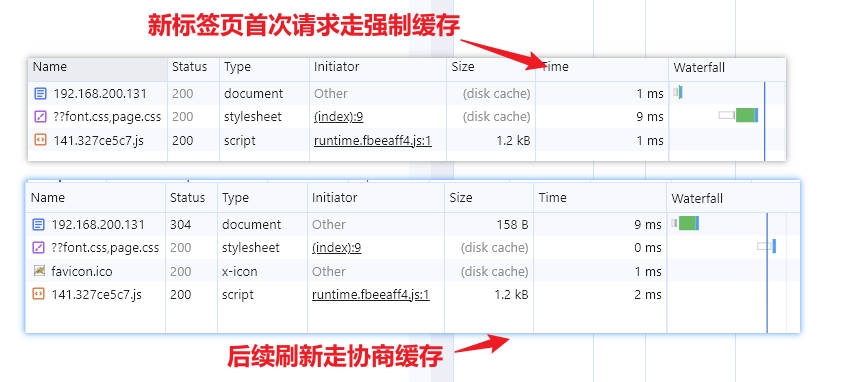

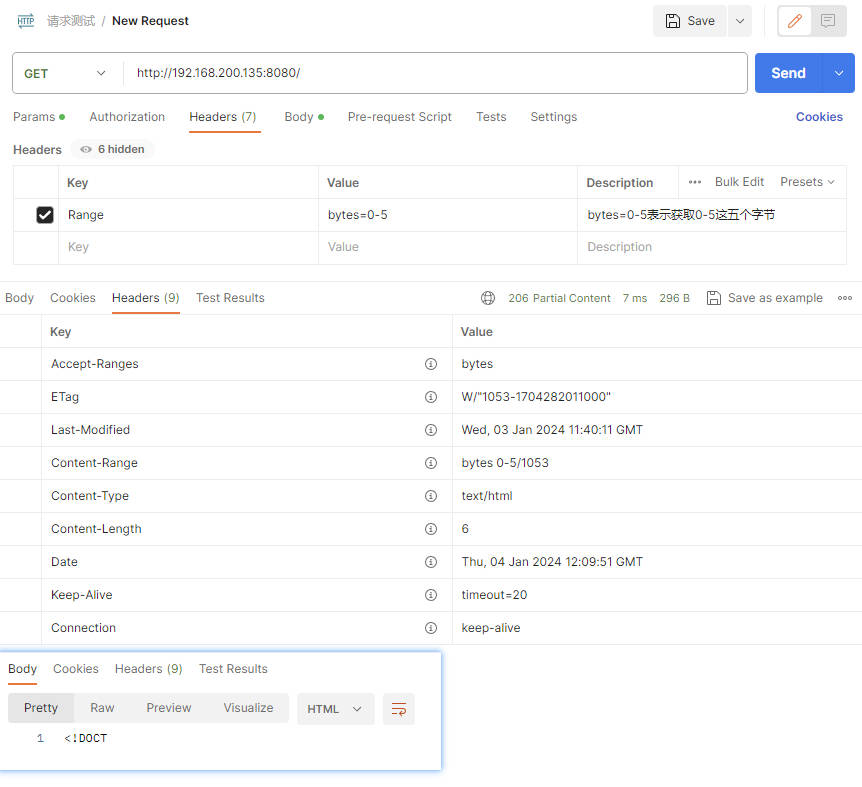

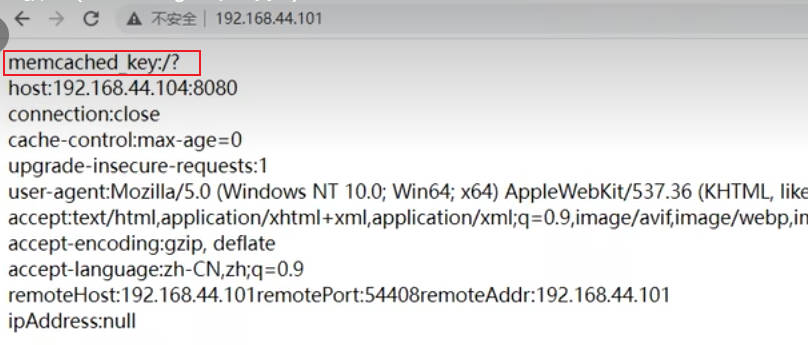

【代理服务器的nginx.conf】